Di questo progetto si parla su base teorica dal 2017 e si basa su quello che può essere definito Multi-Chip Module GPU (MCM-GPU), ossia l'uso di diversi moduli GPU su un singolo package. Stando a quanto riportato dal sito giapponese PC Watch (via PCGameN), l’attuale prototipo ha superato il tape out presso TSMC con processo produttivo a 16 nanometri, lo stesso usato per le GeForce serie 10.

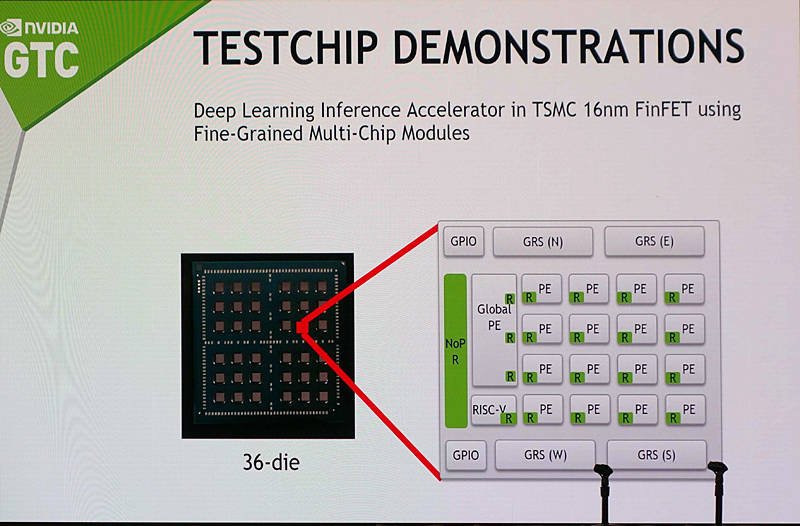

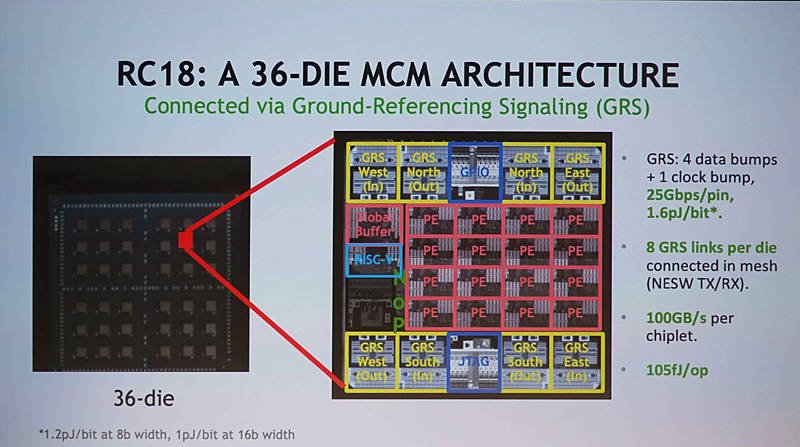

Sul package di questo prototipo si contano 36 piccoli moduli, ognuno formato da 16 PEs (Processing Elements), un core RISC-V Rocket, buffer di memoria e otto collegamenti GRS (Ground-Referenced Signaling) per un bandwidth di I/O totale per chip pari a 100 GB/s. Nel complesso ogni singolo chip è formato da 87 milioni di transistor.

“Abbiamo dimostrato un prototipo di ricerca come esperimento per rendere scalabile il deep learning”, ha affermato Bill Dally, capo di Nvidia Research, nel corso della GTC 2019. "Si tratta di un tape out recente, attualmente in fase di valutazione. Stiamo lavorando su RC 18, che significa ‘the research chip of 2018’. Si tratta di un acceleratore per il deep learning che può scalare da una dimensione molto piccola, e ha 16 PE su un piccolo die".

“Questo chip ha il vantaggio di essere in grado di dimostrare diverse tecnologie”, ha aggiunto Dally. “Una delle tecnologie è un’architettura deep learning scalabile. L’altra è una trasmissione die-to-die su un substrato organico molto efficiente”.

Insomma, da questo progetto di ricerca potrebbero nascere prima gli acceleratori di IA del futuro e successivamente anche potenti schede video gaming, qualora questo design dovesse diventare “uno standard”. L’adozione di un progetto MCM, oltre ad aumentare le prestazioni, potrebbe velocizzare anche i tempi di progettazione e forse contenere anche i consumi.

Nvidia attualmente usa una propria tecnologia d’interconnessione chiamata NVLink per collegare ad alta velocità diverse GPU, ma recentemente ha acquisito Mellanox, specialista nei collegamenti ad alta velocità nel campo dei datacenter. Le conoscenze ottenute potrebbero risultare importanti anche per il progetto MCM.

Nvidia però non è l’unica che sta lavorando a un’architettura di calcolo altamente scalabile. Anche AMD ci sta pensando, con l’attuale boss della divisione RTG, David Wang, che ha affermato come sia semplicemente prematuro accostare un design simile alle GPU gaming, senza però escluderne l’applicazione in altri ambiti.

Raja Koduri, colui che si sta occupando dello sviluppo delle nuove GPU dedicate di Intel in arrivo nel 2020, ha più volte parlato in passato di progetti MCM, sottolineando come possano rappresentare il futuro delle GPU.