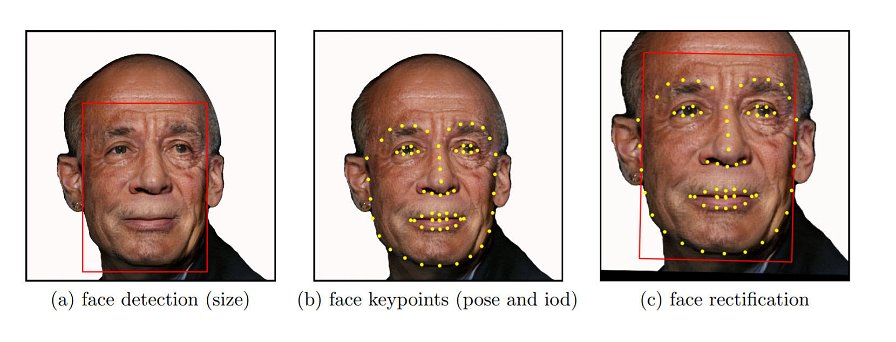

Il problema dei pregiudizi negli algoritmi di Intelligenza Artificiale è sempre più sentito, ed è ormai entrato nelle agende di tutte le aziende che operano con questo tipo di tecnologia. IBM, per contrastare i problemi di equità relativi al riconoscimento facciale, ha deciso di pubblicare il dataset Diversity in Faces (DiF). Un'azione che, sostiene l'azienda, mira al "miglioramento negli studi sull'equità e la precisione delle tecnologie di riconoscimento facciale".

L'archivio include circa un milione di volti in file annotati, vale a dire che per ogni file una persona ha aggiunto dei valori coerenti per indicare colore della pelle, sesso, forma del volto e così via. IBM ha usato come fonte il database YFCC-100M, e poi si è affidata a 10 diversi schemi approvati per le annotazioni.

"Crediamo che estrarre e pubblicare le annotazioni su un data set di un milione di volti farà accelerare lo studio della diversità e l'ampiezza dei dati per i sistemi di riconoscimento facciale, per assicurare la creazione di sistemi AI più giusti e accurati. La pubblicazione di oggi è solo il primo passo".

Il dataset creato da IBM vuole quindi essere la base di partenza, o ripartenza, per gli studi sul riconoscimento facciale. Le prime analisi, svolte dalla stessa IBM, suggeriscono che DiF offre "una distribuzione più bilanciata e una copertura più ampia di immagini rispetto ai data set precedenti. Inoltre, le informazioni ottenute dalla analisi statistiche [...] ci hanno permesso di approfondire la nostra comprensione riguardo ciò che è importante nella caratterizzazione di un volto umano".

Già, ma perché tutto questo sforzo? A cosa servono sistemi di riconoscimento facciale più precisi e più giusti? Fermandosi alla superficie, si può intuire facilmente che IBM vuole un prodotto migliore per poterlo vendere a prezzi più alti e a più clienti. Le Forze di Sicurezza del mondo, per esempio, non hanno alcun interesse in sistemi che generano troppi falsi positivi e fanno perdere tempo. Considerando questi strumenti come servizi, invece, è abbastanza chiaro che lasciar fuori miliardi di persone (essenzialmente chi non è un maschio caucasoide) significare rinunciare a un mercato potenzialmente molto grande.

E ci sono anche, naturalmente, le questioni etiche. Che si tratti di IBM, di Amazon, di Google o chiunque altro, ai dirigenti delle multinazionali non fa piacere che l'azienda abbia fama di razzista, giustificata o meno che sia. E le giustificazioni non mancano: l'anno scorso, per esempio, una ricerca dimostrò come i sistemi di Google, Microsoft e IBM avessero un margine di errore più grande del 34% nelle donne con la pelle scura, rispetto agli uomini di carnagione chiara - un recente aggiornamento dello studio mostra che la situazione è migliorata, ma c'è ancora molto lavoro da fare.

A tal proposito, è nato anche uno strumento specifico, che è diventato velocemente un vero e proprio benchmark per i sistemi di riconoscimento facciale: si chiama Gender Shades. Lo ha creato la ricercatrice del MIT Joy Buolamwini, che è anche, insieme ad altri, fondatrice del gruppo Algorithmic Justice League.

IBM ha dunque identificato correttamente il problema: gli algoritmi integrano pregiudizi perché li assorbono direttamente dai data set, cioè dalle informazioni usate per addestrare le Intelligenze Artificiali. E quando si tratta di applicare gli algoritmi alla vita delle persone, spesso e volentieri emergono pregiudizi che vorremmo eliminare. L'idea, infatti, è di posare su ognuno uno sguardo obiettivo, super partes e acritico; ma non è possibile se la macchina che dovrebbe farlo si è alimentata di soggettività e informazioni parziali.

"Il cuore del problema non è nelle tecnologie AI in sé e per sé, ma in come si addestrano i sistemi AI di riconoscimento facciale. Affinché il sistema si comporti come desiderato, e che i risultati siano sempre più precisi, i dati di addestramento devono essere variegati e avere una grande copertura".

L'approccio di IBM non è l’unico possibile. Al MIT, per esempio, un gruppo di ricercatori sta lavorando a un sistema avversativo, nel quale un secondo algoritmo controlla il primo alla ricerca di pregiudizio. Se rileva che un certo campione è sotto rappresentato, per esempio, innesca meccanismi per compensare. Non si può escludere che il secondo algoritmo sia esso stesso portatore di pregiudizi, ma si può lavorare alla ricerca di un equilibrio, e soprattutto ci sono situazioni già oggi che richiedono interventi in tempi brevi e brevissimi. I primi risultati sono stati incoraggianti, speriamo che si continui sulla stessa strada.