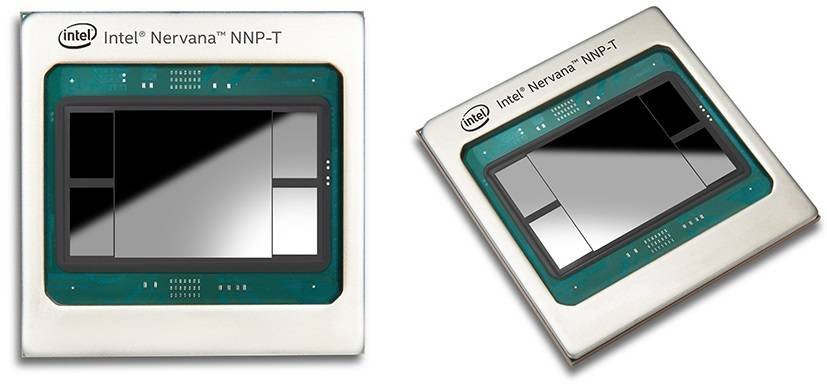

Intel schiaccia l’acceleratore nel settore dell’intelligenza artificiale con due nuovi chip Nervana NNP (Neural Network Processor), NNP-T100 e NNP-I1000, rispettivamente dedicati all'addestramento di IA e al calcolo inferenziale. L'azienda ha anche annunciato la nuova versione della VPU (Vision Processing Unit) Movidius, per applicazioni di computer vision e inferenza sui dispositivi finali (edge computing).

Secondo Intel, questi nuovi prodotti rafforzano il suo portfolio di soluzioni di intelligenza artificiale che dovrebbe generare oltre 3,5 miliardi di dollari di fatturato nel 2019.

"Con questa nuova fase dell'intelligenza artificiale, stiamo raggiungendo un punto di svolta in termini di hardware computazionale e memoria. Per proseguire con gli incredibili progressi nel campo dell’intelligenza artificiale, sono necessari prodotti hardware appositamente sviluppati, come i processori di rete neurale Intel Nervana NNP e le unità di elaborazione visiva Intel Movidius Myriad VPU. L'impiego di forme più avanzate di intelligenza artificiale a livello di sistema ci consentirà di passare dalla trasformazione dei dati in informazioni alla trasformazione di informazioni in conoscenza", ha dichiarato Naveen Rao, Intel corporate vice president e general manager dell'Intel Artificial Intelligence Products Group.

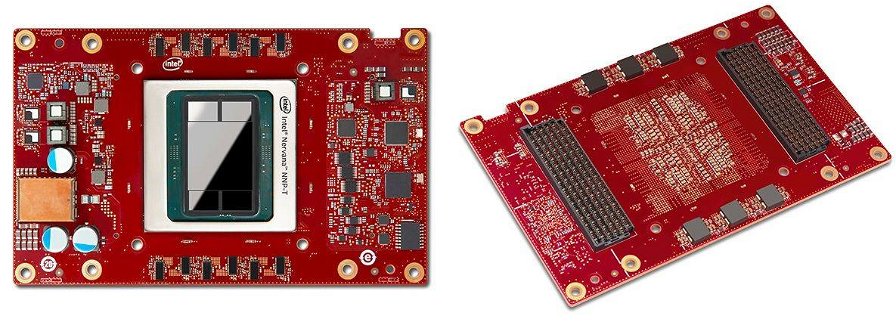

NNP-T1000, in particolare, fornisce “il giusto equilibrio tra potenza di calcolo, comunicazione e memoria” pur essendo adattabile ad ogni tipo di sistema, dai piccoli cluster fino ai supercomputer. NNP-T offre inoltre il 95% di scalabilità su sistemi come Res-Net 50 e BERT (su sistemi a 32 schede), con una perdita del bandwidth minima quando si passa da un sistema a otto schede "in chassis" a uno a 32 schede "cross-chassis".

Per spingere l'adozione dei nuovi chip, Intel ha sviluppato un progetto di riferimento che consiste di 10 rack e 480 schede NNP-T1000 interconnesse tra loro usando un'interconnessione proprietaria.

NNP-I1000, secondo Intel, è ideale per eseguire inferenze multimodali intensive su scala reale usando fattori di forma flessibili. Comparato con un server rack che sfrutta GPU Nvidia T4 per l’inferenza, lo stesso server dotato di Intel NNP-I1000 offre circa quattro volte la densità computazionale rispetto alla soluzione concorrente. "Ciò che abbiamo è il maggior numero di inferenze al secondo che si possano elaborare in una singola unità rack”, ha dichiarato Rao.

Entrambe le unità sono state sviluppate da Intel per clienti che hanno l’esigenza di elaborare enormi quantità di dati attraverso l’intelligenza artificiale, come Facebook o Baidu.

“Siamo entusiasti di lavorare con Intel per implementare calcoli di inferenza più rapidi ed efficienti con il processore di rete neurale Intel Nervana (NNP-I) ed espandere il supporto al nostro compilatore di deep learning Glow” ha affermato Misha Smelyanskiy, direttore dell'AI System Co-Design presso Facebook.

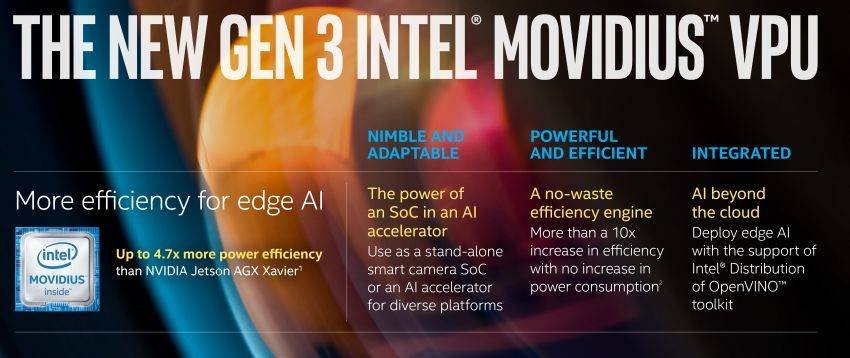

La nuova VPU Movidius, prevista per la prima metà del 2020, includerà avanzamenti architetturali estremamente efficienti, volti ad offrire prestazioni oltre 10 volte superiori alle prestazioni di inferenza della generazione precedente, con efficienza energetica fino a 6 volte superiore rispetto alle soluzioni della concorrenza.

Jonathan Ballon, vicepresidente del gruppo IoT di Intel, ha dichiarato che la nuova VPU Movidius offre prestazioni quattro volte migliori del chip Nvidia TX2 e le prestazioni sono pari al chip Xavier di Nvidia con un quinto dell'energia richiesta. Questo è importante perché i clienti guardano molto ai consumi, alle dimensioni e alla latenza, oltre che alle prestazioni.

Intel ha anche annunciato il nuovo Intel DevCloud for the Edge che, insieme alla distribuzione Intel del toolkit OpenVINO, risolve un aspetto cruciale per gli sviluppatori, consentendo loro di sperimentare, prototipare e testare soluzioni di intelligenza artificiale su un'ampia gamma di processori Intel prima di acquistare hardware. Secondo Ballon, oltre 2700 clienti stanno già usando Intel DevCloud e ne sono entusiasti.