Nel corso della International Supercomputing Conference di Francoforte, il vicepresidente e general manager dell’Enterprise and Government Group di Intel, il dottor Rajeeb Hazra, ha annunciato la disponibilità a partire da oggi di sistemi preconfigurati basati su processori Intel Xeon Platinum 9200 (piattaforma Cascade Lake-AP) presso OEM selezionati tra cui Atos, HPE, Lenovo, Penguin Computing, Megware e alcuni rivenditori autorizzati.

Dell’offerta Cascade Lake-AP avevamo già scritto nei particolari al lancio della seconda generazione degli Xeon Scalable: si tratta di una piattaforma di calcolo ad alte prestazioni e densità destinata al settore HPC, che si basa su processori formati da due die su un singolo package (dual-die MCM - Multi-Chip Module). Di conseguenza Intel ha raddoppiato il numero di core e dei canali di memoria per ottenere, in un formato minore, l’equivalente di un sistema dual-socket.

I processori Cascade Lake-AP mettono a disposizione fino a 56 core e 112 thread in un singolo package unendo due die XCC (eXtreme Core Count) da 28 core, ognuno con sei canali di memoria. Ci troviamo di fronte a processori BGA (Ball Grid Array), saldati direttamente sulle motherboard tramite interfaccia 5903-ball. Di conseguenza agli OEM tocca il compito di realizzare il progetto dei server, mentre per quanto riguarda le configurazioni di CPU e motherboard sono prestabilite da Intel.

Lo Xeon Scalable Platinum 9282 è il top di gamma con 56 core e 112 thread che operano a una frequenza di 2,6 / 3,8 GHz, offre 77 MB di cache L3 ed è accompagnato da un TDP di 400 watt (per cui necessita di un raffreddamento a liquido, mentre le altre soluzioni si possono raffreddare ad aria). Tutte le soluzioni Cascade Lake-AP offrono 40 linee PCI Express 3.0, anche se ogni die ne ha in realtà 64.

Intel ne usa infatti una parte per la connessione UPI (Ultra-Path Interconnect) che collega i due die all’interno del processore, mentre l’altra è dedicata alla comunicazione tra i due chip in un server dual-socket. Nel complesso questo garantisce quattro canali UPI per socket per un throughput totale di 10,4 GT/s.

Gli Xeon Platinum 9200 offrono 12 canali di memoria DDR4-2933. Nel caso di una configurazione a doppio socket si parla quindi di 24 canali di memoria per 3 TB di memoria DDR4 supportata (1,5 TB per socket, il doppio dei 768 GB degli Xeon Scalable di prima generazione), con un throughput fino a 407 GB/s.

In termini numerici i Cascade Lake-AP, secondo la casa di Santa Clara, raggiungono prestazioni di calcolo medie due volte maggiori rispetto a uno Xeon Platinum 8180, mentre migliorano fino a 30 volte le capacità con carichi di intelligenza artificiale. Sembra molto, e lo è, ma non è un risultato figlio del solo numero di core: i nuovi chip supportano la suite DL Boost, che aggiunge il supporto a molteplici funzionalità legate all’intelligenza artificiale.

La casa di Santa Clara vanta un miglioramento prestazionale di 14 volte nei carichi di inferenza, inoltre le nuove VNNI (Vector Neural Network Instructions) ottimizzano le istruzioni per i piccoli tipi di dati usati comunemente in machine learning e inferenza. Le istruzioni VNNI fondono tre istruzioni insieme per aumentare le prestazioni int8 (VPDPBUSD) e due istruzioni per incrementare quelle int16 (VPDPWSSD).

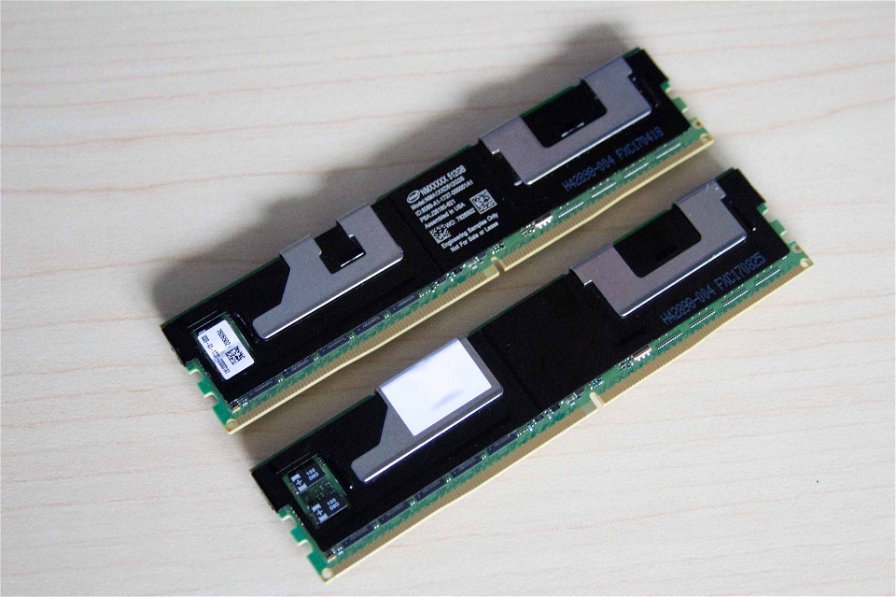

L’altro annuncio di Intel alla ISC ‘19 riguarda Optane DC Persistent Memory, cioè i moduli DIMM basati sulla velocissima memoria 3D XPoint. Questo tipo di soluzione, peraltro non supportata da Cascade Lake-AP (ma dai Cascade Lake Xeon Platinum 8200 sì), sta trovando applicazione nel mondo dei supercomputer e Intel ha parlato di alcuni dei risultati raggiunti dai partner.

Lo European Centre for Medium-Range Weather Forecasts (ECMWF) ha raggiunto un bandwidth 10 volte maggiore stoccando i dati meteorologici sulle previsioni a medio termine nella memoria persistente distribuita su più nodi di calcolo. In questo modo l’ECMWF è riuscito ad accelerare le proprie previsioni e a ridurre il numero di nodi di input e output necessari per i propri modelli. L’Arctur HPC Center, in partnership con il Barcelona Supercomputer Center, ha invece velocizzato di 2 volte la simulazione di modelli 3D di un aereo elettrico leggero, solo per citare due esempi fatti da Intel.

Intel sta inoltre accelerando l’adozione di Optane DC Persistent Memory nei sistemi HPC, anche grazie a una nuova architettura di archiviazione per il supercomputing che si basa proprio sui moduli DIMM 3D XPoint e sul Distributed Asynchronous Object Storage (DAOS). DAOS è un sistema “scale-out object store” open source, definito via software, che fornisce un bandwidth elevato, bassa latenza e alte operazioni di I/O, pensato per eliminare diverse limitazioni degli attuali file system paralleli.

Il sistema di archiviazione DAOS troverà spazio in Aurora, il primo supercomputer exascale statunitense in arrivo nel 2021, secondo le parole di Susan Coghlan, project director/exascale computing systems deputy director dell’Argonne Leadership Computing Facility.

Per concludere, Intel è tornata a ribadire il pieno impegno nel progetto One API, che offre un modello di programmazione unificato per semplificare lo sviluppo di applicazioni tra differenti architetture di calcolo (CPU, GPU, FPGA, ecc.). Open API di Intel sarà basata su “standard industriali e specifiche aperte e sarà interoperabile tra gli altri con OpenMP, MPI e Fortran”.