Durante l’Adobe MAX 2019 abbiamo intervistato Maria Yap, VP Digital Imaging, per capire meglio i trend attuali e futuri di Adobe e i suoi software dedicati ai Creators.

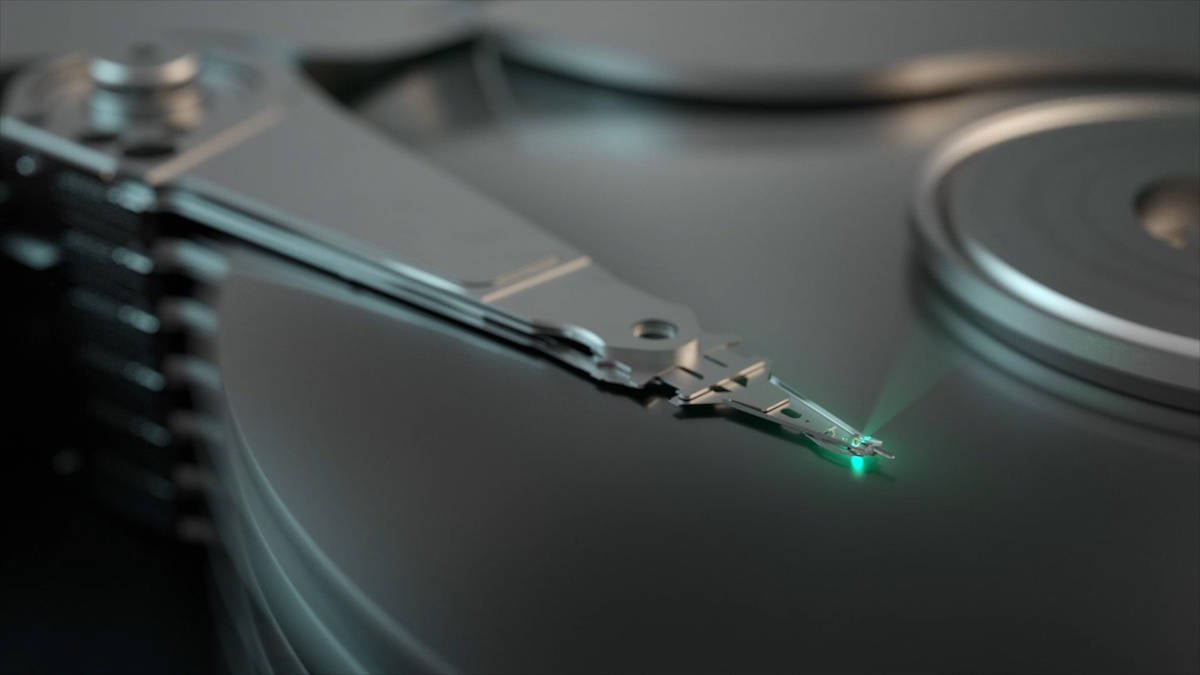

Tom’s: Molti servizi, oggigiorno, utilizzano il cloud. Non solo per immagazzinare i dati, ma anche per funzionare direttamente nel cloud. Possiamo aspettarci una simile integrazione, in futuro, anche per tutti i software Adobe?

Maria Yap: conosciamo bene i benefici del cloud, soprattutto quelli legati alle prestazioni, che permettono anche a chi possiede un dispositivo dalle basse prestazioni di accedere ad applicazioni molto impegnative. Ma tutti noi abbiamo anche dei dispositivi nelle nostre mani, che ci permettono di accedere al cloud, ma che sono anche molto potenti. I notebook e anche gli smartphone moderni hanno molta potenza da offrire.

Il problema principale del Cloud è oggi legato alla latenza delle connessioni. Non è tutto immediato, c’è sempre un ritardo, più o meno lungo, tra l’invio dei comandi e l’azione che ne consegue.

Il futuro sarà un mix delle due cose. Utilizzare la potenza del cloud ma anche quella dei dispositivi, sfruttando le caratteristiche di entrambi, per offrire l’esperienza migliore.

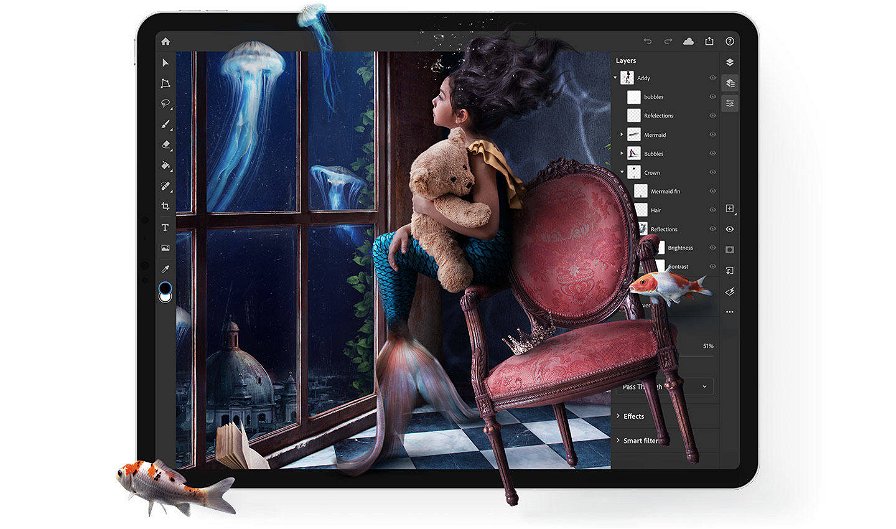

Tom’s: un focus di Adobe per questo Adobe Max 2019 è senza dubbio il mondo mobile, con la presentazione di Photoshop per iPad. Secondo noi, quello che oggi manca veramente nel mercato dei dispositivi mobile, smartphone e tablet, è un’applicazione per il montaggio video seria. Possiamo aspettarci una versione per tablet di Premiere Pro ?

Maria Yap: credo che l’evoluzione che abbiamo visto nel mondo dell’imaging potrà avvenire anche per il mondo dei video. Abbiamo, nella nostra suite, applicazioni molto potenti, e possiamo sfruttare il cloud per renderle disponibili sui vari dispositivi. Quello che abbiamo fatto con Photoshop, il nostro primo passo, è stato portare i file PSD, che possono essere molto pesanti, all’interno dei tablet per essere gestiti. Questo può accadere anche con i video, ma la mole di dati da gestire è molto più grande, quindi è una sfida maggiore, ma certamente possiamo fare molto bene anche in questo mercato.

Tom’s: quando viene realizzata un’applicazione per tablet o smartphone, solitamente quell’applicazione è solo una versione molto ridotta delle controparte per computer. Photoshop per iPad è forse la prima applicazione che cerca di non limitare le caratteristiche, anche se non è ancora identica a quella per desktop. Da cosa deriva questo approccio conservativo?

Maria Yap: solitamente quando portiamo un software in un nuovo dispositivo, vogliamo trovare il giusto bilanciamento tra portare il meglio che abbiamo, e sfruttare le potenzialità del dispositivo. Ci chiediamo quali sono i “superpoteri”, così li chiamiamo, di quel dispositivo. Ad esempio gli smartphone hanno delle fotocamera fenomenali oggigiorno, e quindi ci chiediamo come possiamo sfruttare al massimo la caratteristica peculiari di quel dispositivo.

Cosa cercano le persone da quel dispositivo? Quali sono le potenzialità del dispositivo? Come possiamo unire le due cose per offrire l’esperienza migliore ? E solitamente con la prima versione delle applicazioni cerchiamo di trovare il miglior bilanciamento, ma poi aggiungiamo velocemente ulteriori caratteristiche e funzioni.

Ricordiamoci che non tutti gli utenti sono power-user, anzi è proprio il contrario. Non vogliamo travolgere l’utente con troppi strumenti e funzioni. Iniziamo in maniera cauta, vediamo come l’utente usa l’applicazione, e in base al comportamento sviluppiamo le versioni future, aggiungendo funzioni e caratteristiche che possano offrire agli utenti tutti gli strumenti che richiedono e usano per la maggiore.

Tom’s: avete presentato Aero che porta le applicazioni Adobe nella Realtà Aumentata. Ma parliamo di realtà virtuale, avete progetti di sviluppare applicazioni per la VR?

Maria Yap: abbiamo alcuni progetti per la realtà virtuale, ad esempio Premiere Pro permette di gestire video VR. Tuttavia ci sono degli ostacoli, e il primo è sicuramente che non tutti si trovano a loro agio all’intero della realtà virtuale per via del motion sickness. Per ora la VR rimane una nicchia, accessibile solo a pochi. Noi abbiamo deciso di seguire il mondo dell’AR perché è più accessibile. Basta prendere il vostro smartphone e potete utilizzarla. Ogni artista di Photoshop può mettere a disposizione la propria creazione per la realtà aumentata, e ogni persona con uno smartphone può ammirarla. Noi pensiamo che sia una grande opportunità, e non vediamo l’ora di vedere a cosa porterà. In trent’anni di sviluppo quello che abbiamo imparato è che quando dai un nuovo strumento a un “Creator”, spesso è in grado di creare qualcosa di più emozionante di quanto avessimo mai immaginato.

Tom’s: abbiamo visto come Sensei, la vostra AI, possa velocizzare molte operazioni. Qual è il vostro scopo con Sensei? Non pensate che possa limitare la creatività degli artisti?

Maria Yap: l’AI rappresenta certamente un grande avanzamento tecnologico in grado di portare molta innovazione. Per molti anni, aggiungere nuove funzioni è significato realizzare nuovi algoritmi, un lavoro molto lungo e complesso. Quello che abbiamo visto è che combinare gli algoritmi di ieri con il machine learning di oggi ci permette di capire di più di una immagine. Ed è qui che diventa tutto interessante. Noi alleniamo il computer per atteggiarsi come un umano, per vedere come un essere umano. I PC vedono solo pixel e numeri, non distinguono tra oggetti, panorami o altro. Gli essere umani invece vedono e capiscono quello che hanno davanti, se si tratta di un ortaggio o una sedia. Questo è quello che l’AI può fare, capire cosa è rappresentato in quell’immagine e quindi compiere azioni di conseguenza. Ad esempio, come abbiamo visto, sapere che in quell’immagine è rappresentato un ortaggio, permette di selezionarlo in maniera estremamente più efficiente e precisa, cosa impossibile se si considerano solo le informazioni presenti nei singoli pixel.

L’Intelligenza Artificiale aiuta il computer a essere più umano e in grado di capire quello che vede. Detto questo, la creatività umana non può essere sostituita. L’AI vuole rendere i computer più umani per permette a noi di interagirci in maniera più immediata, intuitiva e veloce.

Tom’s: Come allenate Sensei? Utilizzate anche i dati degli utenti?

Maria Yap: l’approccio è quello della “classificazione”, alleniamo l’IA a capire il tipo di immagine, se si tratta di albero, un frutto, un’auto, etc. Prendiamo database di moltissime immagini che aziende mettono a disposizione. Non utilizziamo i dati degli utenti o le loro immagini. Se mai lo faremo, chiederemo esplicito consenso prima.

I dati che raccogliamo dagli utenti, in maniera anonima, è il modo in cui utilizzano i software. Ad esempio se dopo aver cliccato su un pulsante, selezionano una determinata voce di menù, o un altro pulsante. In questa maniera possiamo definire dei comportamenti e utilizzarli per migliorare i nostri software. Se ad esempio scopriamo che vengono fatte una serie di azioni in successione, possiamo rendere quelle azioni disponibili in un comando specifico così da velocizzare l’interazione con i nostri software.

Per tutte le novità da Adobe MAX, visita questa pagina