Dopo aver mostrato in un breve video GA100, la GPU più grande del mondo, Nvidia ha ufficialmente annunciato al pubblico l'acceleratore grafico Nvidia A100, che sfrutta proprio su questa GPU. Il chip è basato sulla nuova architettura Ampere ed è la prima soluzione Nvidia creata con il processo produttivo a 7nm. GA100 integra 54 miliardi di transistor, più del doppio di quelli presenti all'interno di Volta GV100, che si ferma a "solamente" 21 miliardi.

Nvidia Ampere sfrutta i Tensor core di terza generazione, chiamati TF32 e progettati per gestire al meglio i carichi IA. I nuovi Tensor core supportano numeri FP64: significa che la GPU avrà prestazioni decisamente superiori nei calcoli di doppia precisione, un cambiamento chiave per gli il settore HPC (calcolo ad alte prestazioni).

Stando a quanto dichiarato da Nvidia, la nuova Ampere GA100 sarà 20 volte più potente delle GPU Volta nell'allenamento di intelligenze artificiali con calcoli di singola precisione e nell'inferenza con operazioni con interi a 8 bit. Nel calcolo ad alte prestazioni con operazioni di doppia precisione Nvidia afferma che GA100 sarà 2,5 volte più veloce della precedente generazione.

A livello di specifiche tecniche, Nvidia A100 avrà a disposizione 6912 CUDA core, 432 Tensor core e 40GB di memoria HBM2 con un bus di 5120-bit. Il die della GPU misura 826mm² e il chip è suddiviso in 108 Streaming Multiprocessor, inoltre la scheda supporta NVLink di terza generazione con un bandwidth bidirezionale di 4,8TB/s con il server e di 600GB/s tra le GPU. A100 dovrebbe poi supportare lo standard PCIe 4.0 e avere un TDP di 400 watt.

Kharya, director of product management for accelerated computing presso Nvidia, ha dichiarato "con questa nuova precisione, A100 offre 20 volte più potenza di calcolo per le computazioni IA di singola precisione, e poiché gli sviluppatori continuano a usare gli input di singola precisione e ottengono output di singola precisione, non hanno bisogno di nulla di diverso. Ottengono benefici automaticamente, non appena iniziano a usare la GPU".

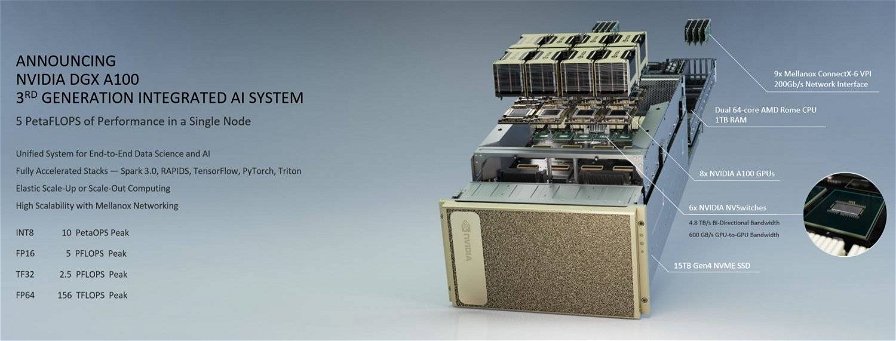

Il nuovo chip Ampere GA100 sarà quindi la base per gli acceleratori grafici A100, che a loro volta daranno vita al sistema DGX A100. In particolare, DGX A100 sarà basato su otto A100 e potrà offrire una potenza fino a 5PFLOPs in calcoli FP16, fino a 2,5TFLOPs in calcoli TF32 e fino a 156TFLOPs in calcoli FP64. Come anticipato, nei dati mostrati da Nvidia ogni acceleratore A100 è in grado di offrire prestazioni di picco fino a 20 volte superiori rispetto a quelle dei sistemi DGX basati su Volta.

Oltre alle otto Nvidia A100, DGX A100 integra due processori AMD EPYC Rome da 64 core / 128 thread, 1TB di memoria RAM, un SSD NVMe PCIe 4.0 da ben 15TB e nove VPI Mellanox ConnectX-6 per interconnessioni da 200Gb/s.

La scorsa generazione di sistemi DGX era progettata solamente per gestire carichi IA, ma Nvidia ha lavorato per far sì che DGX A100 si adatti bene anche alle applicazioni scalabili, come quelle di analisi dati o di inferenza. La potenza di calcolo del nuovo sistema è notevole: un singolo rack di DGX A100 è in grado di sostituire in un datacenter 25 rack di CPU, richiedendo solamente 1/20 dell'energia e 1/10 dell'investimento.

La società ha poi confermato che i sistemi DGX A100 basati sugli acceleratori A100 sono già all'opera all'interno del dipartimento dell'energia statunitense, dove vengono impiegati nella lotta al COVID-19. Ogni DGX A100 costerà 200mila dollari, i sistemi sono già disponibili e chi è interessato può procedere all'acquisto.

Nvidia ha infine annunciato anche la prossima generazione di DGX SuperPOD, un cluster di 140 DGX A100 in grado di raggiungere una potenza di calcolo pari a 700 PetaFLOPs nel campo dell'intelligenza artificiale. Nvidia ha costruito il supercomputer DGX SuperPOD sfruttando DGX A100 e l'interconnessione Mellanox HDR 200Gbps InfiniBand, con l'obiettivo di effettuare delle ricerche nei campi dell'IA, della guida autonoma e della genomica.