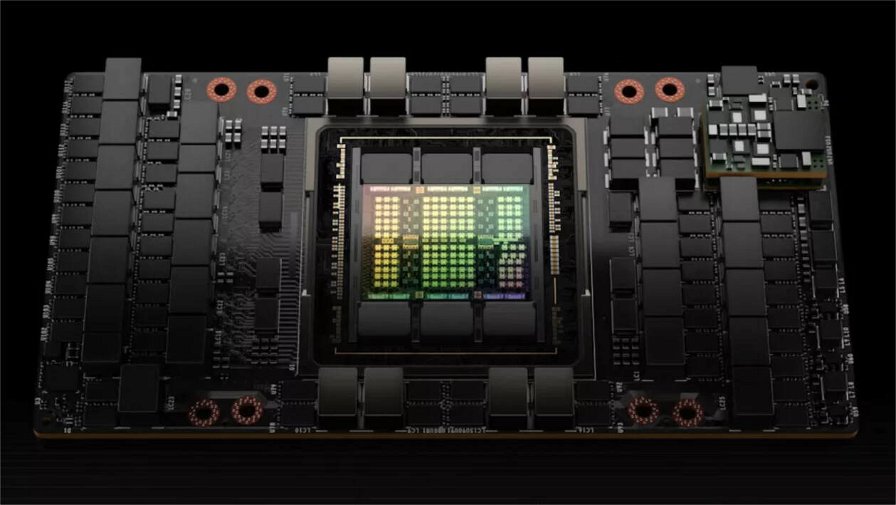

In occasione della GPU Technology Conference (GTC), NVIDIA ha presentato l’architettura Hopper e la scheda H100, progettata per i data center, soprattutto per l’IA. Rispetto all’attuale A100, H100 presenta molteplici miglioramenti per raggiungere prestazioni ed un’efficienza maggiori. Il chip è costituito da 80 miliardi di transistor ed è costruito utilizzando il processo personalizzato TSMC 4N, diverso da quello N4 generico di TSMC.

Sfortunatamente, l’azienda californiana non ha specificato il numero di core o le frequenze di clock del chip, ma sappiamo che H100 supporta l'interfaccia NVLink di quarta generazione, che può fornire fino a 128 GB/s di larghezza di banda, nonché PCIe 5.0 per i sistemi che non usano NVLink, che arriva a 128 GB/s. H100 avrà 80GB di memoria HBM3 come standard, fornendo 3TB/s di larghezza di banda.

Per quanto riguarda la potenza di calcolo, H100 può offrire fino a 2.000 TFLOPS FP16 e 1.000 TFLOPS TF32, così come 60 TFLOPS di calcolo FP64 di uso generale. Hopper aggiunge anche un supporto FP8 migliorato con fino a 4.000 TFLOPS di calcolo e, per aiutare a ottimizzare le prestazioni, NVIDIA ha implementato anche un nuovo motore di trasformazione che passerà automaticamente tra i formati FP8 e FP16, in base al carico di lavoro.

Sono state aggiunte le nuove istruzioni DPX, progettate per accelerare la programmazione dinamica e che possono aiutare con una vasta gamma di algoritmi. Hopper include anche modifiche per migliorare la sicurezza e la GPU multi-istanza (MIG) ora permette l'esecuzione di sette tenant sicuri su una singola GPU H100.

Tuttavia, nonostante il passaggio a un nodo di produzione più piccolo, il TDP di H100 per la variante SXM è stato aumentato a 700W, rispetto ai 400W dei moduli A100 SXM. Si tratta del 75% di potenza in più per miglioramenti a livello prestazionale che vanno dal 50% al 500%, a seconda del carico di lavoro. In generale, le performance dovrebbero essere 2-3 volte rispetto alla precedente A100, quindi ci dovrebbe essere ancora un miglioramento netto dell'efficienza.

In generale, NVIDIA sostiene che la H100 scala meglio della A100 e può fornire fino a 9 volte più throughput nel training AI e da 16 a 30 volte le performance in inferenza utilizzando Megatron 530B come benchmark. Infine, in applicazioni HPC come 3D FFT e sequenziamento del genoma, NVIDIA dice che H100 è fino a 7 volte più veloce di A100.

La scheda H100 dovrebbe essere lanciata tra qualche mese e molto probabilmente non userà un die GH100 completamente abilitato, dato che comporterebbe una resa molto bassa. Ulteriori dettagli saranno diffusi in un secondo momento.