YouTube da giugno ha rimosso 100mila video e 17mila canali a seguito dell'implementazione della nuova policy contro i contenuti d'odio e suprematisti. La nuova strategia si basa su quattro principi e nei prossimi mesi saranno svelati tutti i dettagli al riguardo. Per ora è stata potenziata l'operazione di rimozione.

"Stiamo rimuovendo contenuti dannosi dalla nascita di YouTube, ma il nostro impegno in questo lavoro si è accelerato negli ultimi anni", si legge nel post del blog ufficiale. "Grazie a questa attività in corso negli ultimi 18 mesi abbiamo ridotto le visualizzazioni dell'80% sui video che sono stati successivamente rimossi per violazione delle nostre norme e continueremo a lavorare per ridurre questo numero ulteriormente".

Prima della rimozione YouTube si accerta di aggiornare costantemente le policy per fornire indicazioni chiare. Inoltre il team di consulenti lavora per mantenere inalterato l'equilibrio tra sicurezza e libertà di espressione.

"Ad esempio, all'inizio di quest'anno abbiamo fornito maggiori dettagli di quando consideriamo una 'questione' troppo pericolosa per YouTube", si legge sul post. "Dal 2018, abbiamo apportato dozzine di aggiornamenti alle nostre linee guida sull'applicazione, molti dei quali chiarimenti minori ma alcuni più sostanziali".

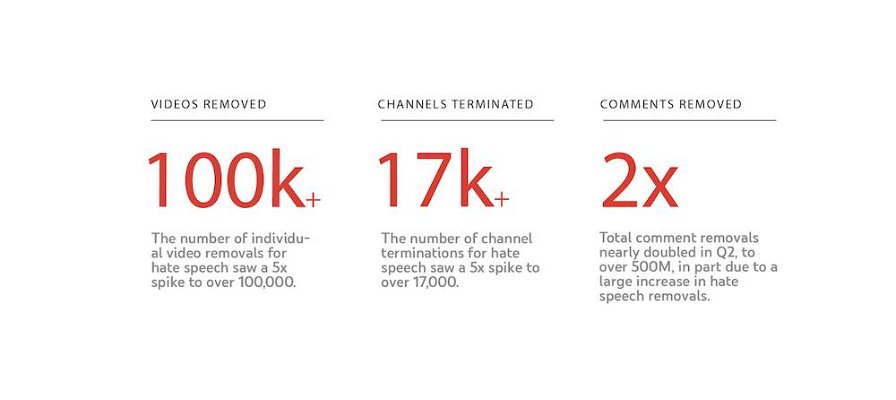

L'azione di cancellazione poi procede manualmente e contemporaneamente i sistemi automatici imparano da questa. Nell'ultimo trimestre vi è stato un picco di rimozioni: appunto di cinque volte superiore nei video (100mila), di cinque volte nei canali (17mila) e di due volte dei commenti (5 milioni).

"A volte utilizziamo gli hash (o le "impronte digitali") per catturare copie di contenuti illegali noti prima che siano mai resi disponibili per la visualizzazione", prosegue YouTube. "Per alcuni contenuti, come immagini di abusi sessuali su minori (CSAI) e video di reclutamento di terroristi, contribuiamo a database di hash del settore condivisi per aumentare il volume di contenuti che le nostre macchine possono catturare al momento del caricamento".

L'apprendimento automatico per aiutare a rilevare contenuti potenzialmente illegali da far vagliare al team umano funziona per identificare similitudini. Questi sistemi dovrebbero essere efficaci per contrassegnare i contenuti che spesso hanno lo stesso aspetto, come spam o per adulti.

"Le macchine possono anche aiutare a contrassegnare i discorsi di odio e altri contenuti violenti, ma queste categorie dipendono fortemente dal contesto e sottolineano l'importanza della revisione umana per prendere decisioni sfumate", sottolinea l'azienda. "Tuttavia, oltre l'87% dei 9 milioni di video che abbiamo rimosso nel secondo trimestre del 2019 sono stati contrassegnati per la prima volta dai nostri sistemi automatizzati".

Da gennaio 2018 poi è attivo l'Intelligence Desk, un team che monitora le notizie, i social media e i rapporti degli utenti al fine di rilevare le nuove tendenze relative a contenuti inappropriati e lavora per assicurarsi che azioni preventive.

"Siamo determinati a continuare a ridurre l'esposizione ai video che violano le nostre norme. Ecco perché, su Google, abbiamo incaricato oltre 10.000 persone di rilevare, esaminare e rimuovere contenuti che violano le nostre linee guida", ricorda YouTube.