Ecco il paradosso che fino a pochi anni fa sarebbe stato impensabile: i laureati in informatica e ingegneria informatica registrano tassi di disoccupazione superiori rispetto ai colleghi che hanno studiato materie considerate tradizionalmente meno "commerciabili" come giornalismo, scienze politiche o letteratura. Questo ribaltamento delle aspettative professionali rappresenta forse il simbolo più evidente di come l'intelligenza artificiale stia ridisegnando completamente il panorama lavorativo, colpendo proprio quelle figure che dovevano essere al riparo dalla rivoluzione tecnologica. La Federal Reserve di New York ha documentato questa inversione di tendenza attraverso dati che testimoniano un cambiamento epocale nel mercato del lavoro qualificato.

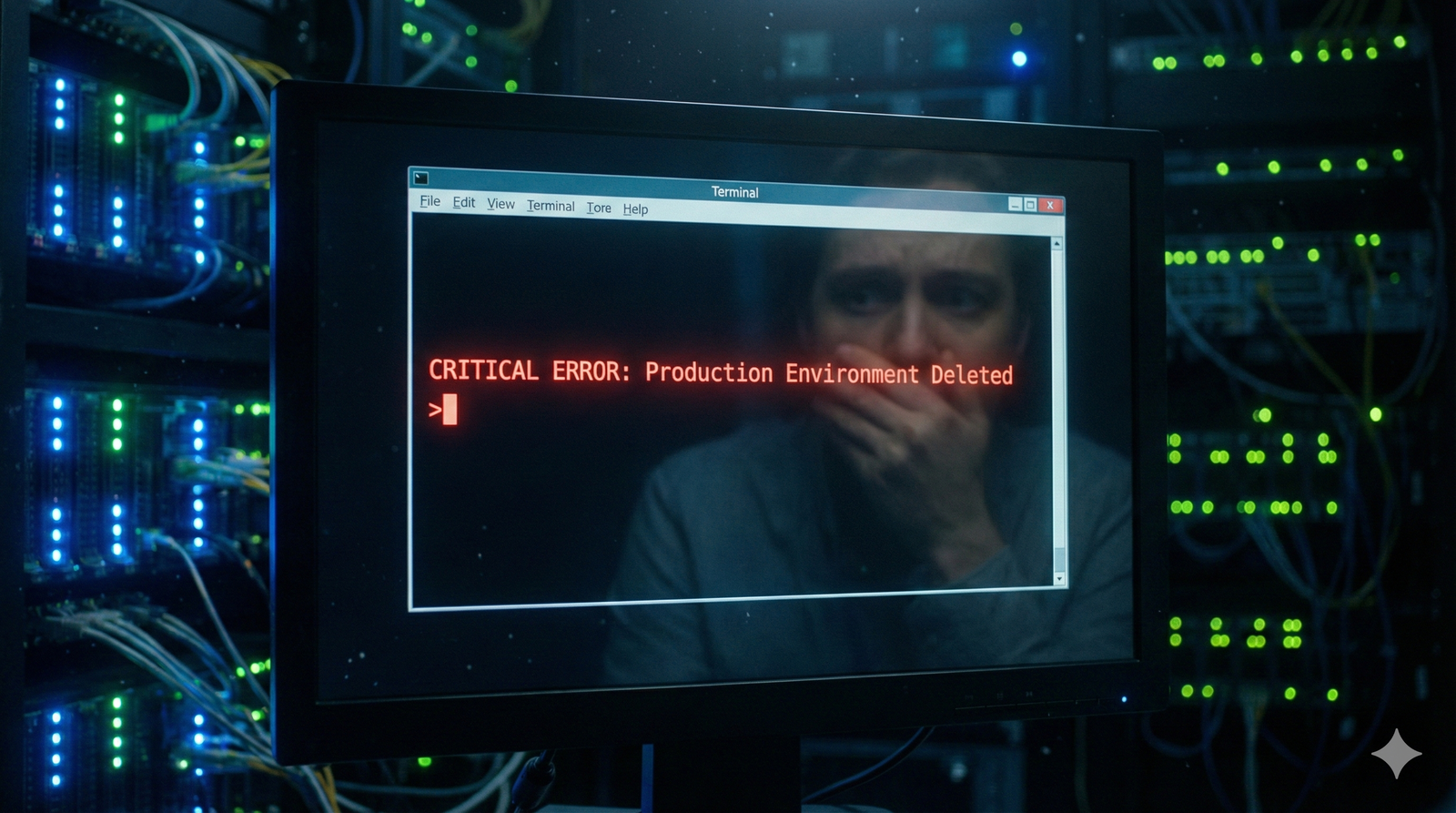

L'analista dei rischi Ian Bremmer ha recentemente offerto una lettura particolarmente cruda di questa trasformazione durante una discussione nel programma "Real Time with Bill Maher". Secondo Bremmer, l'industria del "imparare a programmare" è stata letteralmente spazzata via dall'avanzata dell'intelligenza artificiale, al punto che molti sviluppatori software che fino a ieri godevano di posizioni lavorative stabili e ben retribuite si trovano oggi costretti a vendere il proprio plasma per sbarcare il lunario.

I numeri della Federal Reserve di New York confermano questa analisi apparentemente provocatoria. I laureati in informatica mostrano un tasso di disoccupazione del 6,1%, posizionandosi al settimo posto nella classifica delle specializzazioni più colpite dalla mancanza di lavoro. Ancora peggio va agli ingegneri informatici, che con il 7,5% di disoccupazione occupano il terzo posto in questa indesiderata graduatoria. Entrambe le percentuali superano significativamente la media generale dei neolaureati, ferma al 5,8%.

La fine del mito della programmazione

La velocità con cui si è consumato questo rovesciamento delle fortune professionali lascia attoniti anche gli osservatori più esperti. Appena cinque anni fa, il consiglio più saggio che si potesse dare ai giovani era proprio quello di imparare a programmare, una competenza considerata la chiave di accesso garantito a un futuro professionale sicuro e redditizio. Oggi quella stessa raccomandazione è diventata, nelle parole di Bremmer, "letteralmente un consiglio peggiore di quello di farsi un tatuaggio sul viso".

Questa metamorfosi del mercato del lavoro tecnologico riflette l'impatto devastante che l'intelligenza artificiale sta avendo sui colletti bianchi, una categoria che si credeva relativamente protetta dall'automazione. Lo storico e autore Rutger Bregman, presente alla stessa discussione, ha evocato una delle argomentazioni più ricorrenti per giustificare questo sconvolgimento: l'idea che il capitalismo finirà inevitabilmente per "inventare nuovi lavori inutili" per assorbire chi ha perso l'occupazione a causa della tecnologia.

Il nuovo mantra che sta emergendo dalle ceneri del "impara a programmare" è prevedibilmente "impara l'intelligenza artificiale". Tuttavia, secondo l'imprenditore tecnologico Joe Procopio, questa evoluzione potrebbe rivelarsi altrettanto fuorviante nel lungo periodo. In un articolo pubblicato su Inc magazine, Procopio ha messo in guardia contro l'illusione che imparare a utilizzare strumenti di IA rappresenti una soluzione duratura al problema occupazionale del settore.

Il circolo vizioso della mediocrit à tecnologica

L'analisi di Procopio mette in luce un meccanismo perverso che si sta instaurando nel mondo della tecnologia. La corsa a formare una nuova classe di "talenti AI" che sanno programmare utilizzando strumenti come GitHub Copilot non sta producendo codice migliore, applicazioni più efficaci o risultati aziendali superiori. Al contrario, sta generando quello che l'imprenditore definisce "spazzatura IA sotto forma di codice", in perfetta continuità con quanto accaduto durante l'era del "impara a programmare".

Questa dinamica rivela un pattern ricorrente: l'ondata precedente di consigli per orientare le carriere aveva già creato una forza lavoro di programmatori mediocri, che oggi si trovano ad essere bersagli facili per la sostituzione da parte di sistemi di intelligenza artificiale altrettanto mediocri nella produzione di codice. Il risultato è un circolo vizioso in cui la qualità complessiva del software continua a deteriorarsi, mentre i lavoratori qualificati vengono progressivamente esclusi dal mercato.

Le conseguenze di questa trasformazione si estendono ben oltre i confini del settore tecnologico, rappresentando un campanello d'allarme per l'intero sistema educativo e formativo. La rapidità con cui competenze considerate fondamentali e a prova di futuro si sono trasformate in ostacoli all'occupazione solleva interrogativi profondi sulla capacità delle istituzioni di anticipare e preparare adeguatamente le nuove generazioni alle sfide del mercato del lavoro nell'era dell'intelligenza artificiale.

Il paradosso dei laureati in informatica disoccupati mentre i loro colleghi di materie umanistiche trovano più facilmente lavoro potrebbe essere solo l'inizio di una ridefinizione completa del valore delle competenze professionali. In un mondo dove l'intelligenza artificiale sta rapidamente acquisendo capacità che sembravano esclusivamente umane, la creatività, il pensiero critico e la capacità di adattamento potrebbero rivelarsi più preziose della conoscenza tecnica specifica, per quanto avanzata.

Il fenomeno della disoccupazione tecnologica che sta colpendo i laureati in informatica affonda le sue radici in una lunga storia di trasformazioni del mercato del lavoro. Già nel 1930, l'economista John Maynard Keynes aveva coniato il termine "disoccupazione tecnologica" per descrivere la perdita di posti di lavoro causata dal progresso tecnologico che superava la capacità della società di trovare nuovi utilizzi per la forza lavoro liberata.

La storia dell'informatica come disciplina accademica è relativamente recente. Il primo corso di laurea in Computer Science fu istituito alla Purdue University nel 1962, seguito dalla Stanford University nel 1965. In Italia, il primo corso di laurea in Informatica venne attivato all'Università di Pisa nel 1969, pioniera in Europa per questo tipo di formazione. Per decenni, questi laureati sono stati considerati l'élite del mercato del lavoro tecnologico.

Un dato curioso riguarda l'origine del termine "programmatore": inizialmente, negli anni '40 e '50, questa figura professionale era prevalentemente femminile. Le donne erano considerate particolarmente adatte alla programmazione perché si pensava richiedesse pazienza e attenzione ai dettagli, qualità stereotipicamente associate al genere femminile. Grace Hopper, Ada Lovelace e le "computer girls" della NASA furono le vere pioniere di quello che sarebbe diventato uno dei settori più maschili dell'economia moderna.

La nascita dell'intelligenza artificiale come campo di studio risale al 1956, durante la famosa Conferenza di Dartmouth organizzata da John McCarthy. Già allora, gli scienziati discussero delle implicazioni che le macchine pensanti avrebbero potuto avere sul lavoro umano. Tuttavia, quello che oggi chiamiamo "AI winter" - periodi di disillusione e riduzione dei finanziamenti - ha caratterizzato gran parte degli anni '70, '80 e '90, facendo sembrare l'intelligenza artificiale più una promessa non mantenuta che una minaccia concreta.

Il concetto di "automazione dei colletti bianchi" non è nuovo. Negli anni '80, l'introduzione dei personal computer e dei software di elaborazione testi eliminò migliaia di posti di lavoro per dattilografi e segretari. Negli anni '90, i software di contabilità automatizzata ridussero drasticamente la domanda di ragionieri entry-level. La differenza sostanziale con l'attuale ondata di automazione è la velocità esponenziale del cambiamento e la capacità dell'AI di sostituire anche lavori altamente qualificati.

Una curiosità storica riguarda il movimento dei Luddisti nell'Inghilterra del primo '800. Questi artigiani tessili distruggevano i telai meccanici che minacciavano il loro sostentamento, dando origine al termine "luddismo" per indicare l'opposizione al progresso tecnologico. Oggi, alcuni sviluppatori software stanno vivendo una forma moderna di luddismo, non distruggendo le macchine ma semplicemente rifiutandosi di utilizzare strumenti di IA nel loro lavoro quotidiano.

Il fenomeno della polarizzazione del mercato del lavoro è stato studiato estensivamente dall'economista David Autor del MIT. La sua ricerca dimostra come la tecnologia tenda a eliminare i lavori di "media qualificazione" - quelli che richiedono competenze routinarie ma specializzate - mentre preserva sia i lavori altamente qualificati che richiedono creatività e problem-solving complesso, sia quelli a bassa qualificazione che richiedono interazione umana diretta.

La storia ci insegna che ogni rivoluzione tecnologica ha creato nuove categorie professionali impensabili in precedenza. Chi avrebbe potuto immaginare, anche solo vent'anni fa, figure come il social media manager, l'influencer, o il data scientist? La sfida attuale non è tanto prevedere quali lavori spariranno, ma immaginare quali nuove professioni emergeranno dall'intersezione tra intelligenza umana e artificiale.

Un dato storico interessante: durante la Rivoluzione Industriale, ci vollero circa 80 anni perché la società si adattasse completamente ai cambiamenti nel mercato del lavoro. La Rivoluzione Digitale ha compresso questo processo in circa 30 anni. L'attuale rivoluzione dell'IA sembra voler completare trasformazioni analoghe in meno di un decennio, creando tensioni sociali ed economiche senza precedenti. Almeno nella storia moderna.