L'avvento dell'intelligenza artificiale agentica sta ridefinendo le priorità strategiche delle organizzazioni in materia di resilienza digitale. Mentre i sistemi AI tradizionali richiedevano supervisione umana costante, questa nuova generazione di tecnologie autonome è in grado di pianificare, ragionare ed eseguire operazioni complesse con intervento minimo dell'uomo. Ma proprio questa autonomia operativa, unita alla velocità e alla scala con cui questi sistemi agiscono, trasforma anche piccole inconsistenze nei dati o lacune nella sicurezza in potenziali vulnerabilità amplificate. La capacità di prevenire, resistere e recuperare rapidamente da interruzioni digitali non è mai stata così cruciale, eppure meno della metà dei dirigenti aziendali si dichiara fiducioso nella capacità della propria organizzazione di mantenere continuità operativa, sicurezza e controllo dei costi durante eventi imprevisti.

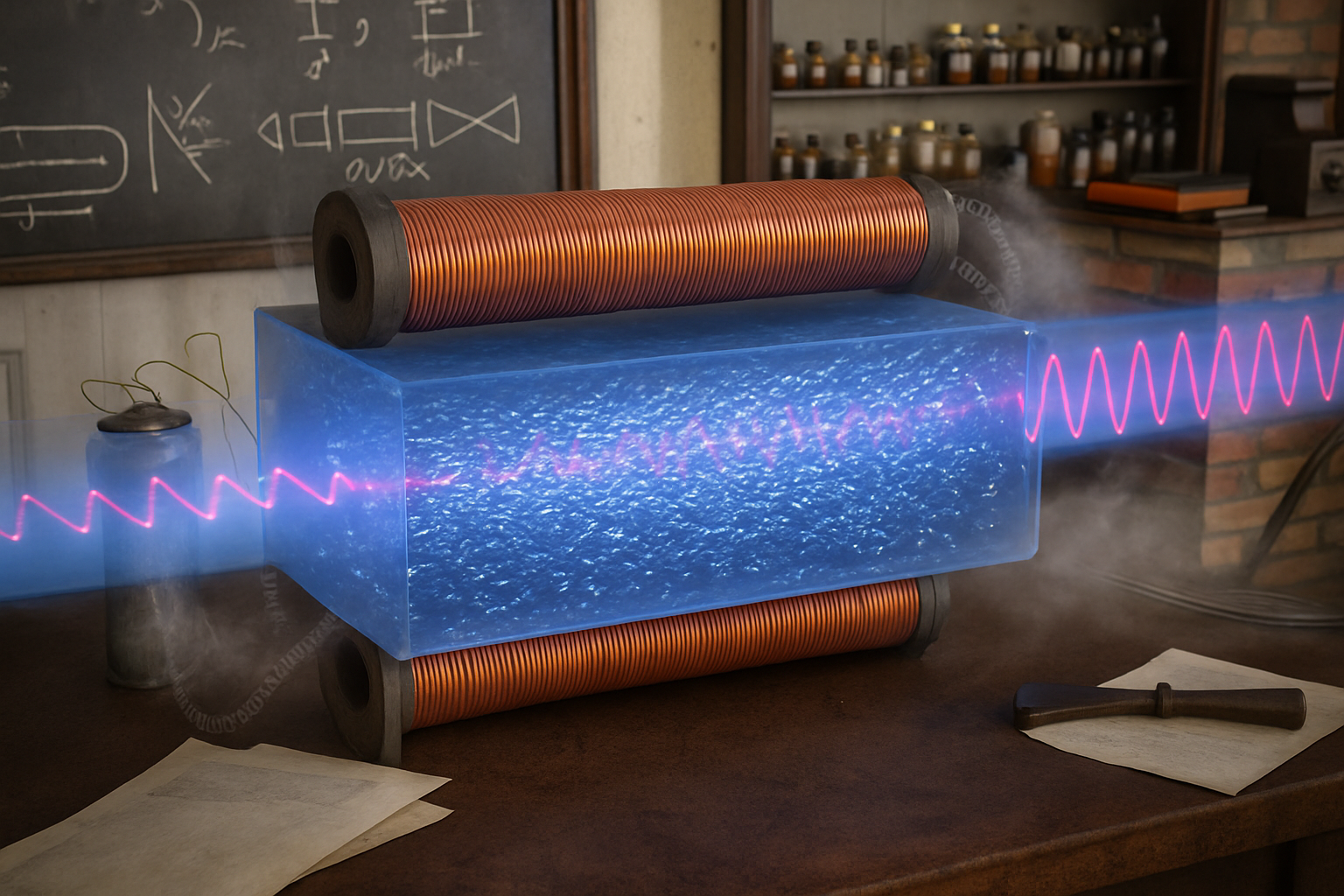

La questione chiave risiede nella natura stessa dei dati su cui opera l'AI agente. Mentre i modelli AI precedenti si basavano principalmente su informazioni generate da esseri umani come testo, audio e video, i sistemi agenti richiedono accesso profondo e continuo ai dati macchina: log di sistema, metriche operative, telemetria generata da dispositivi, server e applicazioni. Secondo Kamal Hathi, vicepresidente senior di Splunk, società del gruppo Cisco, questi flussi di informazioni rappresentano "il battito cardiaco dell'impresa moderna", indispensabile affinché i sistemi agenti possano comprendere il contesto operativo, simulare scenari futuri e adattarsi dinamicamente alle condizioni mutevoli.

Il problema è che pochissime organizzazioni hanno raggiunto il livello di integrazione dei dati macchina necessario per abilitare pienamente i sistemi agenti. Questa frammentazione non solo limita i casi d'uso possibili per l'agente AI, ma può anche generare anomalie nei dati che producono errori negli output o nelle azioni intraprese autonomamente. È un rischio simile a quello che affliggeva i modelli di elaborazione del linguaggio naturale prima dello sviluppo dei transformer generativi: ambiguità linguistiche, bias e inconsistenze minavano l'affidabilità dei sistemi. Con l'agente AI, il rischio si materializza quando le organizzazioni procedono senza garantire ai modelli una "fluenza fondamentale" nei dati macchina.

La risposta tecnologica a questa sfida passa attraverso l'architettura del data fabric, un paradigma integrato che connette e governa le informazioni attraverso tutti i livelli operativi di un'organizzazione. A differenza degli approcci tradizionali basati su database strutturati predefiniti, il data fabric deve gestire in tempo reale anche i flussi di dati non strutturati come log di sistema, eventi di sicurezza e tracce applicative, che mancano di uniformità e richiedono metodi avanzati di analisi abilitati proprio dall'intelligenza artificiale.

Implementare un data fabric efficace richiede tre passaggi fondamentali, spiega Hathi. Primo, abbattere i silos dipartimentali nella condivisione dei dati tra sicurezza, IT, operazioni aziendali e infrastruttura di rete. Secondo, implementare un'architettura dati federata, dove sorgenti autonome collaborano come unità singola senza fusione fisica, mantenendo governance e sicurezza. Terzo, aggiornare le piattaforme dati per rendere questa vista unificata azionabile per i sistemi agenti, che possono così operare con una visione olistica dell'ambiente digitale, riducendo drasticamente i punti ciechi e accelerando il processo decisionale.

Paradossalmente, l'intelligenza artificiale stessa diventa strumento essenziale per costruire l'infrastruttura dati che alimenta i sistemi AI. Algoritmi di apprendimento automatico possono identificare rapidamente relazioni tra dati disparati, sia strutturati che non strutturati, fondendoli automaticamente in un'unica fonte di verità. Possono rilevare e correggere errori, impiegare il linguaggio naturale per categorizzare informazioni e renderle facilmente accessibili. I sistemi agenti possono inoltre aumentare le capacità umane nel rilevare anomalie nei flussi di dati non strutturati dell'impresa, spesso impossibili da individuare o interpretare rapidamente dall'uomo, prevenendo minacce che altrimenti passerebbero inosservate.

La questione della supervisione umana rimane tuttavia centrale. Nonostante il potenziale, l'AI agente deve essere posizionata come intelligenza assistiva, non sostitutiva. Senza adeguata governance, gli agenti autonomi potrebbero introdurre malfunzionamenti applicativi o rischi per la sicurezza. Hathi sottolinea che mantenere gli esseri umani nel ciclo decisionale è fondamentale per un uso affidabile e pratico dell'AI. L'intelligenza artificiale può potenziare il processo decisionale umano, ma la responsabilità ultima deve rimanere nelle mani delle persone, che forniscono sicurezza, oversight e quella capacità di giudizio contestuale che nessun algoritmo può replicare completamente.

La resilienza digitale nell'era dell'AI agente non si limita quindi alla capacità di resistere alle interruzioni, ma richiede sistemi capaci di evolversi e ottimizzarsi continuamente. Gli agenti AI possono elaborare volumi massicci di dati e apprendere costantemente dalle interazioni con supervisori umani, creando quello che Hathi definisce "un vero sistema auto-ottimizzante".