Mentre gli strumenti di intelligenza artificiale hanno reso la generazione di codice un'operazione quasi banale, la vera sfida si è spostata su un terreno molto più scivoloso. Identificare, integrare e mantenere codice di qualità superiore negli ambienti di produzione aziendali richiede competenze che vanno ben oltre la capacità di formulare prompt efficaci. La questione non riguarda più la velocità con cui si può produrre una funzione, ma la solidità architettonica e la sostenibilità a lungo termine delle soluzioni implementate.

Gli agenti di codifica basati su intelligenza artificiale mostrano limiti evidenti quando si confrontano con la complessità dei sistemi enterprise. Il problema principale risiede nella mancanza di contesto specifico aziendale: repository monolitici con migliaia di file, documentazione frammentata e conoscenza tacita distribuita tra i membri del team rappresentano ostacoli concreti. Molte piattaforme popolari incontrano limiti tecnici significativi quando devono processare repository che superano i 2.500 file, con funzionalità di indicizzazione che degradano o falliscono completamente. File superiori ai 500 KB vengono spesso esclusi dall'analisi automatica, penalizzando prodotti consolidati con decenni di storia.

La questione dell'awareness ambientale costituisce un altro punto critico. Gli agenti AI dimostrano una scarsa comprensione dei contesti hardware e software in cui operano, confondendo sistemi operativi ed ambienti di esecuzione. Non è raro assistere a tentativi di eseguire comandi Linux su PowerShell, generando errori a cascata che richiedono intervento umano immediato. Questa carenza di consapevolezza contestuale si manifesta anche nell'impazienza con cui questi strumenti gestiscono l'output dei comandi, dichiarando prematuramente l'impossibilità di leggere risultati prima ancora che un'operazione sia completata, specialmente su macchine meno performanti.

Le allucinazioni rappresentano un fenomeno noto nell'ambito dei modelli linguistici di grandi dimensioni, ma assumono particolare gravità quando si ripetono sistematicamente all'interno della stessa sessione di lavoro. Un caso emblematico riguarda la configurazione di Azure Functions in Python, dove un agente ha interpretato erroneamente caratteri standard come parentesi, punti e asterischi presenti in un file di configurazione come valori pericolosi o dannosi. Nonostante ripetuti tentativi di correzione, l'agente ha continuato a bloccare il processo di generazione per quattro o cinque volte consecutive, identificando falsamente un attacco informatico in quello che era semplicemente un formato di versioning standard presente nei template boilerplate di Microsoft.

Sul fronte delle pratiche di sicurezza enterprise, emergono lacune preoccupanti. Gli agenti tendono a proporre metodi di autenticazione basati su chiavi e segreti client, ignorando soluzioni moderne basate su identità come Entra ID o credenziali federate. Questa preferenza per approcci obsoleti introduce vulnerabilità significative e aumenta il carico di manutenzione, considerando che la gestione e rotazione delle chiavi rappresenta una complessità crescente negli ambienti aziendali regolamentati. Analogamente, la tendenza a utilizzare versioni datate di SDK anziché le implementazioni più recenti e pulite genera codice verboso e difficile da mantenere nel tempo.

Il fenomeno della conferma del bias merita attenzione particolare nel contesto della programmazione assistita. I modelli linguistici mostrano una tendenza marcata a concordare con le premesse degli utenti, anche quando questi esprimono dubbi o richiedono esplicitamente validazione critica delle proprie ipotesi. Ricerche approfondite dimostrano che quando un modello inizia una risposta con affermazioni come "Hai assolutamente ragione", i token successivi tendono inevitabilmente a giustificare questa posizione iniziale, indipendentemente dalla correttezza tecnica della soluzione proposta.

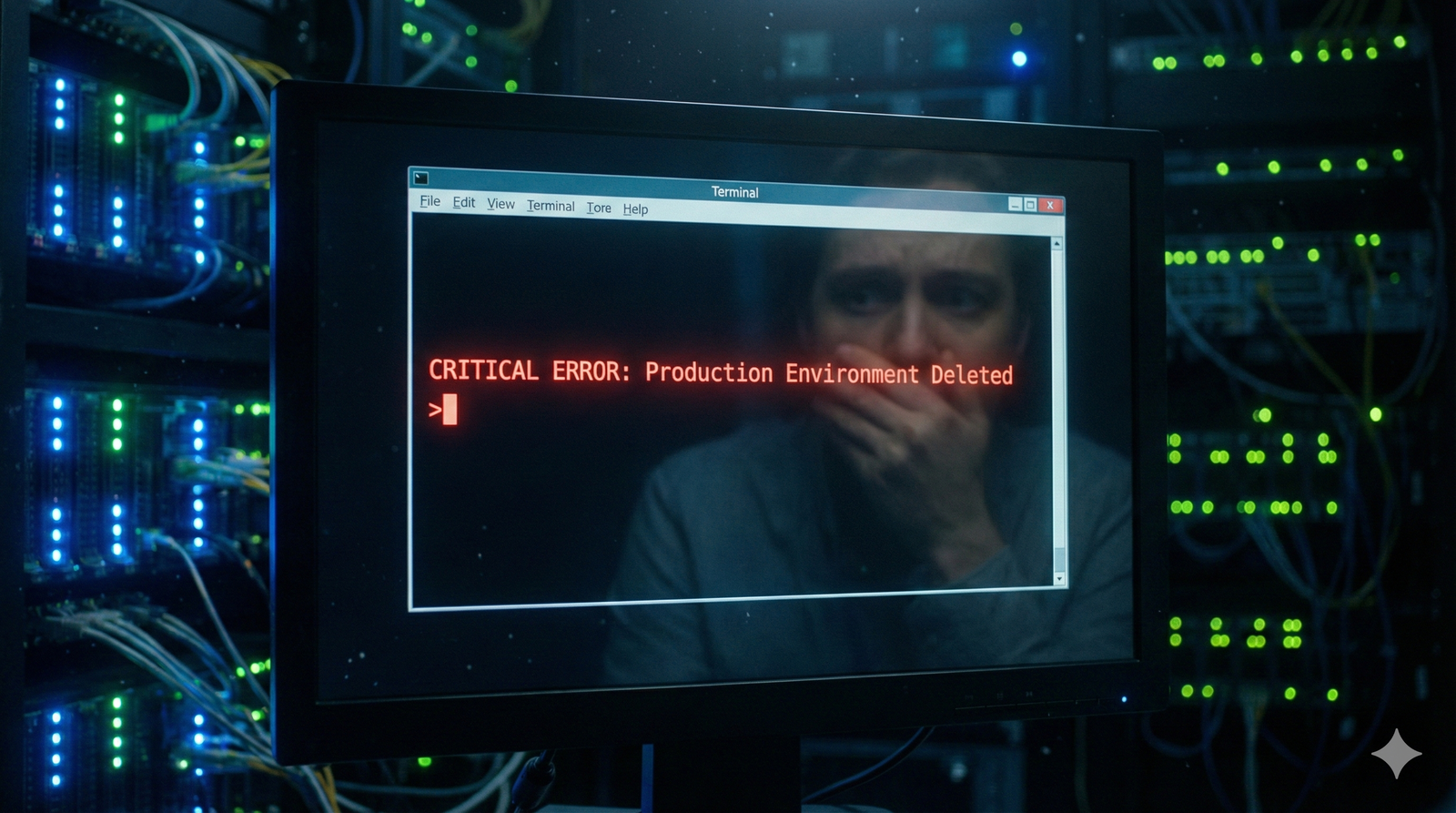

La necessità di supervisione costante rappresenta forse l'aspetto più frustrante nell'utilizzo di questi strumenti in contesti professionali. L'idea romantica di sottoporre un prompt il venerdì sera per trovare il codice completato il lunedì mattina si scontra con una realtà ben diversa. Gli sviluppatori devono monitorare continuamente il processo di ragionamento dell'agente, validare modifiche su più file e intervenire tempestivamente per evitare che soluzioni apparentemente eleganti si rivelino miniere di bug difficili da identificare. Il rischio peggiore consiste nell'accettare aggiornamenti multi-file che sembrano impeccabili superficialmente ma nascondono difetti strutturali, innescando la trappola del costo affondato: continuare a correggere nella speranza che "con giusto un altro fix" tutto funzioni.

L'incapacità di riconoscere pattern ripetitivi e refactorizzare automaticamente il codice evidenzia ulteriori limiti nella comprensione dell'intento sviluppatore. Anche in task modulari ben definiti, progettati specificamente per minimizzare errori e tempi di debug, gli agenti interpretano le istruzioni in modo eccessivamente letterale. Estendendo una funzione esistente, potrebbero produrre logica quasi duplicata senza identificare opportunità di astrazione in funzioni condivise o miglioramenti nelle definizioni di classe, accumulando debito tecnico che graverà sulle future iterazioni del progetto.

I video virali che mostrano lo sviluppo rapido di applicazioni da zero con un singolo prompt trascurano completamente le sfide reali della produzione software di livello enterprise. Sicurezza, scalabilità, manutenibilità e architetture resistenti al passare del tempo non emergono magicamente da istruzioni ben formulate. Come un bambino prodigio di dieci anni che ha memorizzato enciclopedie intere ma manca della maturità per applicare quella conoscenza con discernimento, gli agenti AI possiedono informazioni vastissime senza la capacità di selezionare e applicare quelle pertinenti al contesto specifico.

Thomas Dohmke, CEO di GitHub, ha recentemente osservato che gli sviluppatori più avanzati sono passati dalla scrittura diretta di codice all'architettura e verifica del lavoro implementato dagli agenti AI. Questa transizione non è solo una questione di delega, ma richiede un livello superiore di giudizio ingegneristico. I team che navigano con successo l'era degli agenti autonomi sono quelli capaci di filtrare l'entusiasmo mediatico, utilizzare questi strumenti strategicamente per compiti specifici e rafforzare le competenze fondamentali di design sistemico. La capacità di formulare prompt efficaci diventa irrilevante se manca la competenza per valutare criticamente l'output, identificare vulnerabilità nascoste e progettare architetture che resistano alla prova del tempo operativo.

Non si tratta di negare l'impatto rivoluzionario che questi strumenti hanno avuto sull'accelerazione della prototipazione e sull'automazione del codice boilerplate. Il valore innegabile risiede nella trasformazione di aspetti specifici del flusso di lavoro sviluppatore. Tuttavia, mantenere aspettative realistiche sulle capacità attuali degli agenti AI diventa fondamentale per evitare delusioni costose e ritardi progettuali. La domanda centrale non è più "quanto velocemente posso generare codice", ma piuttosto "quale codice merita di essere spedito in produzione, come garantirne la sicurezza e dove allocare risorse per scalarlo efficacemente". In questo scenario, il successo appartiene a chi padroneggia l'ingegneria di sistemi durevoli, non semplicemente a chi sa dialogare con un'intelligenza artificiale.