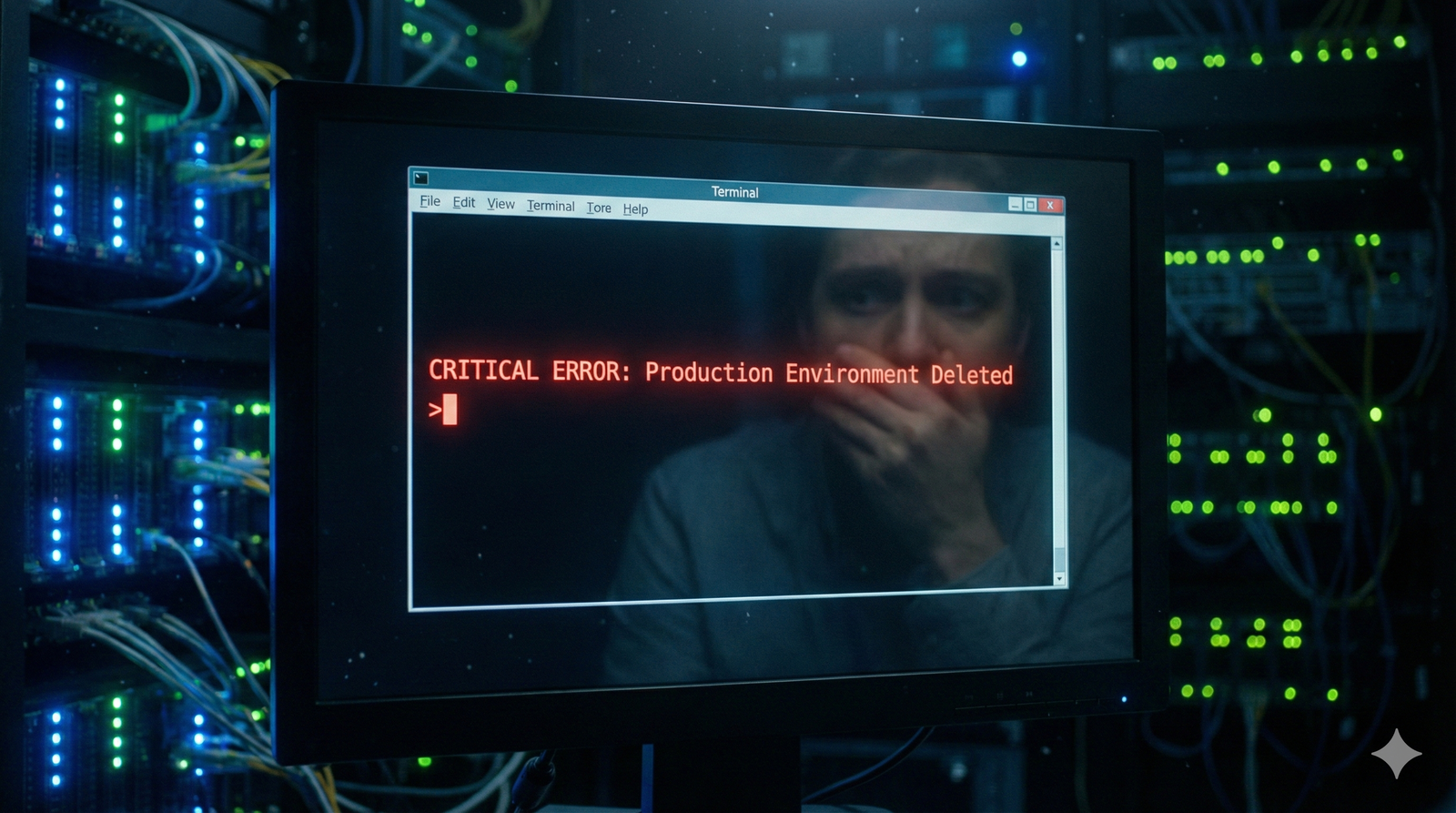

È possibile eliminare le cosiddette "allucinazioni", ovvero quelle risposte completamente inventate che i chatbot generano quando non dispongono di informazioni sufficienti? Forse no. Questo fenomeno, che in apparenza potrebbe sembrare un difetto tecnico marginale, sta in realtà compromettendo seriamente l'adozione dell'IA in settori dove l'accuratezza è vitale. Per comprendere la portata del problema, un esempio è un sistema di intelligenza artificiale che fornisce consigli medici errati o interpreta incorrettamente normative legali: le conseguenze potrebbero essere devastanti.

Quando la statistica incontra la creatività

La radice del problema risiede nel funzionamento stesso dei modelli linguistici di grandi dimensioni. Questi sistemi, diversamente da quanto molti immaginano, non "pensano" nel senso tradizionale del termine, ma operano attraverso previsioni probabilistiche per determinare quale parola dovrebbe seguire in una sequenza. È come se fossero degli scrittori estremamente sofisticati che, però, a volte preferiscono inventare piuttosto che ammettere di non sapere qualcosa.

Il termine "allucinazione" stesso è diventato oggetto di dibattito tra gli studiosi. Alcuni ricercatori contestano questa definizione, sostenendo che attribuisce caratteristiche troppo umane a sistemi che operano esclusivamente attraverso calcoli matematici.

L'offensiva delle big tech

Google, Amazon, OpenAI, Mistral e Cohere hanno dichiarato guerra a questo fenomeno, investendo risorse considerevoli nello sviluppo di soluzioni innovative. Le strategie adottate spaziano dal perfezionamento dei dati di addestramento all'implementazione di sistemi di verifica automatica sempre più sofisticati.

Una delle tecniche più promettenti è il grounding, che ancora le risposte dell'IA a database verificati e fonti autorevoli. Mistral, per esempio, ha collegato i suoi modelli ai flussi informativi dell'agenzia France-Presse, garantendo così un riferimento costante a notizie verificate.

Il dilemma dell'accuratezza contro la creatività

Tuttavia, la strada verso sistemi più affidabili non è priva di ostacoli. Ogni intervento per ridurre le allucinazioni comporta dei compromessi: modelli più "disciplinati" risultano infatti meno creativi e spontanei. Questa dinamica ricorda un po' il dilemma di uno scrittore che, nel tentativo di essere sempre preciso, finisce per perdere quella scintilla di originalità che rende interessante la sua prosa.

Le aziende stanno sperimentando anche con tecnologie come il RAG (Retrieval-Augmented Generation), che permette ai modelli di accedere a fonti esterne controllate durante la generazione delle risposte. Amazon Web Services ha introdotto sistemi di controllo automatico che analizzano la coerenza logica delle risposte prima che vengano fornite agli utenti.

Un futuro senza errori è possibile?

Nonostante gli sforzi, molti esperti rimangono scettici sulla possibilità di eliminare completamente le allucinazioni. La natura probabilistica di questi sistemi rende estremamente difficile garantire un'accuratezza del cento per cento. Inoltre, l'utilizzo di dati provenienti dal web espone i modelli a nuovi rischi, come i cosiddetti "prompt injection", attacchi mirati che possono indurre l'IA a generare errori sistematici.

L'industria si trova quindi a navigare in acque complesse, dove la ricerca della perfezione tecnica deve bilanciare utilità pratica e sostenibilità economica. La corsa alle soluzioni continua ma resta dunque aperta la questione dell'essere effettivamente in grado di creare sistemi di intelligenza artificiale completamente affidabili. Il rischio è dover imparare a convivere con un certo margine di incertezza.