-

Pro

- Prestazioni

- 16GB di memoria video

- Prezzo di listino

-

Contro

- Il prezzo potrebbe essere più alto di quello dichiarato

Il verdetto di Tom's Hardware

Informazioni sul prodotto

Dopo l'enorme successo delle due Radeon RX 9070, in particolare per la variante XT (qui trovate la recensione, nel caso ve la foste persa), c'è grande attesa per la AMD Radeon RX 9060 XT. La scheda va a competere direttamente con la RTX 5060 Ti (qui la recensione), debuttando sul mercato a un prezzo decisamente più basso: 374,90 euro (per il modello 16GB), contro i 459 euro della controparte NVIDIA.

Entrambe le GPU arrivano in due varianti, equipaggiate con 8GB e 16GB di memoria video; inutile dire che la versione più interessante è la seconda, visto che, come abbiamo già ribadito più volte, 8GB sono ormai insufficienti, specialmente per schede che permettono di giocare senza particolari problemi anche a risoluzione Quad HD. Il consiglio, quindi, è quello di optare per la versione con più VRAM, indipendentemente da quale delle due deciderete di acquistare.

Recensione in un minuto

La nuova AMD Radeon RX 9060 XT è una scheda video pensata per il gaming in Quad HD, che si posiziona come diretta rivale della NVIDIA RTX 5060 Ti, ma con un prezzo molto più aggressivo: 374,90€ per la versione da 16GB, contro i 459€ della concorrente. In rasterizzazione le due GPU si equivalgono, con la Radeon che vince in alcuni titoli e perde in altri, garantendo comunque framerate solidi anche con dettagli al massimo nei giochi più recenti. In ray tracing la RTX mantiene un vantaggio grazie alle tecnologie avanzate di Frame Generation, ma AMD si difende bene ed è sempre possibile usare Fluid Motion Frames, che permette di raddoppiare gli FPS a patto di accettare un lieve calo nella qualità visiva. La RX 9060 XT consuma poco, resta fresca anche sotto stress e offre un ottimo bilanciamento tra prestazioni e prezzo. Se il costo resterà vicino al listino, è la scelta ideale per chi punta al QHD a 60 FPS o al Full HD a framerate molto elevati, senza compromettere il portafoglio.

Com'è fatta

La nuova Radeon RX 9060 XT sfrutta una GPU Navi 44, basata su architettura RDNA 4 e prodotta con il processo N4P di TSMC. Il die misura 199 mm2 e conta 29,7 miliardi di transistor, che danno vita a 32 Compute Unit (per un totale di 2048 Stream Processor), 32 Ray Accelerator e 64 AI Accelerator. Le specifiche di base offrono un Game Clock di 2530 MHz e un Boost Clock fino a 3130 MHz, ma la personalizzazione Sapphire Pulse che abbiamo ricevuto (non esiste un design Reference nemmeno per la 9060 XT) è più veloce, con un Game Clock di 2700 MHz e un Boost Clock fino a 3290 MHz.

Ci sono poi 32MB di Infinity Cache di terza generazione, oltre a 16GB di memoria video GDDR6 che operano a 20Gbps su un bus 128-bit, per una larghezza di banda totale di 322,3 GB/s. Il TDP di riferimento è 160 watt (150 watt per il modello 8GB), ma la nostra personalizzazione (come molte altre) arriva a 180 watt, con un singolo connettore 8 pin per l'alimentazione.

Per quanto riguarda le uscite video abbiamo a disposizione una DisplayPort 2.1a e due HDMI, più che sufficienti anche per le configurazioni multi-monitor.

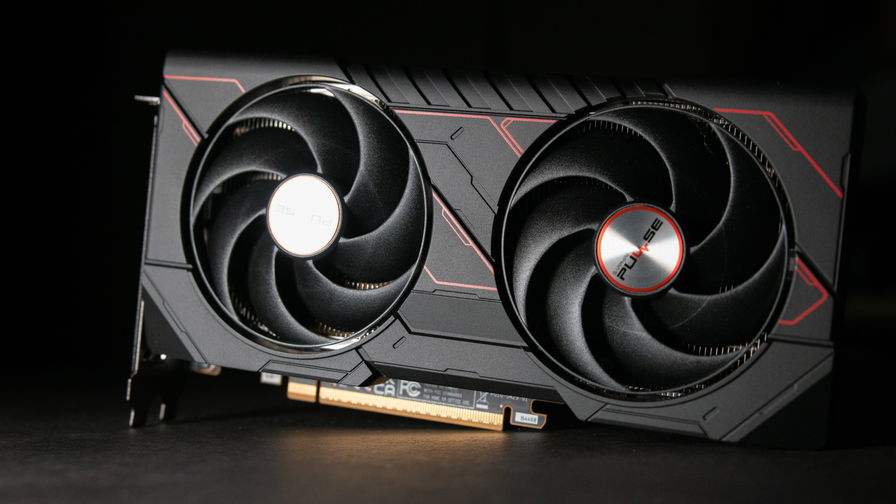

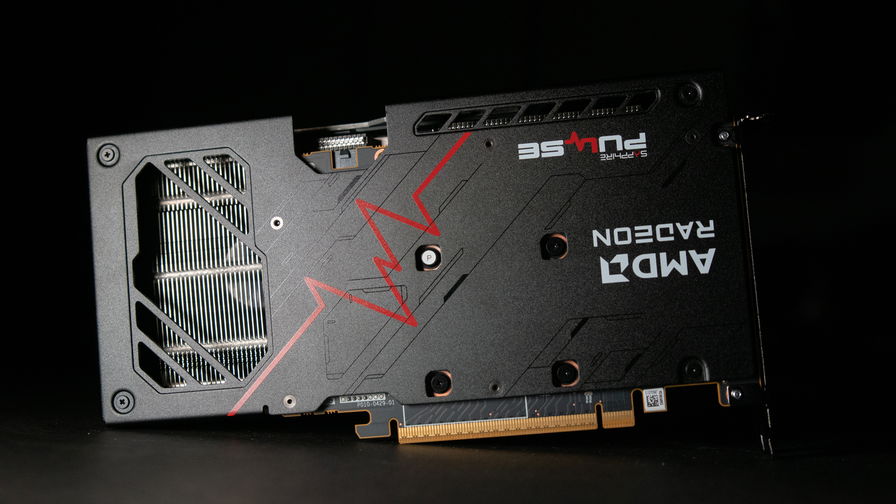

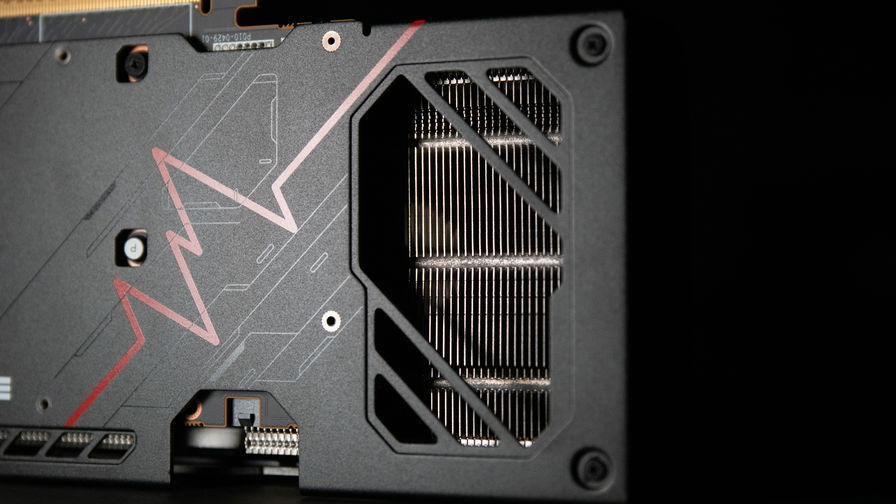

Il modello Sapphire Pulse che abbiamo ricevuto è abbastanza compatto, con una lunghezza di 244 mm e uno spessore di 2,3 slot. Il design segue le classiche linee di questa personalizzazione, con una scocca nera e dei dettagli rossi, con la scritta "Pulse" ben impressa sul backplate in metallo e sulle ventole.

Il raffreddamento Dual-X Cooling impiega due ventole con lame AeroCurve e dell'Honeywell PTM7950 al posto della classica pasta termica, così da efficientare il trasferimento di calore e migliorare la dissipazione. Il PCB è molto corto e permette di avere anche su un modello biventola come questo un foro nel backplate abbastanza ampio, che fa fluire l'aria mossa dalla seconda ventole e migliora ulteriormente il raffreddamento, assicuramento temperature sempre contenute.

Prestazioni

Per le performance della RX 9060 XT ci siamo concentrati sui giochi, senza però trascurare anche la creazione di contenuti e l'intelligenza artificiale, ambiti che abbiamo testato con dei software specifici. La piattaforma di prova è sempre la stessa, con un processore AMD Ryzen 7 9800X3D su una scheda madre X870E, abbinato a 64GB di RAM DDR4-6000 con profilo EXPO attivo.

Qui sotto vi lasciamo una tabella riepilogativa con i giochi testati, le impostazioni usate e le versioni dell'upscaler che abbiamo attivato nei test con Ray Tracing, che si tratti di DLSS, FSR o XeSS. Con "DLSS 4" indichiamo la versione con Multi Frame Generation, tecnologia presente unicamente sulle GPU RTX 50.

| Gioco | Qualità | Upscaler | Dove acquistarlo |

| Cyberpunk 2077 | Ultra - RT Ultra | DLSS 4 (RTX 50) DLSS 3 (RTX 40) FSR 3 (AMD) XeSS (Intel) |

Instant Gaming |

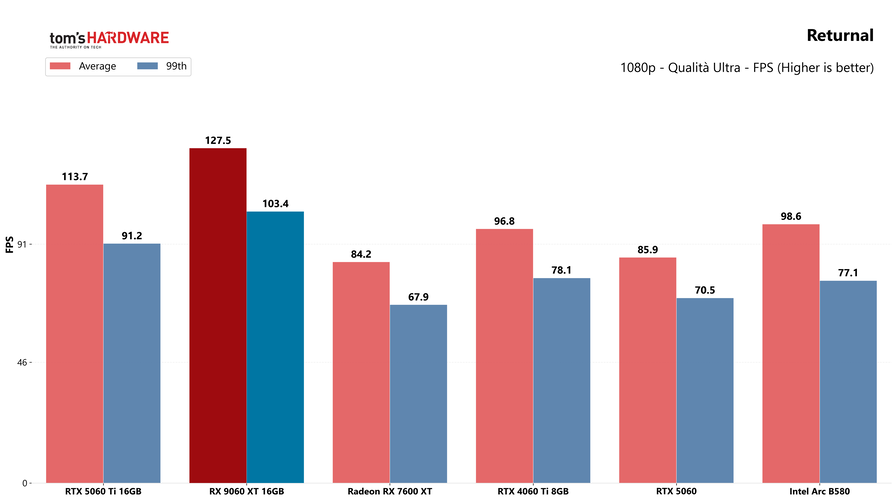

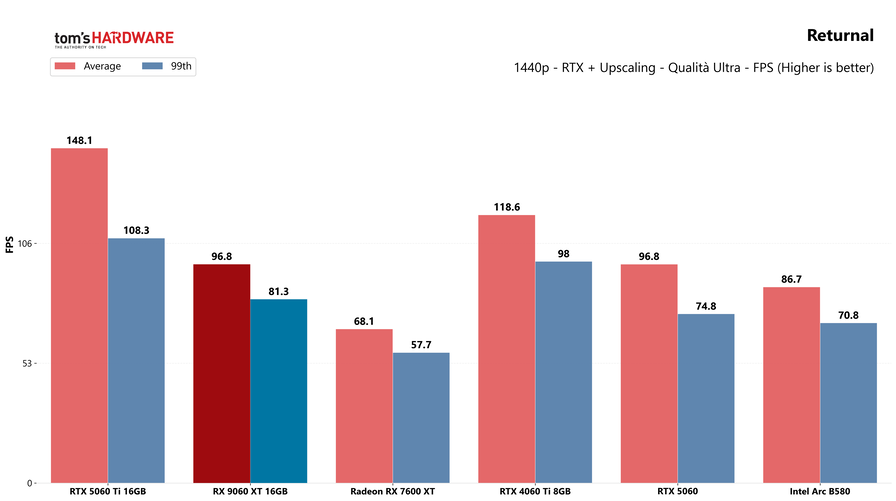

| Returnal | Epico - RT Max | DLSS 3 (NVIDIA) FSR 2 (AMD) XeSS (Intel) |

Instant Gaming |

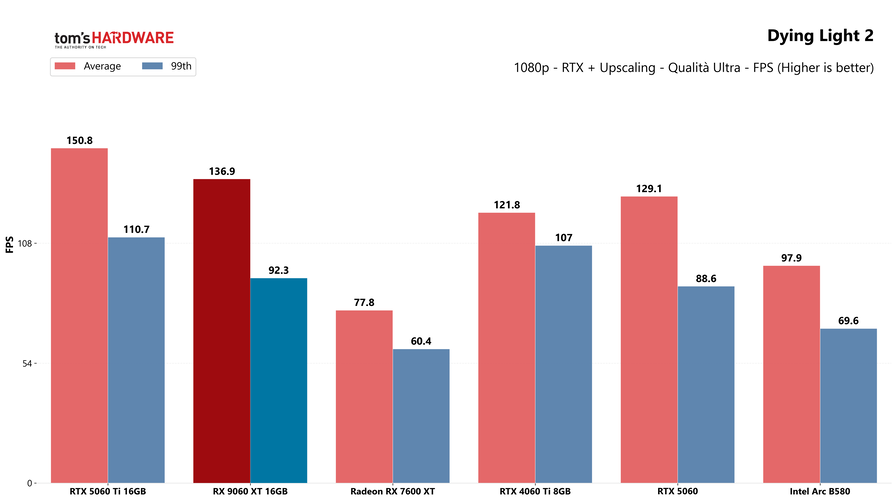

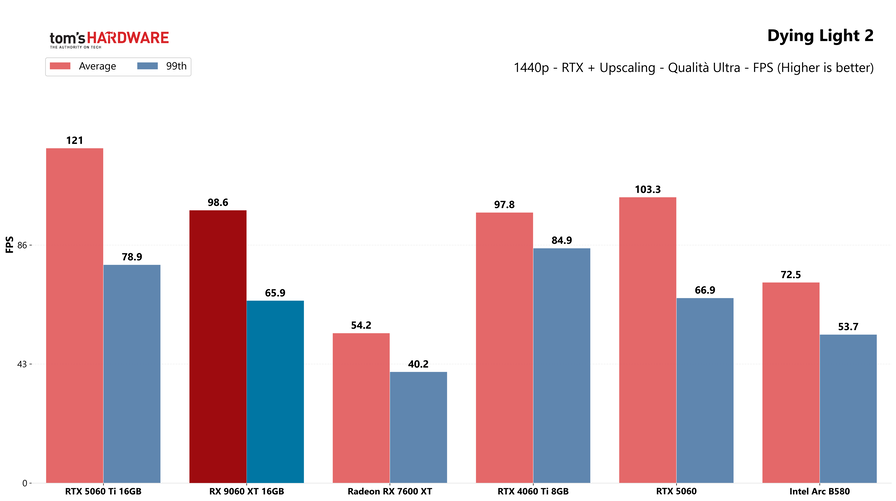

| Dying Light 2 | Ultra - RT Alta qualità | DLSS 3 (NVIDIA) FSR 2 (AMD) XeSS (Intel) |

Instant Gaming |

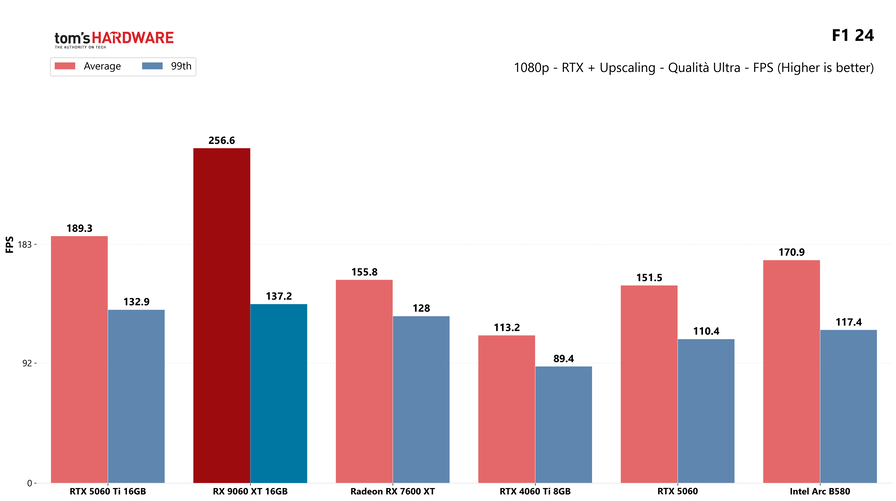

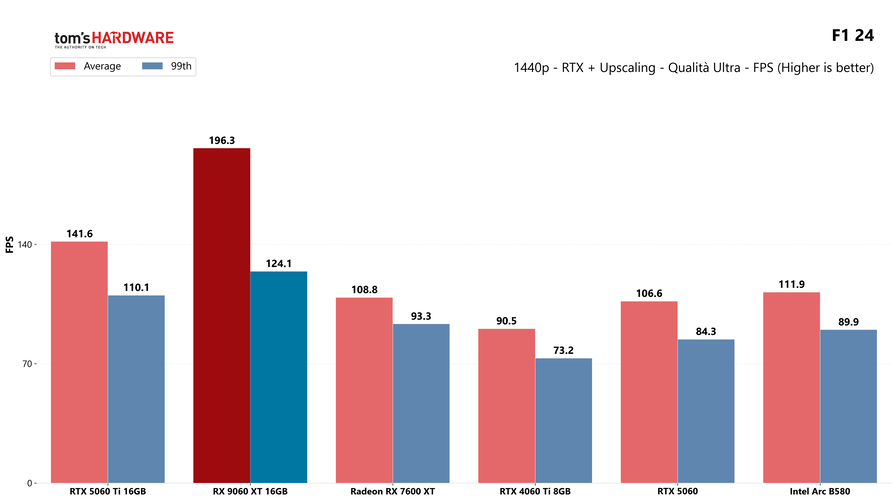

| F1 24 | Altissimo - RT Alto | DLSS 3 (NVIDIA) FSR 3 (AMD) XeSS 2.1 (Intel) |

Instant Gaming |

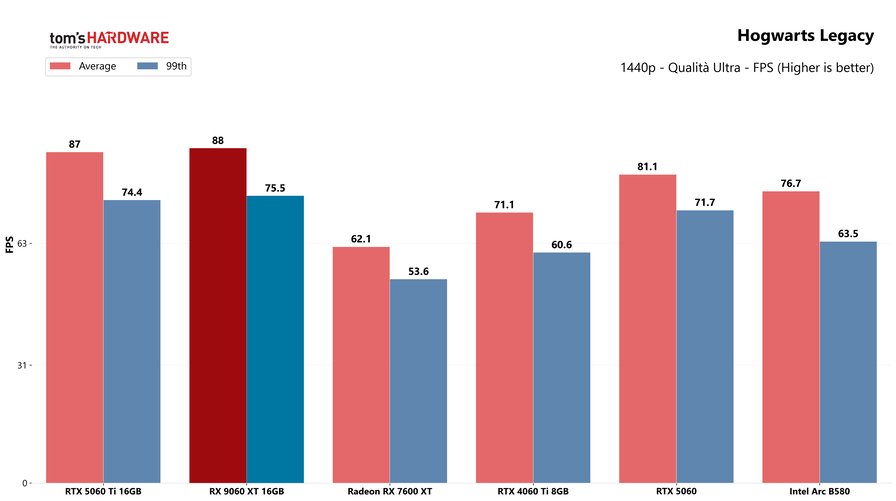

| Hogwarts Legacy | Ultra - RT Ultra | DLSS 4 (RTX 50) DLSS 3 (RTX 40) FSR 2 (AMD) |

Instant Gaming |

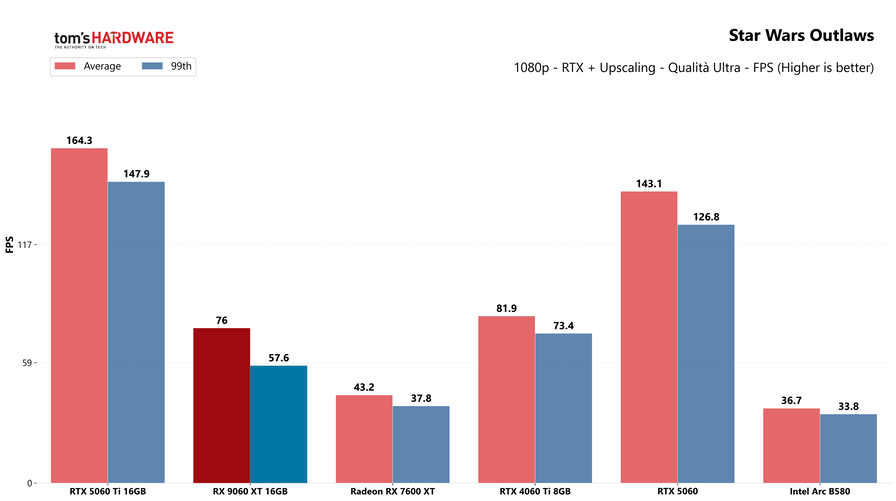

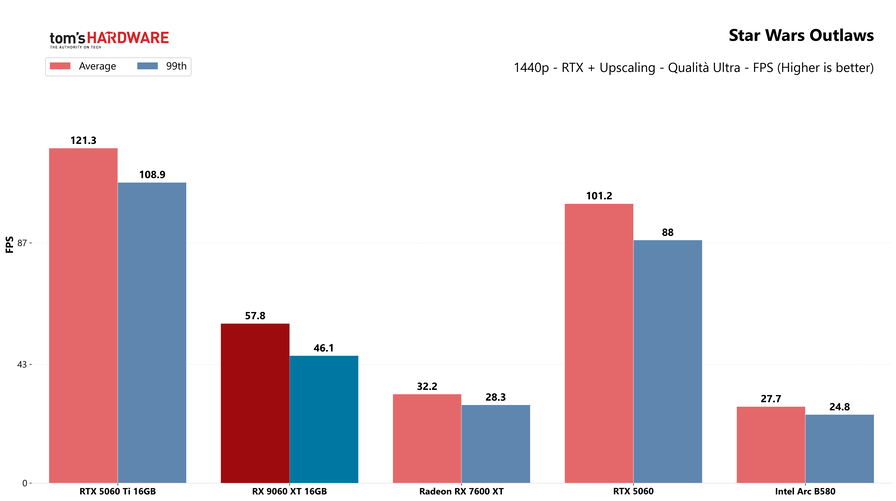

| Star Wars Outlaws | Ultra - RT Ultra | DLSS 4 (RTX 50) DLSS 3 (RTX 40) FSR 3 (AMD) |

Instant Gaming |

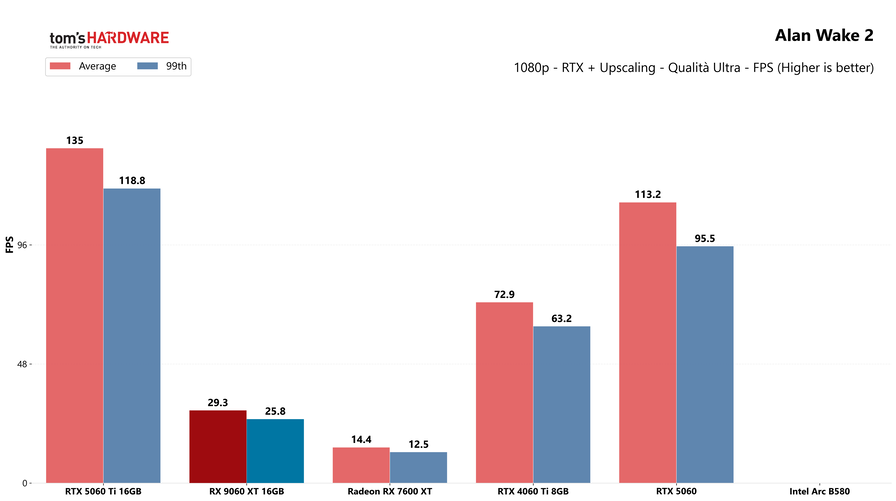

| Alan Wake 2 | Ultra - PT Ultra | DLSS 4 (RTX 50) DLSS 3 (RTX 40) FSR 2 (AMD) |

Instant Gaming |

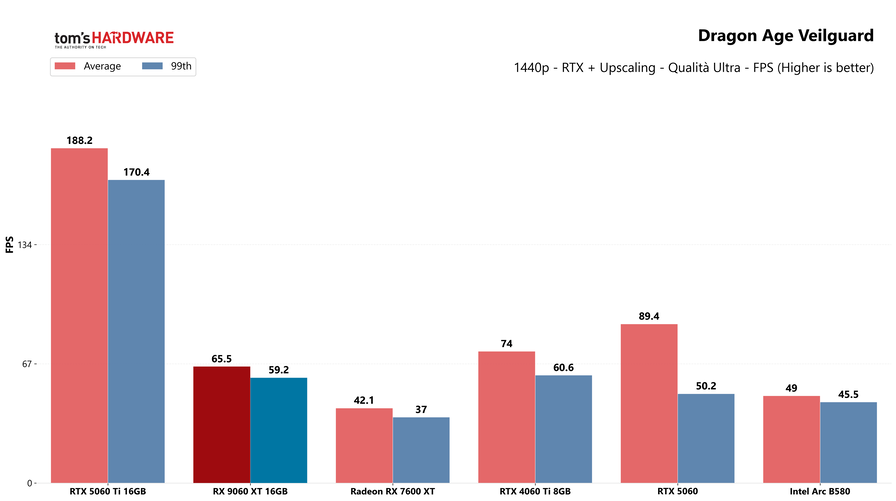

| Dragon Age Veilguard | Ultra - RT Ultra | DLSS 4 (RTX 50) DLSS 3 (RTX 40) FSR 2 (AMD) |

Instant Gaming |

| Avatar Frontier's of Pandora | Ultra - RT Ultra | DLSS 2 (NVIDIA) FSR 3 (AMD) |

Instant Gaming |

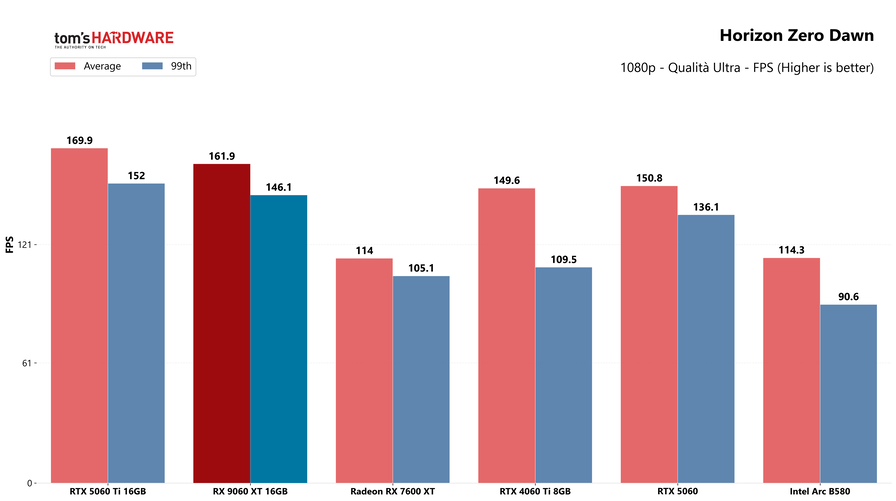

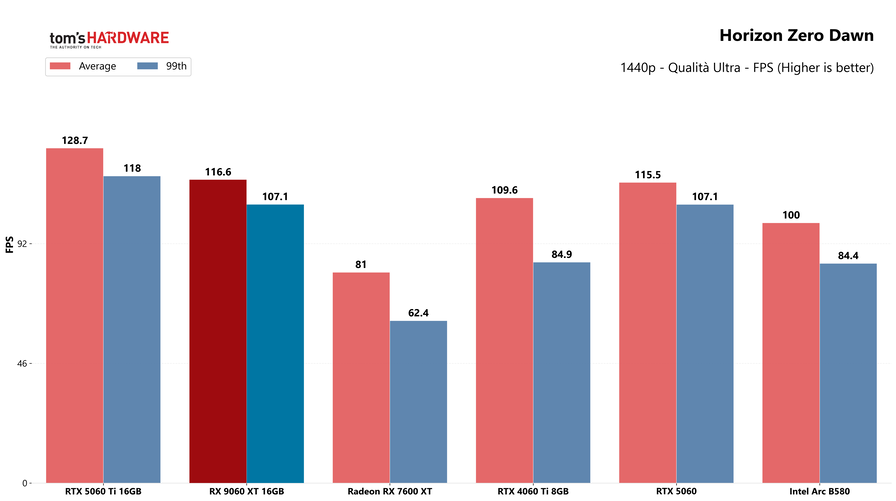

| Horizon Zero Dawn | Eccellente | - | Instant Gaming |

| Doom Eternal | Ultra-Incubo | - | Instant Gaming |

| Far Cry 6 | Ultra | - | Instant Gaming |

Prestazioni nei giochi

Sfidando la RTX 5060 Ti, questa RX 9060 XT punta al gaming in 1440p, risoluzione che sta sempre più soppiantando il 1080p come riferimento, visto che i migliori monitor sul mercato coniugano QHD e frequenze di aggiornamento elevatissime, per accontentare sia gli amanti dei tripla A che vogliono la miglior qualità grafica possibile e i giocatori di titoli eSport, la cui priorità assoluta è il framerate.

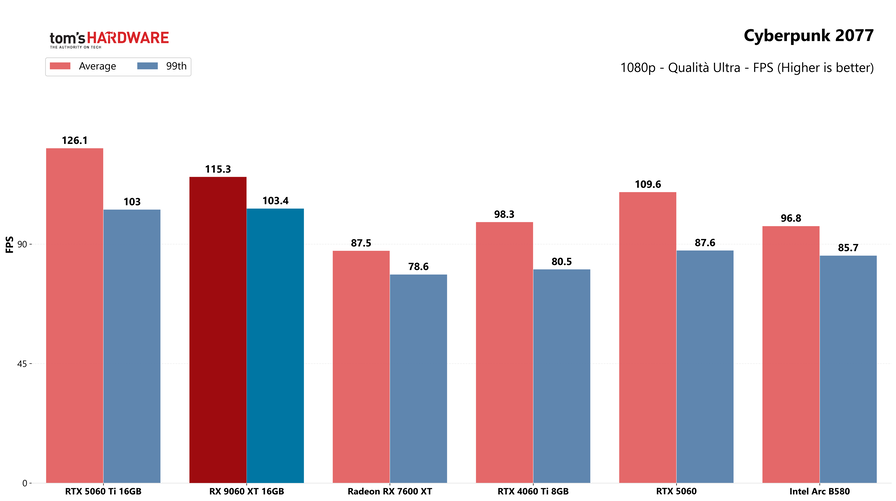

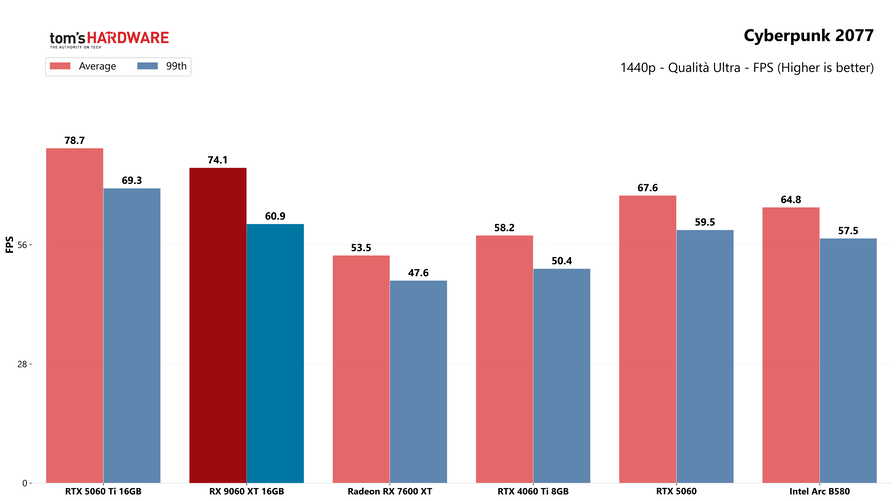

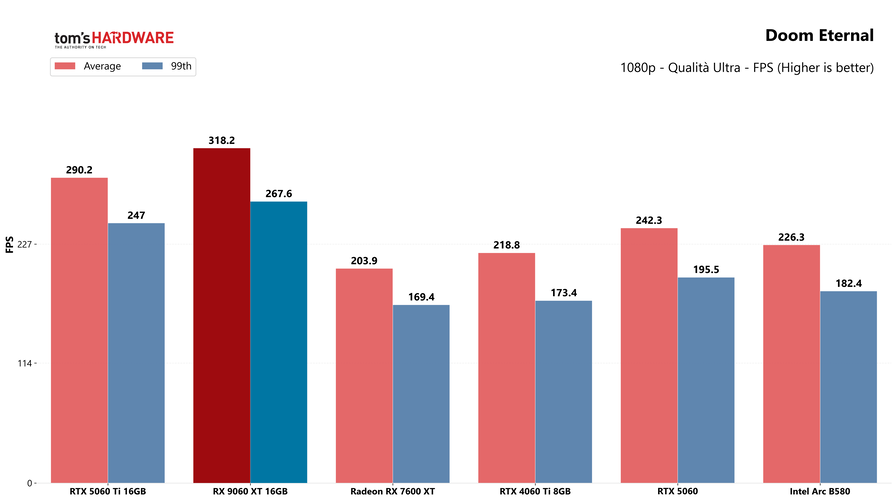

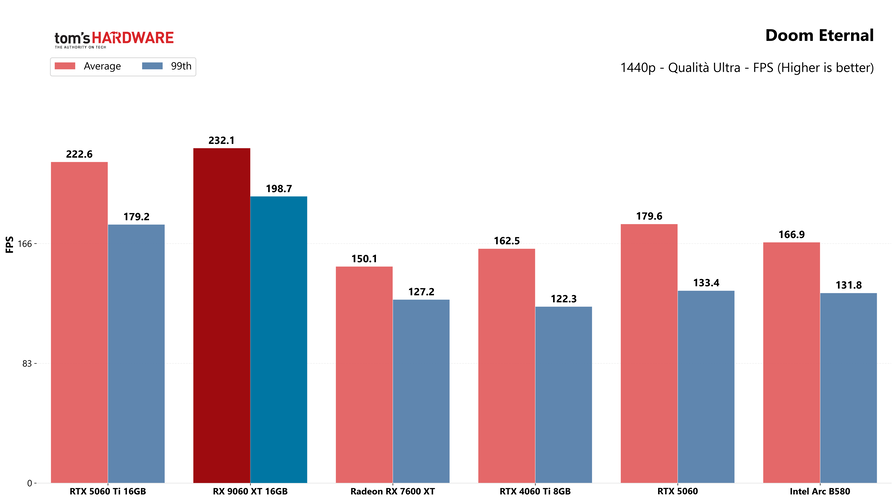

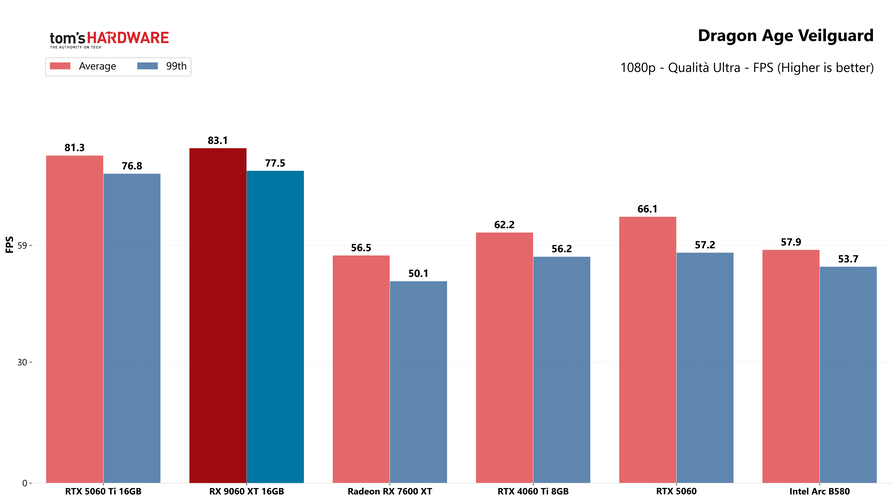

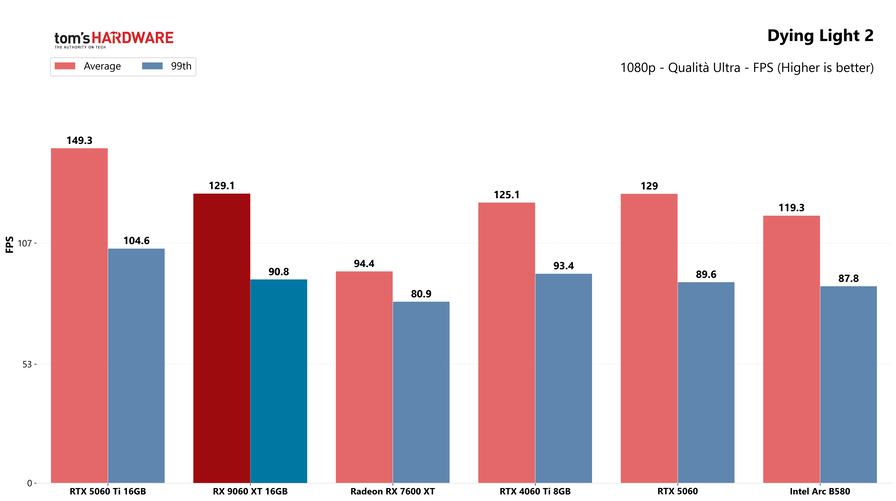

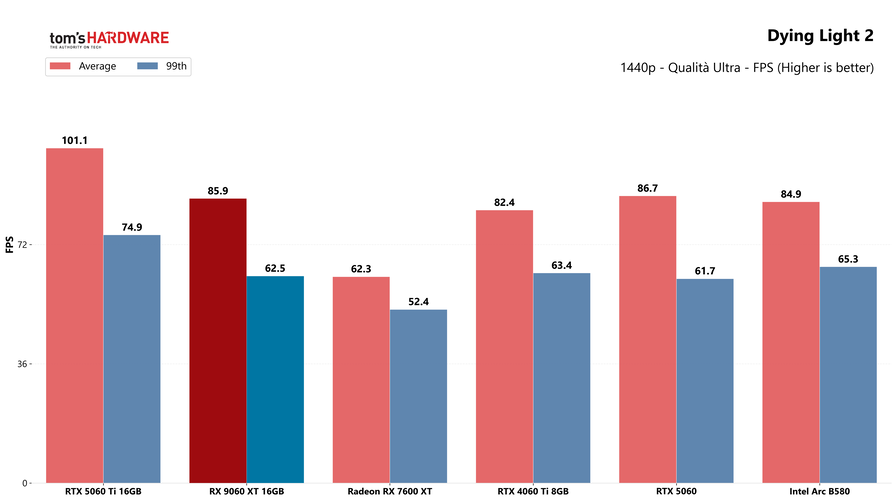

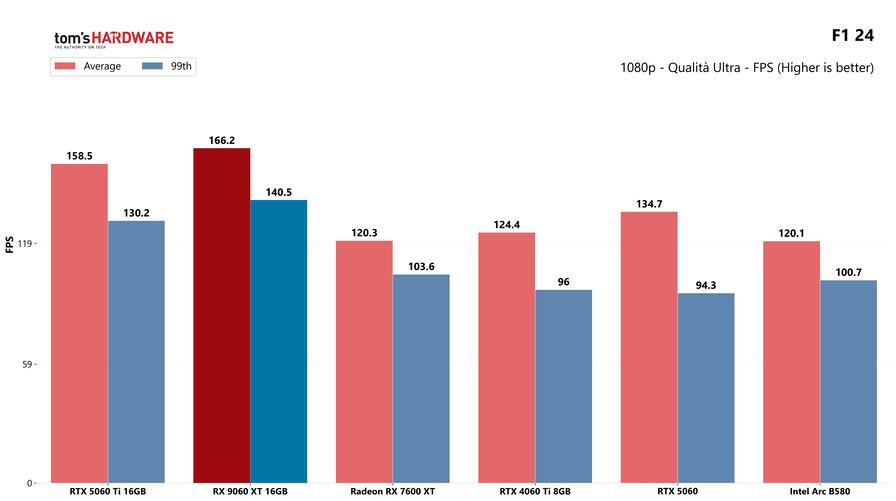

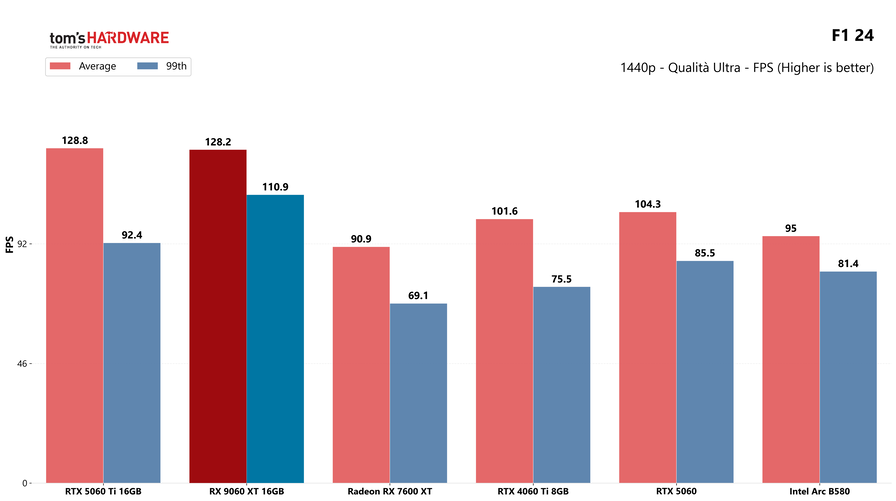

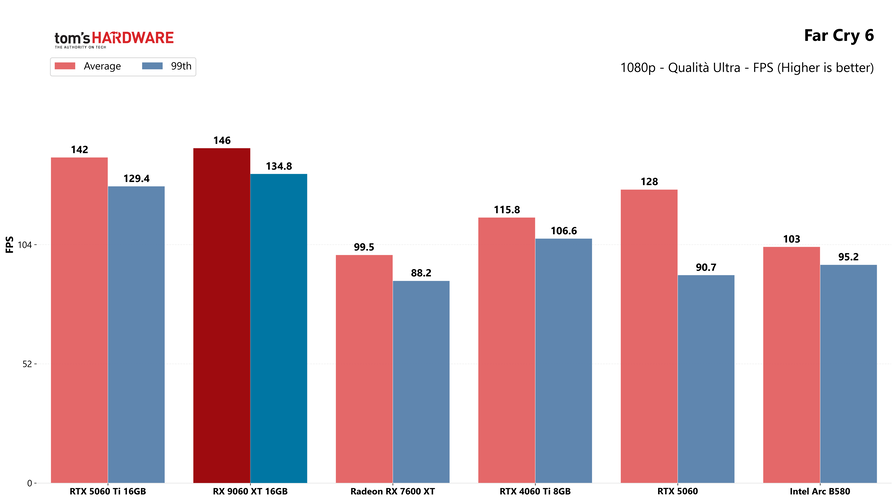

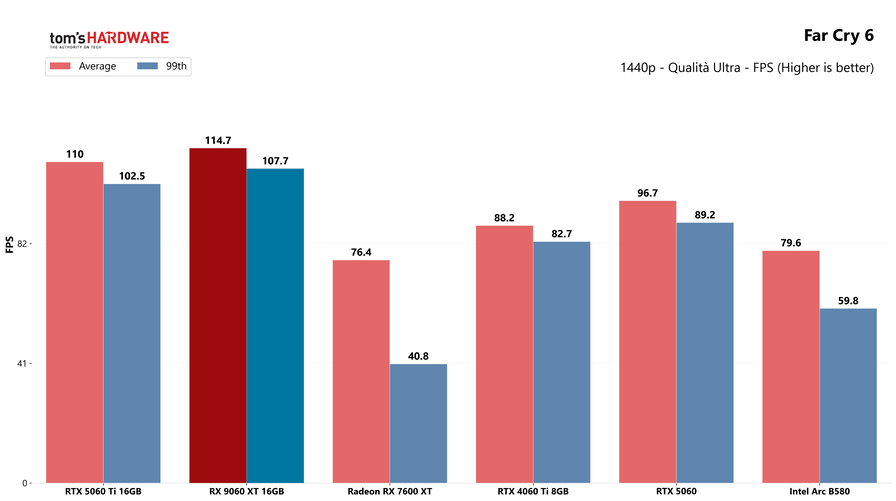

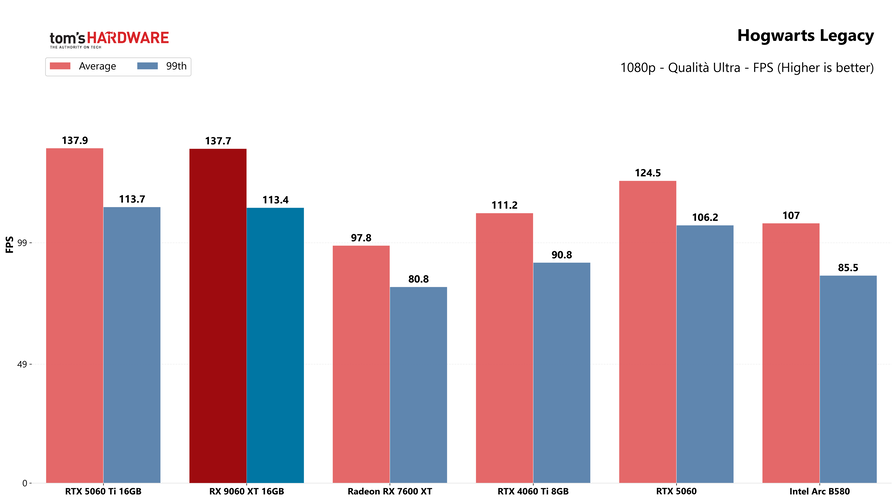

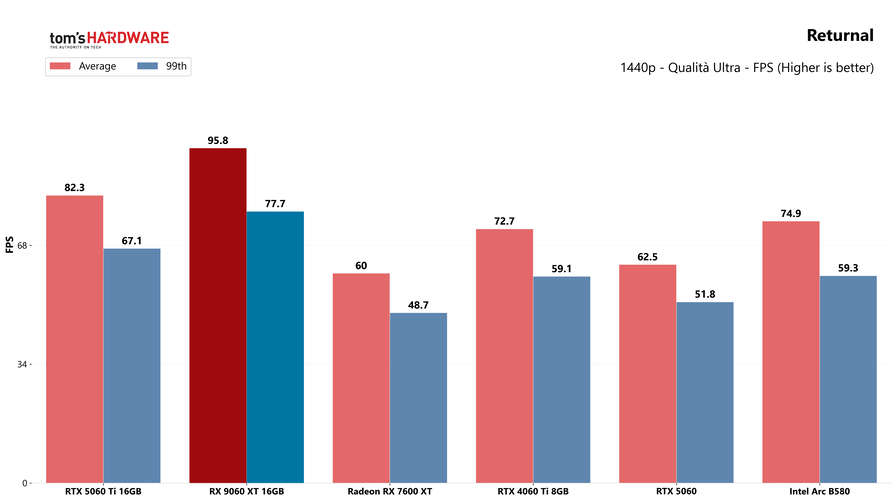

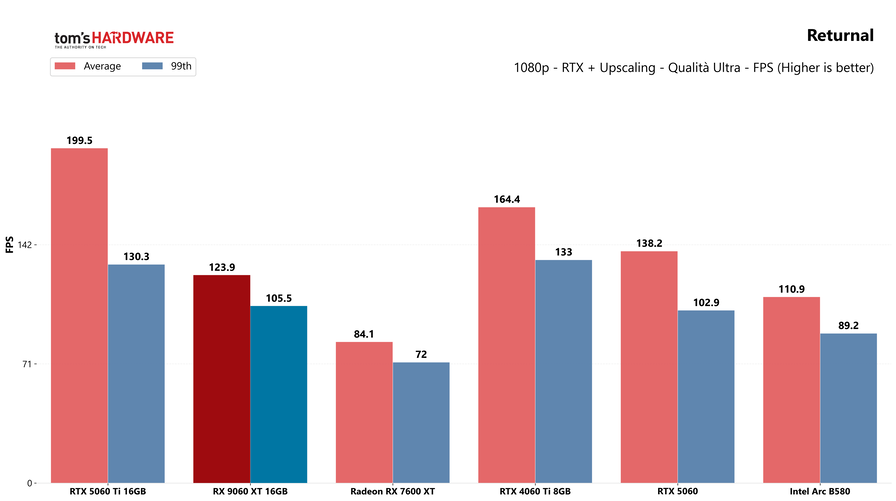

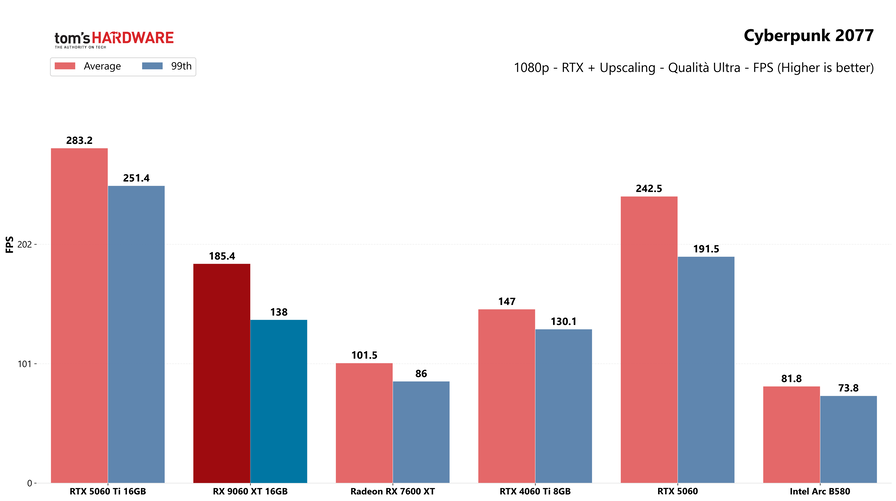

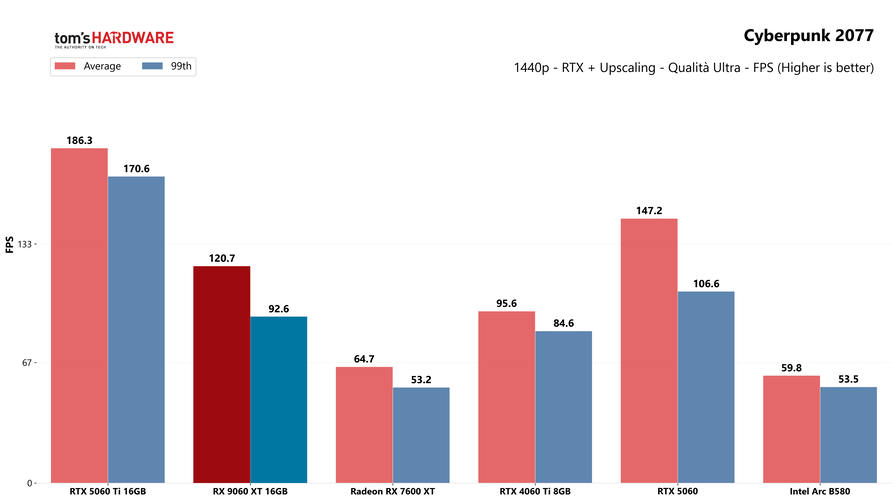

Come sempre partiamo dalla resterizzazione, ambito dove la Radeon si comporta meglio: la battaglia con la RTX 5060 Ti è serrata, facendo una media di tutti i giochi provati, possiamo dire che le due schede si equivalgono. La RX 9060 XT è più veloce in alcuni titoli (Returnal, Far Cry) e più lenta in altri (Cyberpunk 2077, Dying Light 2), ma nella maggior parte delle situazioni il framerate medio è praticamente lo stesso.

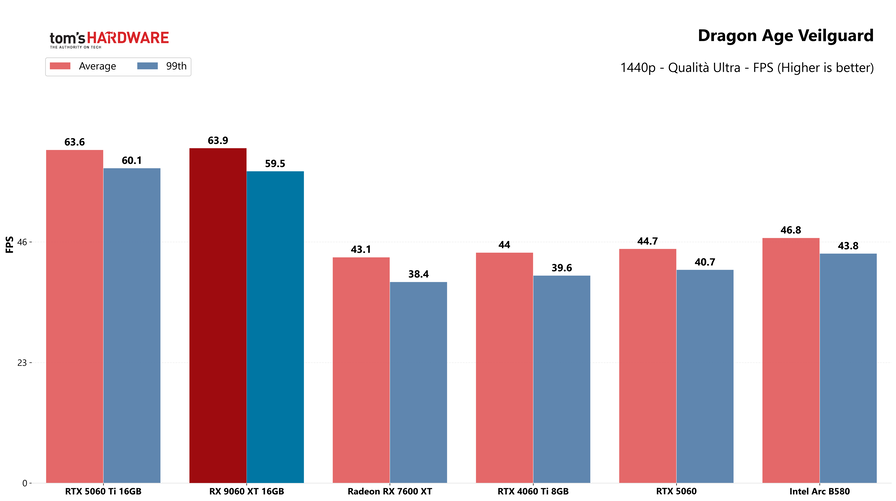

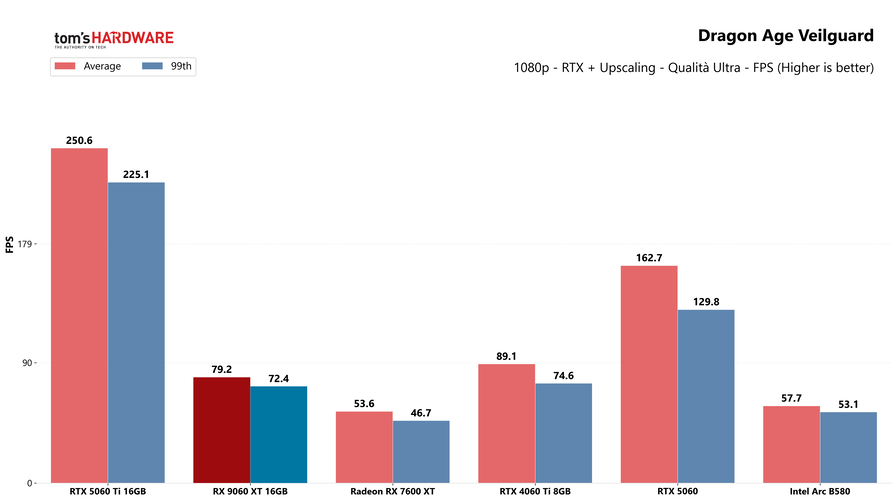

FPS alla mano, la RX 9060 XT permette di giocare in QHD a 60 FPS con dettagli massimi praticamente a qualsiasi gioco moderno, anche i più impegnativi da gestire: Dragon Age Veilguard è il peggiore nei nostri test, ma con una media di 64 FPS e un percentile di 59,5 FPS, rimane praticamente sempre sopra la soglia critica dei 60 fotogrammi al secondo. Ovviamente nessun problema a risoluzione Full HD, dove la GPU raggiunge sempre framerate elevati.

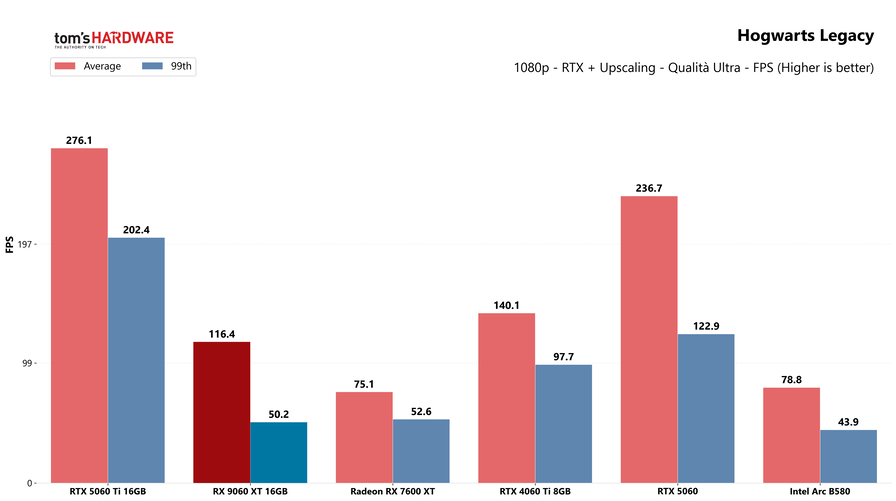

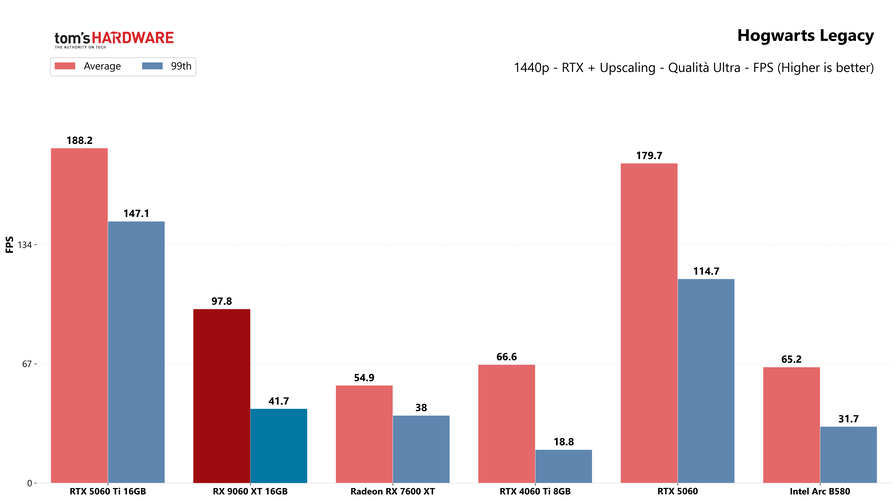

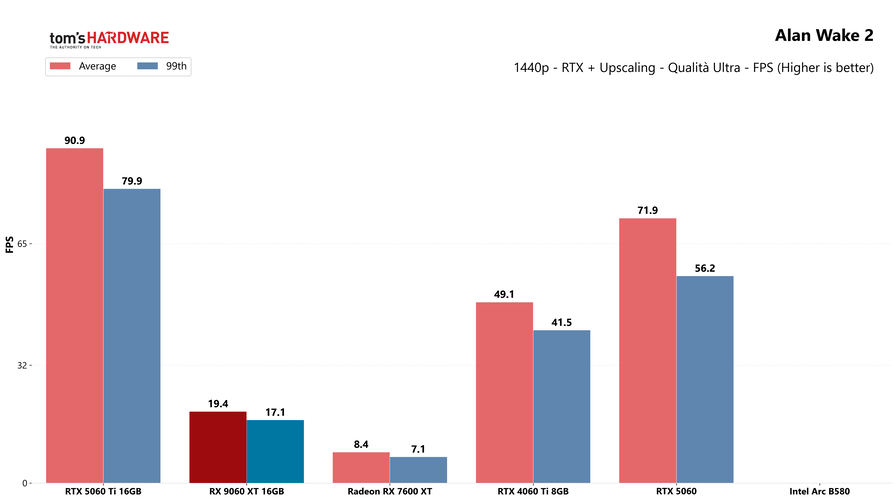

Attivando il ray tracing la situazione è a favore di NVIDIA, come sempre per merito delle tecnologie di Frame Generation (singola e multipla) presenti in molti più giochi rispetto a quella AMD. Questo non significa però che la RX 9060 XT non riesca comunque a farvi giocare: anche in questo caso, il 1440p a 60 FPS viene raggiunto in quasi tutti i titoli provati, fatta eccezione per quelli dove gli effetti sono più impegnativi da gestire, come Star Wars Outlaws e Alan Wake 2, quest'ultimo solamente giocabile in 1080p se si attiva il path tracing. Come visto sulle RX 9070, la nuova versione del Fluid Motion Frames si dimostra un aiuto decisamente concreto: la tecnologia di generazione a livello driver di AMD, di fatto, raddoppia il framerate a discapito della qualità grafica, che cala leggermente. Attivandola la giocabilità migliora di netto, con Star Wars Outlaws che ad esempio supera di slancio i 100 FPS medi.

Prestazioni con IA e creazione di contenuti

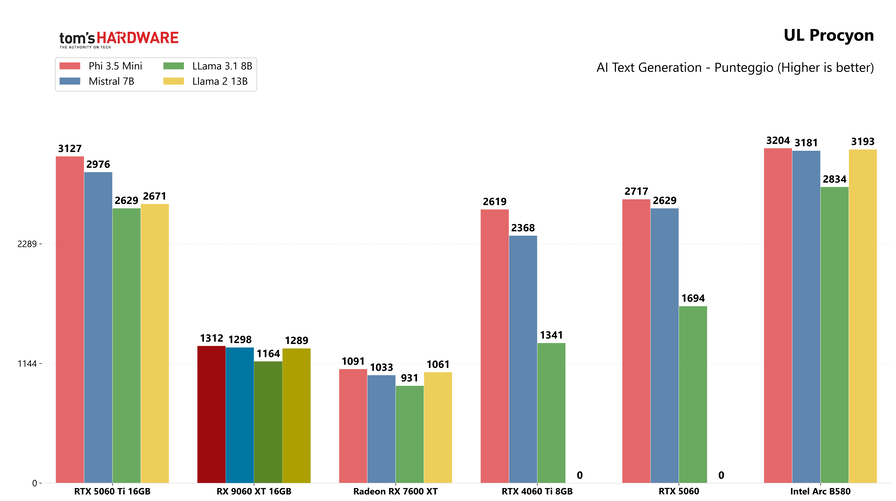

I benchmark relativi all'intelligenza artificiale sorridono come sempre a NVIDIA: la Radeon RX 9060 XT migliora di oltre il 20% i risultati della vecchia RX 7600 XT, ma rimane ampiamente dietro la RTX 5060 Ti, in media di oltre il 50%; la nuova scheda AMD è perfino più lenta della RTX 5060 in quest'ambito, segno che è stata progettata prima di tutto per videogiocare.

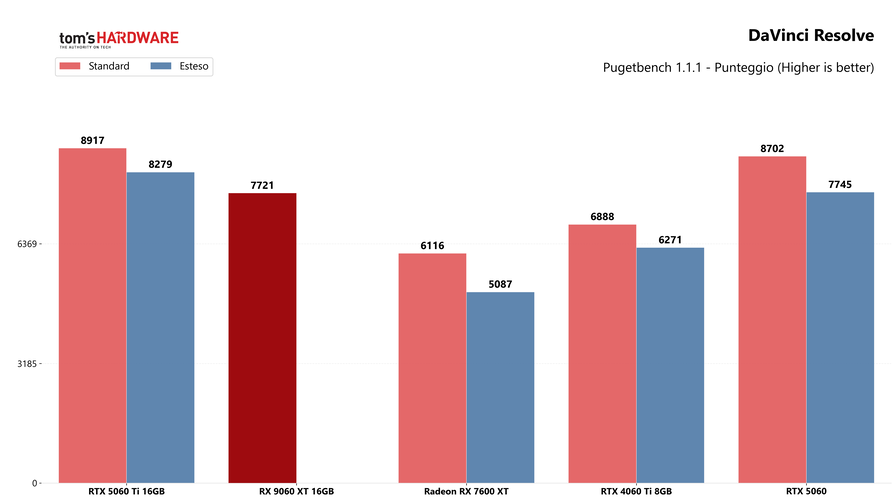

la situazione è molto simile nella creazione di contenuti, anche se il divario è meno netto: in DaVinci Resolve la RX 9060 XT è il 26% più veloce della RX 7600 XT è solo il 13% circa più lenta della RTX 5060 Ti, tuttavia come le due RX 9070 non riesce a completare correttamente il benchmark esteso di PugetBench a causa di un crash durante l'analisi di una clip audio; abbiamo eseguito il test più volte senza successo e, nel medesimo punto, le altre GPU testate non hanno avuto problemi, segno che si tratta quasi sicuramente di qualcosa da risolvere a livello driver.

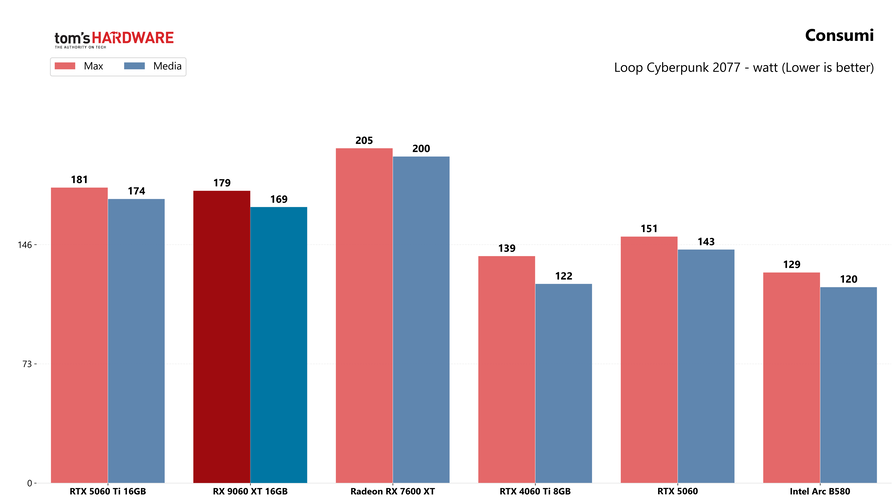

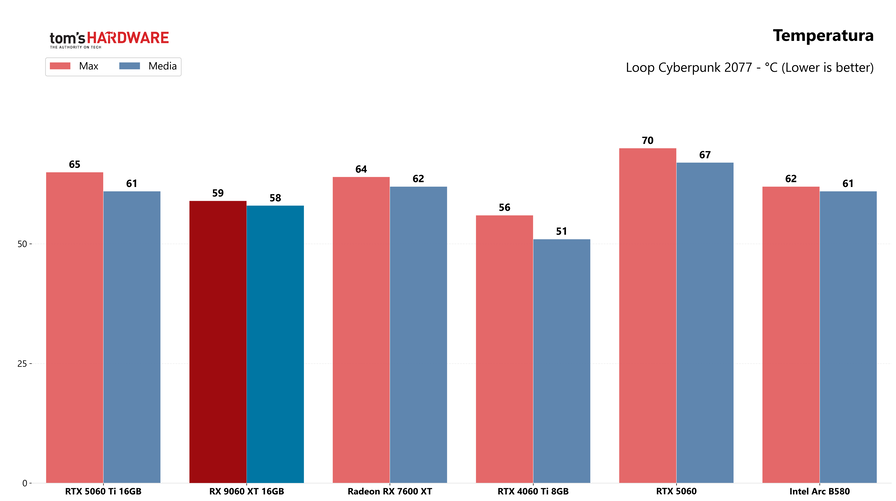

Consumi e temperature

I consumi sono in linea con le aspettative, con un valore di picco di 179 watt, perfettamente in linea con il TDP di 180 watt, e una media di 169 watt. La scheda non si discosta molto dalla RTX 5060 Ti, che fa registrare una media di 174 watt, mentre è decisamente meno energivora della precedente RX 7600 XT, che nei nostri test ha raggiunto un consumo medio di 200 watt.

La RX 9060 XT è sempre estremamente fresca, anche durante una sessione di gioco prolungata: nei nostri test la temperatura è stata sempre molto stabile, con un picco di 59°C che è poi sceso leggermente per assestarsi su una media di 58°C. È più fresca sia della RTX 5060 Ti, che non scende sotto i 61°C, che della RTX 5060, che fa registrare una media di 67°C.

Verdetto

L'AMD Radeon RX 9060 XT aveva il difficile compito di replicare quanto fatto dalla RX 9070 XT: offrire una scheda video dal rapporto prezzo / prestazioni eccellente, che fosse la scelta giusta per la stragrande maggioranza dei videogiocatori che puntano, in questo caso, al Quad HD 60 FPS o al Full HD ad alti FPS. Ci è riuscita? Decisamente.

Riassumendo velocemente, con la nostra suite di test in rasterizzazione è veloce mediamente quanto la RTX 5060 Ti, sua diretta concorrente, e permette di giocare in 1440p a dettagli massimi anche ai titoli più recenti. In ray tracing la GPU NVIDIA rimane superiore grazie a una maggior diffusione delle tech di frame generation (singola e multipla), tuttavia la Radeon offre comunque buone prestazioni in 1440p e può sfruttare AFMF, per raddoppiare il framerate sacrificando (di poco) la qualità. Vale la pena specificare che Fluid Motion Frames, un po' come la Frame Generation integrata in FSR e DLSS, opera al meglio dai 40 FPS in sù; al di sotto iniziano a diventare evidenti alcuni problemi di ghosting, che peggiorano l'esperienza di gioco (in alcuni casi, anche di molto).

L'asso nella manica della GPU Radeon è però il prezzo, nettamente inferiore a quello della RTX 5060 Ti: la variante 16GB (che, ribadiamo, è l'unica che vale davvero la pena considerare) debutta a 374,90€, mentre la RTX 5060 Ti costa 459€. Una differenza di 85€ che pesa parecchio, specialmente in questa fascia dove ogni euro conta, spostando l'ago della bilancia a favore di AMD.

In questa situazione, se siete alla ricerca di una GPU per il vostro PC da gaming, a meno che non vogliate la miglior esperienza possibile in ray tracing (sia in termini di performance che di qualità grafica) usando addirittura il path tracing dove disponibile (ambito dove, come vediamo da Alan Wake 2, la Radeon fatica ancora moltissimo), non avete motivo di preferire la RTX 5060 Ti alla RX 9060 XT. La GPU AMD ha prestazioni equivalenti in raster, vi fa comunque giocare a framerate adeguati in ray tracing e ha un rapporto qualità / prezzo nettamente migliore. Queste considerazioni valgono però solo se la RX 9060 XT si troverà effettivamente al prezzo dichiarato: se, come accaduto per le due RX 9070, il listino dovesse valere solo per i primi giorni e il prezzo dovesse poi aumentare notevolmente, allora il discorso cambierebbe. Per semplificare, potremmo dire che più il prezzo delle due GPU sarà vicino, meno varrà la pena optare per la scheda AMD. E vista la già difficile situazione in cui versa il mercato, non ci resta che sperare che stavolta i prezzi rimangano quanto più vicini possibile a quelli dichiarati, possibilmente per più di una settimana.