Quando interagiamo con un'intelligenza artificiale, soprattutto con i modelli generativi come ChatGPT, siamo spesso colpiti dalla fluidità del linguaggio, dalla coerenza delle risposte e dalla velocità con cui riesce a trattare qualunque argomento. Sembra quasi di parlare con una persona super intelligente, ma questa impressione è, in realtà, un’illusione. Perché un’IA non pensa, non capisce, non ragiona. E, soprattutto, non sa nulla nel senso umano del termine.

E dunque viene da chiedersi: perché le IA, se non pensano, ci dicono le bugie? Da dove nascono le allucinazioni? Cerchiamo di capire meglio cosa c’è dietro a questi fenomeni.

Come “ragiona” un’IA

Per capire da dove nascono le “bugie” o gli errori delle intelligenze artificiali, bisogna partire da qui: non stiamo parlando con un’entità che conosce il mondo, ma con un sistema che ha imparato a prevedere statisticamente le parole. Un modello come GPT-4, ad esempio, è stato addestrato leggendo trilioni di parole da libri, articoli, forum, siti web. Non ha letto per capire, ma per imparare come si forma una frase. L’IA si è nutrita di esempi, e da quegli esempi ha estratto modelli linguistici: strutture ricorrenti, associazioni frequenti tra parole, logiche retoriche, schemi di dialogo.

Tecnicamente, ogni volta che le fai una domanda, l’IA costruisce una risposta una parola alla volta, scegliendo, tra tutte quelle possibili, quella che ha la probabilità più alta di essere la “giusta” parola da dire in quel punto. È come un gioco di completamento automatico, ma spinto all’estremo, in cui ogni parola viene scelta in base a un calcolo basato su milioni di esempi simili.

Per esempio, se le chiedi “Qual è la capitale della Francia?”, la sequenza “capitale della Francia è” ha una fortissima associazione con la parola “Parigi”, perché nei dati che ha visto quella combinazione è apparsa migliaia di volte. Ma se le chiedi qualcosa di meno frequente, qualcosa su cui ha visto dati confusi o incompleti, inizierà a indovinare.

È come se avessi un pappagallo iper-intelligente che ha letto tutta la biblioteca del mondo, ma che non sa cosa vogliano dire davvero le parole. Se gli chiedi di spiegarti la teoria della relatività, te ne parlerà con parole incredibilmente precise e articolate. Ma non perché ha capito Einstein: semplicemente perché ha letto milioni di spiegazioni e ha imparato come suona una spiegazione convincente.

Questo ci porta al primo punto chiave: l’intelligenza artificiale è un sistema di generazione linguistica, non di comprensione. Non distingue tra vero e falso. Distingue tra “plausibile” e “implausibile”, tra “frequente” e “raro”. È una differenza sottile ma fondamentale, e spesso ci illude, perché il linguaggio umano è talmente potente e sfaccettato da sembrare un pensiero anche quando non lo è. Ma se capiamo questa base, iniziamo anche a capire perché può sbagliare: perché il suo unico scopo è costruire una frase credibile, non una verità.

Gli errori più comuni delle IA

Se partiamo quindi dal presupposto che l’intelligenza artificiale non “sa”, ma genera frasi plausibili in base a quanto ha visto durante l’addestramento, allora la domanda non è tanto perché sbaglia, ma perché non sbaglia più spesso. E in effetti, nonostante tutti i limiti strutturali, i modelli generativi di ultima generazione sono sorprendentemente precisi su moltissimi temi. Ma quando l’errore arriva, può essere talmente nascosto che diventa pericoloso.

Il primo e più evidente tipo di errore è l’errore fattuale. L’IA può dichiarare che il presidente della Repubblica italiana nel 2025 è Mario Draghi, o che Elon Musk ha fondato OpenAI nel 2018. Entrambe le affermazioni sono sbagliate: Draghi non è presidente, e OpenAI esiste da prima. Ma queste frasi “suonano” bene, perché sono composte da nomi noti, ruoli compatibili, date verosimili. Il modello non verifica, non confronta con fonti reali: semplicemente associa concetti secondo una logica statistica, e quindi può facilmente confondere contesti simili.

Un altro errore tipico è l’errore logico o semantico, quando la frase è grammaticalmente corretta ma non ha senso sul piano del contenuto. Ad esempio, può capitare che un’IA dica che “la corrente alternata è stata inventata da Thomas Edison” (in realtà fu Nikola Tesla a svilupparla) o che “la gravità spinge gli oggetti verso l’alto in assenza di atmosfera”. Questi errori nascono dal fatto che il modello ha appreso pezzi di informazione in modo sparso, senza una vera comprensione delle leggi fisiche o dei rapporti storici tra le figure coinvolte.

È come mischiare i titoli dei capitoli di un’enciclopedia: il risultato sembra autorevole, ma è privo di coerenza.

Poi c’è l’errore contestuale, più difficile da individuare perché non dipende da un’informazione sbagliata in sé, ma dall’inadeguatezza rispetto alla domanda. Se chiedi a un’IA “qual è il miglior telefono del 2025?” e lei risponde con un modello del 2023, magari perché non ha dati aggiornati, ti sta comunque dando una risposta sbagliata, pur usando informazioni corrette in assoluto.

C’è poi un’altra categoria di errore che molti utenti scoprono solo dopo un po’ di pratica: l’invenzione di riferimenti inesistenti. Ad esempio, il modello può citarti uno studio pubblicato nella “Rivista di neuroscienze, volume 42, numero 3, marzo 2021”... che non esiste. Né quel numero, né quell’articolo. È un riferimento plausibile, credibile, coerente, ma completamente inventato. Questo tipo di errore è noto come “allucinazione”, e tra qualche riga approfondiremo il motivo per cui accade.

Infine, ci sono errori linguistici più sfumati, che non riguardano i fatti ma lo stile e la forma: l’IA può sembrare eccessivamente assertiva su argomenti incerti, oppure usare un tono sbagliato in un determinato contesto (per esempio, una risposta troppo leggera su un tema delicato). Questo tipo di errore non è sempre grave, ma contribuisce a quella sensazione di “estraneità” che si percepisce quando ci accorgiamo che, dietro la forma perfetta, c’è qualcosa che non quadra.

Tutti questi errori hanno una radice comune: il fatto che il modello è costruito per generare risposte plausibili, non vere. E la plausibilità non è sinonimo di accuratezza. In un certo senso, è come avere un bravo imitatore che recita la parte di un esperto, ma che ogni tanto sbaglia perché si confonde su una data o su un nome. Solo che, nel caso dell’IA, noi ci fidiamo di più perché ci parla con voce neutra, senza incertezze, e perché, spesso, ha davvero ragione.

Allucinazioni

Quando si parla di allucinazioni nei modelli linguistici generativi, ci si riferisce a un fenomeno tecnico molto preciso: la generazione di contenuti errati, fuorvianti o totalmente inventati, che però appaiono perfettamente credibili. L’IA, in questi casi, produce qualcosa che non esiste affatto, ma lo fa con sicurezza e coerenza stilistica. È una sorta di bugia involontaria, ma estremamente raffinata.

Un esempio classico di allucinazione? Se chiedi a un’IA: “Dammi una lista di articolo accademici pubblicati tra il 2020 e il 2022 sul legame tra il riposo e la creatività”, lei potrebbe restituirti cinque titoli apparentemente perfetti. Autori con cognomi realistici, riviste scientifiche realmente esistenti, numeri di volume, tutto in apparenza corretto.

Ma se vai a cercare quegli articoli, scopri che non esistono da nessuna parte. L’IA li ha semplicemente... creati. Ha capito che il tono e la struttura di una bibliografia seguono una certa forma e ha riempito gli spazi con elementi plausibili, basandosi su come sono fatti decine di migliaia di riferimenti simili. È come chiedere a qualcuno di inventare una ricetta che sembra vera usando solo ingredienti comuni: il risultato è convincente, ma falso.

Le allucinazioni nascono perché l’IA non ha una conoscenza strutturata del mondo, né un modo per verificare in tempo reale la veridicità di ciò che dice. Non ha un “dizionario dei fatti” né un sistema interno di coerenza che le impedisca di mischiare verità e finzione. Ha solo il suo enorme modello statistico, costruito sull’analisi di testi esistenti. E quindi, se ha visto milioni di bibliografie, è in grado di imitarne la forma... anche quando non ha alcun dato reale su cui basarsi.

Questo succede anche in contesti più quotidiani. Può dirti che la legge italiana prevede una certa multa per chi parcheggia davanti a una scuola, citando un articolo del Codice della Strada che... non esiste. Oppure può spiegarti che il Wi-Fi 6 usa una determinata frequenza che in realtà appartiene al Wi-Fi 7.

Ogni volta che l’IA non è sicura o non ha un dato preciso nel suo training, tende a “riempire i buchi” con materiale plausibile. Questo è il cuore dell’allucinazione.

È importante capire che le allucinazioni non sono errori casuali: sono il risultato inevitabile del modo in cui il modello è costruito. Ogni parola generata è la più probabile tra tutte quelle possibili, ma in mancanza di informazioni certe, quella “più probabile” può essere talmente distante da essere inventata. E, peggio ancora, il modello non segnala mai l’incertezza. Non ti dice: “Attenzione, potrei sbagliarmi”, a meno che non sia stato programmato per farlo in certe condizioni. Quindi la forma della risposta è sempre sicura, anche quando il contenuto è sbagliato.

C’è poi un altro aspetto ancora più sottile: le allucinazioni possono apparire anche in risposte corrette a metà. L’IA può iniziare con dati veri, poi a un certo punto aggiungere un elemento inventato, e chi legge, fidandosi del tono autorevole, non si accorge della transizione tra vero e falso. Questo è pericoloso soprattutto in ambiti tecnici, legali, scientifici, dove una virgola fuori posto può cambiare il significato di un’intera affermazione.

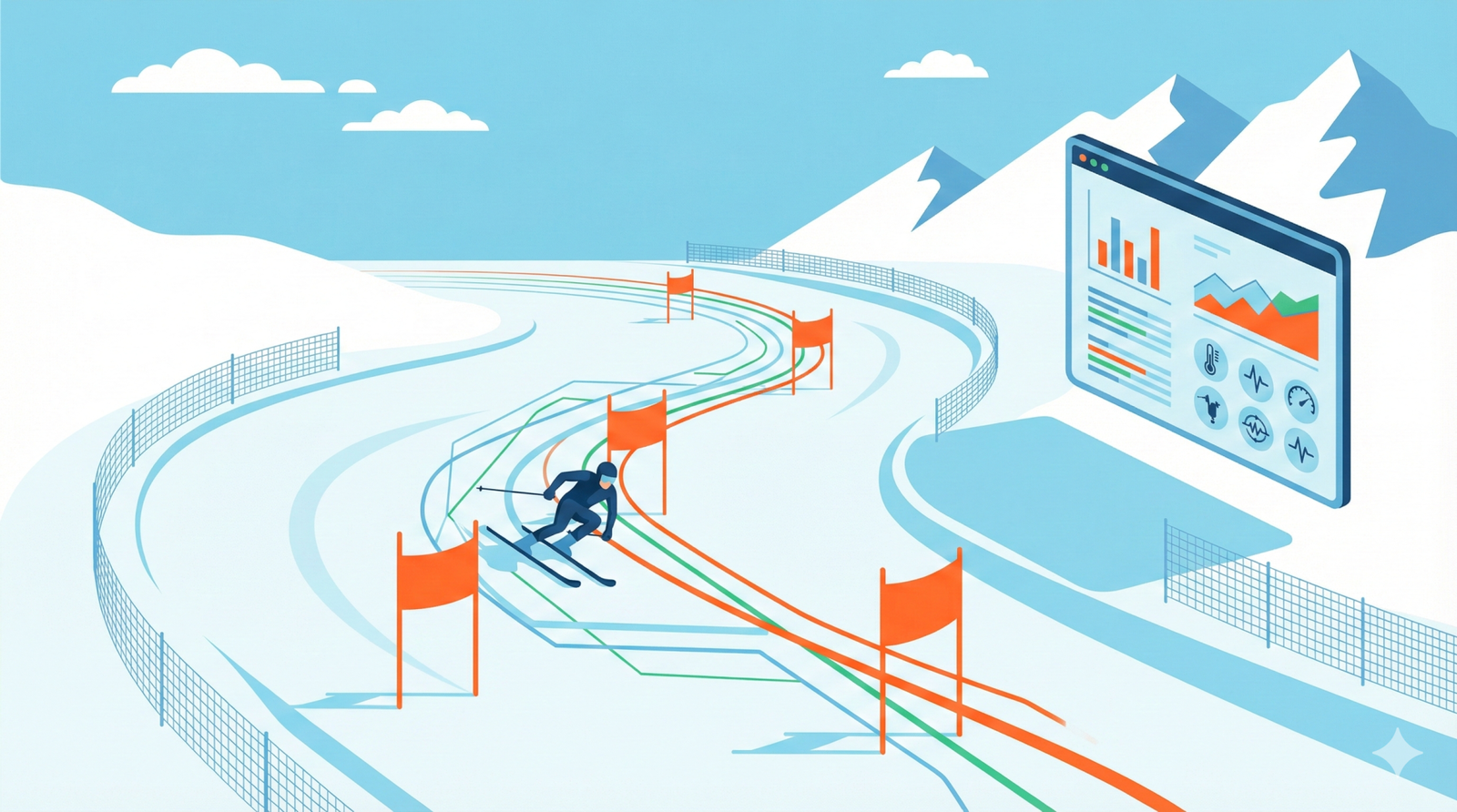

Alcuni modelli cercano di mitigare questo rischio con sistemi di RAG (sigla che sta per Retrieval Augmented Generation), cioè collegamenti a database aggiornati o motori di ricerca. Ma anche in questi casi, la generazione del testo finale può comunque “reinterpretare” i dati trovati in modo errato, o mischiarli male.

Le IA hanno pregiudizi?

Finora abbiamo parlato di errori come conseguenza di limiti tecnici: la mancanza di comprensione, l’assenza di verifica, la tendenza a generare testi plausibili ma non sempre veri. Ma c’è un altro tipo di errore che riguarda i bias, ovvero le distorsioni, i pregiudizi, le inclinazioni ideologiche o culturali che un’IA può incorporare.

E la parte più inquietante è che, nella maggior parte dei casi, non se ne rende conto. Perché, come abbiamo visto, l’IA non pensa. E quindi non ha nemmeno coscienza dei filtri che applica nel rispondere.

Ma cosa sono esattamente questi bias? Per capirlo, dobbiamo tornare all’origine: i dati su cui l’intelligenza artificiale viene addestrata. Quando si costruisce un modello come GPT, i ricercatori selezionano grandi quantità di testo, provenienti da libri, articoli, siti web, conversazioni online, forum, social media. È una mole gigantesca di contenuti umani, in cui si trovano sia espressioni di intelligenza e cultura, sia errori, insulti, stereotipi, fake news, ideologie politiche, religiose, razziste o sessiste. Nessuna conversazione umana è totalmente neutrale. Anche i contenuti apparentemente oggettivi sono prodotti in un certo tempo, in un certo luogo, da esseri umani con opinioni personali e credenze.

Ora, l’intelligenza artificiale non distingue tra un articolo scientifico verificato e un post su Reddit. Se entrambi sono presenti nel set di addestramento, li assorbe entrambi. È vero, ci sono dei filtri: i team di sviluppo cercano di rimuovere contenuti tossici, estremisti o palesemente falsi. Ma è impossibile rimuovere ogni forma di pregiudizio, perché molti sono sottili, impliciti, mimetizzati nel linguaggio stesso.

Facciamo qualche esempio. Se una IA ha visto per anni articoli e discussioni in cui i programmatori informatici vengono associati a uomini, quando le chiedi di descrivere un “developer”, con ogni probabilità lo immaginerà maschio. Se ha letto migliaia di post in cui si associa criminalità a determinati gruppi etnici o religiosi, anche se non lo dirà esplicitamente (perché bloccata da filtri di sicurezza), il suo modello interno potrebbe comunque restituire risposte ambigue o sbilanciate.

Oppure potresti notare che tende a favorire certe visioni politiche rispetto ad altre, perché le fonti da cui ha imparato erano squilibrate in quel senso. I bias possono anche assumere forme più sofisticate, come il conformismo culturale. Se la stragrande maggioranza dei testi, non so, sul clima riflette una visione precisa del cambiamento climatico, la IA ripeterà quella visione. Anche se qualcuno le chiede di “offrire un punto di vista opposto”, farà fatica a costruirlo, perché semplicemente non ha abbastanza dati equilibrati per farlo senza inventare o semplificare.

C’è anche il problema del cosiddetto bias di addestramento recente. I modelli più aggiornati, per essere più “allineati” con i valori delle aziende che li producono, vengono sottoposti a una fase di reinforcement learning con feedback umano (RLHF), in cui esseri umani valutano le risposte dell’IA e indirizzano il modello verso ciò che viene ritenuto più corretto o etico.

Ma qui entra in gioco un’altra questione: chi decide cosa è “etico”? Quale visione del mondo viene privilegiata? Anche la selezione dei revisori e le linee guida che seguono possono introdurre un bias, trasformando l’IA in uno strumento più conforme a certe ideologie e meno neutrale rispetto ad altre.

Tutto questo ci porta al fatto che l’intelligenza artificiale non è oggettiva, anche se si presenta come tale. Parla con tono neutro, usa un linguaggio misurato, cita dati e fonti. Ma il contenuto di ciò che dice è sempre figlio dei testi che ha letto, e di come è stata istruita a interpretarli. Se quei testi contenevano errori, discriminazioni, distorsioni storiche, l’IA le può riportare.

Ecco perché i bias delle IA sono oggi uno dei temi più delicati. Non basta che un’IA non sia tossica o pericolosa. Deve anche essere il più possibile trasparente e bilanciata. Ma non ci arriveremo facilmente, perché ciò richiederebbe un cambiamento radicale nella raccolta dei dati, nei criteri di selezione e nei modelli di governance.

I Limiti delle IA che accedono alle informazioni

Uno dei limiti fondamentali dei modelli generativi come ChatGPT è che non possiedono una memoria dinamica, almeno non nel modo in cui la intendiamo noi. Al momento della loro creazione, vengono “addestrati” su enormi quantità di dati testuali. Questo processo prende mesi, costa milioni di dollari, e produce un modello in grado di “parlare” con naturalezza. Ma una volta concluso l’addestramento, il modello non impara più nulla da solo.

Questo significa che, se gli chiedi chi ha vinto le elezioni del 2024, oppure qual è il miglior processore del 2025, ti risponderà con dati obsoleti, magari aggiustandoli in modo plausibile, ma comunque basandosi su ipotesi, non su fatti aggiornati. Le versioni più avanzate, quelle attuali, possono accedere a internet o database esterni aggiornati, possono cercare informazioni in tempo reale, ma anche in quei casi non è garantito che capiscano correttamente i dati che trovano, perché il testo finale è sempre generato sulla base di probabilità linguistiche, non sulla certezza delle fonti.

A questo limite si aggiunge un altro vincolo tecnico molto importante: il contesto limitato. Ogni IA ha una “finestra” di attenzione, cioè un certo numero di parole o token che può tenere “a mente” durante una conversazione. Se questa finestra si riempie, il modello inizia a dimenticare parti della conversazione. Nelle versioni più moderne, questa finestra è molto ampia (può arrivare a decine di migliaia di parole), ma resta comunque limitata. Questo fa sì che, in conversazioni molto lunghe, l’IA possa “perdere il filo”, dimenticare dettagli importanti o contraddirsi rispetto a quanto detto all’inizio.

C’è poi la questione della memoria persistente, ovvero la capacità di “ricordare” l’utente tra una sessione e l’altra. Alcuni sistemi lo offrono, ma in modo controllato, e spesso senza una vera comprensione dei legami logici tra le informazioni. La “memoria”, quindi, è più simile a un database passivo che a un ricordo attivo. L’IA non sa collegare eventi nel tempo, non fa ragionamenti cronologici, non distingue bene ciò che è stato detto prima o dopo se non viene ripetuto esplicitamente.

Se non bastasse questo, un altro punto critico riguarda la fusione di fonti diverse, che l’IA fa con estrema disinvoltura. Immagina di chiederle: “Parlami delle critiche alle leggi riguardanti il green in europa”. Il modello potrebbe mischiare argomentazioni tratte da articoli del 2020, con opinioni politiche del 2022, e con previsioni economiche del 2023. Il risultato sarà magari stilisticamente coerente, ma privo di una chiara linea temporale. L’IA non ti dirà “questa informazione è di tre anni fa”, ma la presenterà come se fosse valida ancora oggi. Questo porta a un problema di fondo: l’intelligenza artificiale non ha la nozione di “obsolescenza” delle informazioni. Se qualcosa era vero nel 2018 ma oggi è stato smentito, per lei vale comunque, a meno che non abbia visto abbastanza esempi aggiornati in fase di addestramento che annullano quell’informazione.

E infine, c’è un limite ancora più sottovalutato: la mancanza di consapevolezza delle fonti. Quando l’IA ti dice qualcosa, può anche citarti la fonte dove ha preso quell’informazione, ma non ha una mappa interna delle fonti, non sa distinguere un trattato scientifico da un post su un blog personale. Questo rende difficile, per l’utente, valutare l’affidabilità delle risposte.

Questi limiti strutturali, ovvero la memoria corta, l’addestramento statico, l’assenza di temporalità e la gestione opaca delle fonti, non solo favoriscono gli errori, ma riducono la capacità dell’IA di essere un vero strumento di conoscenza affidabile.

Il problema siamo anche noi

Fino a questo punto ho parlato dei limiti dell’intelligenza artificiale, ma c’è un aspetto spesso trascurato, il modo in cui noi interagiamo con l’IA.

Perché l’intelligenza artificiale è estremamente sensibile a come le vengono poste le domande. E in molti casi, è proprio il modo in cui l’utente formula la richiesta a generare risposte sbagliate, perché i prompt sono troppo vaghi.

Se chiedi a un’IA “Quali sono i problemi del sistema scolastico?”, senza specificare in quale paese, in quale livello di istruzione, in quale periodo storico, il modello cercherà di interpretare la domanda nel modo più generico possibile. Magari ti parlerà della scuola negli Stati Uniti, o in Europa, o fonderà insieme dati di paesi diversi. Il risultato sarà una risposta che può sembrare convincente, ma che non ha alcuna aderenza al contesto reale che avevi in mente.

Anche le domande ambigue generano problemi simili. Se scrivi: “Parlami di Musk e della sua posizione sull’intelligenza artificiale”, non è chiaro se ti riferisci a Elon Musk, a uno dei suoi interventi specifici, a un momento storico preciso, a un suo progetto come xAI oppure a critiche fatte da altri verso le sue idee. Il modello, non sapendo quale interpretazione privilegiare, potrebbe restituirti un collage di affermazioni, opinioni e notizie, alcune vere, altre superate, e magari qualcuna inventata. Non per “volontà di confondere”, ma perché non ha abbastanza informazioni per capire quale strada percorrere.

C’è poi il caso delle domande fuorvianti, in cui l’errore nasce proprio dal presupposto sbagliato della domanda. Se scrivi: “Perché l’Italia ha lasciato l’Unione Europea?”, il modello potrebbe provare a rispondere comunque, supponendo che l’Italia lo abbia davvero fatto, e costruire una risposta del tutto inventata, ma plausibile.

Un altro scenario molto interessante è quello delle domande troppo complesse o sovraccariche di contenuti. Se scrivi un prompt lungo due paragrafi, con tre domande dentro e molti dettagli poco chiari, il modello può confondersi: a volte risponde solo a una parte, a volte prova a rispondere a tutto ma in modo impreciso, e a volte travisa completamente il senso della richiesta.

Infine, c’è anche un problema educativo. Molte persone non sanno come parlare a un’IA. Pensano che basti scrivere due parole per ottenere una risposta perfetta, oppure la trattano come un motore di ricerca. Ma un’IA generativa non funziona come Google: non cerca informazioni tra le pagine del web, ma le genera a partire da ciò che ha imparato. E quindi la qualità della risposta dipende enormemente dalla qualità della domanda. In questo senso, usare bene l’intelligenza artificiale è un’abilità che va appresa, esattamente come si impara a scrivere una mail professionale o a cercare bene su un motore di ricerca.

Come riconoscere gli errori?

Il primo consiglio è quello più semplice: non dare mai per scontata la veridicità di una risposta, soprattutto se riguarda dati precisi, numeri, leggi, fatti storici o nomi. Se un’IA ti dice che un certo dispositivo è stato rilasciato nel 2022, oppure che una legge è stata abrogata in un certo anno, oppure che un determinato studio scientifico ha dimostrato una certa cosa, verifica. Prenditi il tempo di controllare su fonti affidabili. Perché l’IA può aver semplicemente “allucinato” quel dato, rendendolo perfettamente credibile, ma privo di fondamento.

Secondo punto chiave: scrivi prompt chiari, specifici e ben contestualizzati. Evita domande generiche come “Parlami del cambiamento climatico”, a meno che tu non voglia una panoramica molto generale. Specifica cosa vuoi sapere, da quale punto di vista, in quale contesto.

Terzo suggerimento: chiedi all’IA di dirti da dove proviene l’informazione. Nei modelli dotati di browsing, puoi chiedere direttamente i link alle fonti, confrontando il testo generato con ciò che è realmente scritto nelle pagine citate.

Un altro modo efficace per ridurre il rischio di errore è chiedere all’IA di valutare la propria risposta. Puoi scrivere: “Hai certezza di quello che hai appena detto?” oppure “Potresti indicarmi quali parti della tua risposta sono più incerte o suscettibili di errore?”. In molti casi, questo semplice trucco spinge il modello a riflettere (per quanto possa farlo) sulle basi della sua generazione, e spesso ammette che ci sono margini di dubbio. È un buon modo per uscire dal loop dell’assertività forzata.

Vale anche la pena porre la stessa domanda in modi diversi, o simulare punti di vista opposti, per vedere come l’IA reagisce. Se una prima risposta ti sembra sbilanciata, chiedile: “E ora, prova a spiegarmi la posizione contraria”. Questo serve a testare la neutralità del modello, a evidenziare eventuali bias e a ottenere una visione più completa. Non fidarti mai di una sola risposta, se l’argomento è delicato.

Infine, non usare l’IA come fonte diretta nei contenuti pubblici o accademici, almeno non senza un serio lavoro di verifica. Non citare un dato “perché lo ha detto l’IA”, ma usa l’IA come punto di partenza per una ricerca più ampia. Lascia che ti aiuti a chiarire, riassumere, generare idee, trovare spunti. Ma il controllo dei fatti spetta a te.

In conclusione, l’IA non mente perché vuole ingannarti. Mente perché non sa cosa sia la verità. È un motore di linguaggio, non un cervello. Ma se si impara a usarla con consapevolezza, diventa uno strumento molto potente.