Jensen Huang, amministratore delegato di NVIDIA, si è recato presso le strutture di SpaceX per consegnare a Elon Musk un'unità del DGX Spark, il mini-supercomputer che promette di democratizzare l'intelligenza artificiale portando capacità di calcolo un tempo impensabili in un formato compatto. DGX Spark è ufficialmente disponibile da oggi e può acquistarlo chiunque, a patto che possa spendere 3499 euro.

Non è la prima volta che Huang e Musk si ritrovano per un momento del genere. Il CEO di NVIDIA ha voluto evocare un ricordo che risale agli albori di OpenAI, quando consegnò personalmente uno dei primi esemplari del DGX-1 proprio a Musk, allora ancora coinvolto nell'organizzazione che avrebbe poi dato vita a ChatGPT.

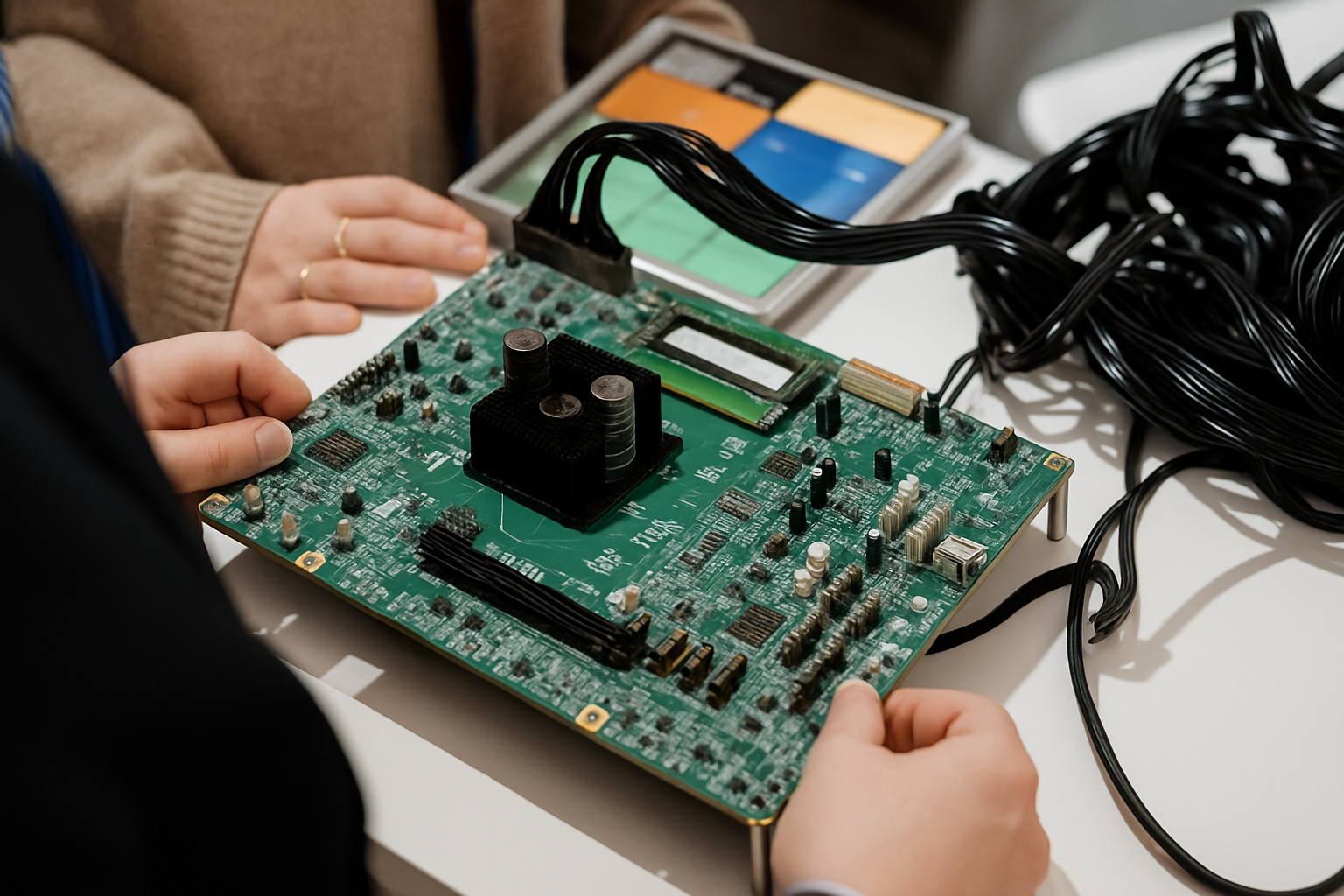

Il DGX Spark rappresenta l'evoluzione di quella missione originaria: rendere l'intelligenza artificiale accessibile non solo alle grandi corporazioni, ma anche a sviluppatori individuali e piccole realtà. Presentato al CES 2025, questo dispositivo racchiude potenzialità di calcolo straordinarie in dimensioni ridotte. Al suo interno batte il cuore tecnologico del GB10 Grace Blackwell Superchip, frutto della collaborazione tra NVIDIA e MediaTek, capace di erogare fino a un petaflop di prestazioni AI con precisione FP4.

La configurazione tecnica del sistema è particolarmente impressionante per chi lavora nel campo dell'apprendimento automatico. I 128 GB di memoria unificata CPU-GPU permettono agli sviluppatori di prototipare, ottimizzare ed eseguire inferenze direttamente in locale, eliminando la necessità di passare continuamente tra macchine diverse o servizi cloud. La tecnologia NVIDIA ConnectX garantisce il networking per il clustering, mentre l'NVLink-C2C offre una larghezza di banda cinque volte superiore rispetto al PCIe standard. Il comparto storage si affida alla tecnologia NVMe per garantire velocità di trasferimento dati elevate, mentre l'uscita HDMI permette la connessione a monitor esterni per la visualizzazione.

La filosofia sottesa al progetto riflette la visione di lungo periodo di NVIDIA nel settore dell'intelligenza artificiale. Mentre i giganteschi data center continuano a dominare l'addestramento dei modelli linguistici più avanzati, esiste una crescente domanda di soluzioni che permettano a sviluppatori e ricercatori di lavorare localmente su progetti di dimensioni intermedie, senza dipendere dalla connettività internet o preoccuparsi della privacy dei dati sensibili inviati al cloud.