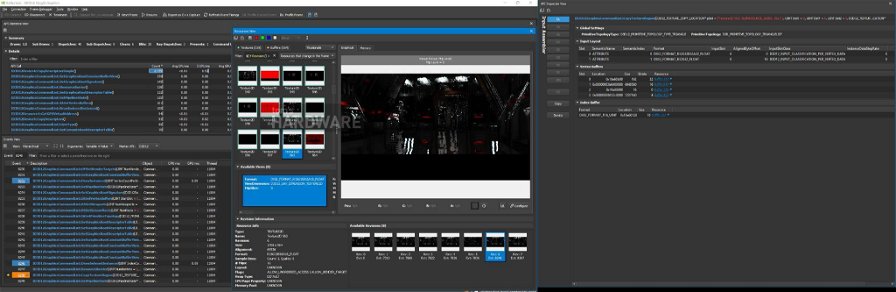

Volevamo approfondire la tecnologia DLSS di Nvidia, andando oltre quanto divulgato da Nvidia finora. E anche se abbiamo fatto alcuni progressi, ammettiamo di non avere risultati conclusivi. Un'osservazione possiamo farla: DLSS parte renderizzando a una risoluzione inferiore e poi fa un uscaling del 150% per raggiungere l'uscita obiettivo. Per quanto concerne la qualità, DLSS a 4K sembra decisamente migliore di DLSS a 2560x1440.

I passaggi tra il rendering a risoluzione inferiore e l'upscaling alla risoluzione target sono quelli in cui accade la "magia", ed è su questo passaggio che abbiamo poche informazioni oltre la descrizione originale di Nvidia. Ci sono diverse tecniche per ingrandire in modo pulito un'immagine grazie ai progressi nel machine learning. Questo campo è particolarmente avanzato, dato che è stata una delle prime applicazioni dell'intelligenza artificiale.

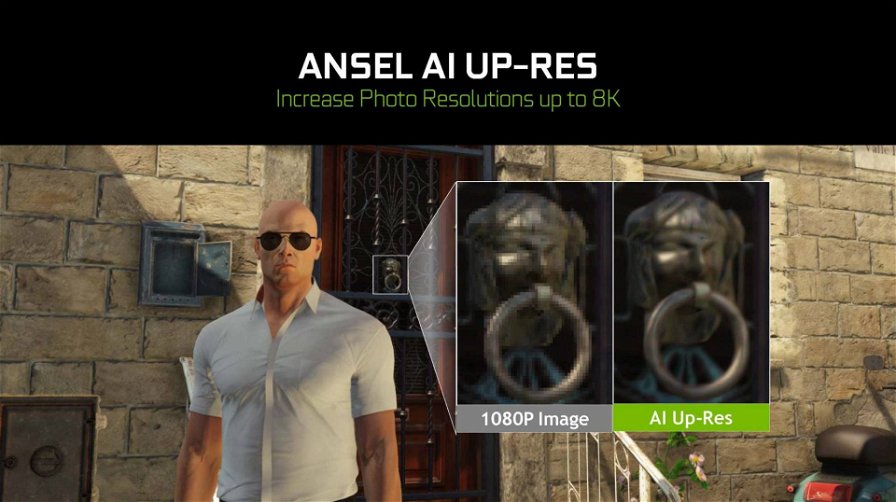

Inoltre, non possiamo fare a meno di vedere somiglianze in ciò che DLSS fa per i giochi e la tecnologia Ansel AI Up-Res di Nvidia, che consente ai giocatori di catturare immagini a 1080p e generare enormi foto 8K tramite inferenza. Sospettiamo che la stessa inferenza funzioni in tempo reale prima che avvenga l'upscaling di ogni fame nella pipeline DLSS. Si noti inoltre l'applicazione di un filtro anti-aliasing (TAA, DLAA?) appena prima del passaggio di upscaling.

Alcuni di questi passaggi sembrano familiari dalla descrizione originale di DLSS. L'azienda ha certamente omesso dettagli tecnici interessanti, come il rendering esplicito a una risoluzione inferiore, l'applicazione dell'anti-aliasing e l'upscaling. Tuttavia, i grandi miglioramenti in termini prestazionali hanno sicuramente molto più senso con queste informazioni.

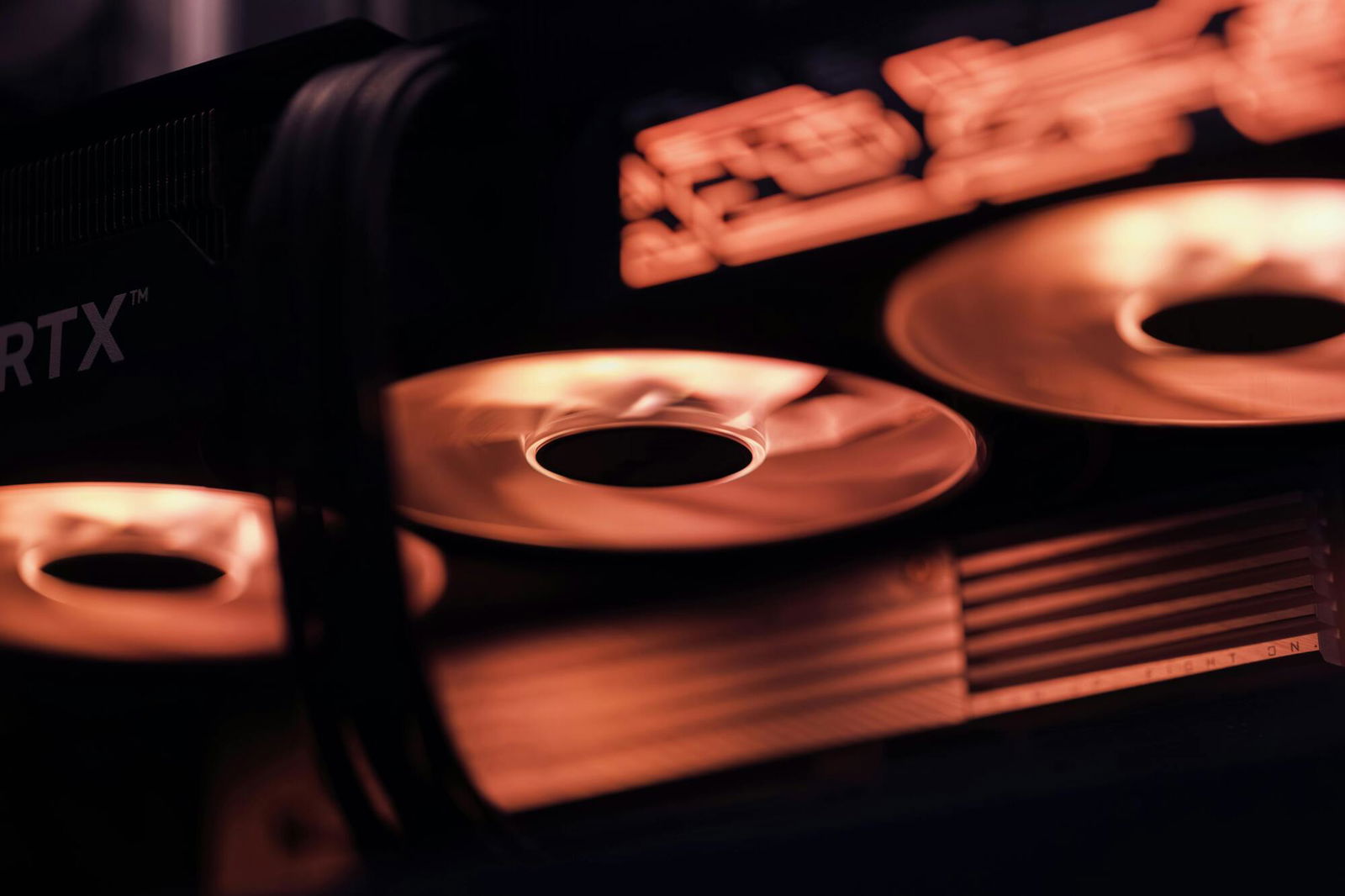

DLSS: una delle caratteristiche di Turing più promettenti

Funzionamento a parte, DLSS rimane una delle capacità più interessanti dell'architettura Turing, per diverse ragioni. Anzitutto la tecnologia offre costantemente una qualità d'immagine eccellente. Se osservate una qualsiasi delle demo DLSS in tempo reale, è difficile distinguere tra 4K nativo con TAA e le stesse scene migliorate da DLSS.

Secondariamente, ci è stato detto che DLSS dovrebbe migliorare nel corso del tempo. Secondo Nvidia, il modello per il DLSS è allenato su un insieme di dati che alla fine dovrebbe raggiungere un punto in cui la qualità dei risultati si appiana. Perciò, in certo senso, il modello DLSS matura, come una persona. Il cluster di supercomputer dell'azienda è costantemente allenato con nuovi dati provenienti da nuovi giochi, quindi potrebbero essere introdotti miglioramenti col passare del tempo.

Infine, questa è una tecnologia che potrebbe essere disponibile anche sulle GPU Turing "entry level", al contrario del ray tracing che richiede un livello minimo di prestazioni per dimostrarsi utile. Certo, sempre che Nvidia inserisca i Tensor core in tali GPU. Ci piacerebbe vedere una scheda video di fascia bassa riprodurre giochi tripla A in Full HD basandosi su un rendering a 720p.