Un recente studio pubblicato da JAMA Internal Medicine suggerisce che l’intelligenza artificiale non è solo estremamente competente in fatto di medicina, ma è anche meglio dei medici umani nel trattare i pazienti.

Abbiamo già sentito diverse volte di come ChatGPT e simili siano un supporto eccezionale in ambito medico: il segreto sta nell’accesso e nell’analisi dei dati, che permette all’algoritmo di vedere e comprendere più in là di quanto possa fare un essere umano, anche uno bravo.

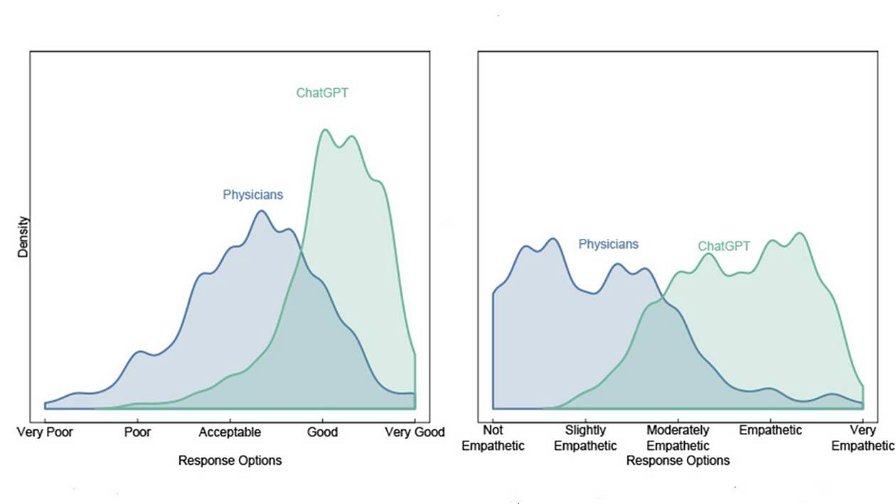

Fin qui, niente di nuovo. Ciò che invece risulta sorprendente, nella ricerca, è che i pazienti, nel 79% dei casi, hanno trovato le risposte di ChatGPT più educate, più umane, più empatiche.

In altre parole, l’algoritmo è più bravo e anche più simpatico. Un aspetto affatto trascurabile, perché un medico che sa risultare amichevole è un medico migliore. Per esempio, vostro nonno potrebbe prendere le pastiglie giuste all’ora giusta, se il messaggio arriva da una persona di cui si fida, che lo fa sentire bene emotivamente. Se il paziente esce offeso o arrabbiato dalla visita, invece, è un mezzo fallimento.

Insomma, quelli di noi che hanno avuto a che fare con medici un po’ antipatici (io personalmente ho una lista abbastanza lunga), potrebbero scoprire un giorno che si possono ricevere cure di qualità e anche un minimo di rispetto. Basta farlo fare a un robot.

I dettagli della ricerca

Per ottenere un campione ampio e diversificato di domande sull'assistenza sanitaria e di risposte dei medici che non contenessero informazioni personali identificabili, il team ha usato AskDocs di Reddit. r/AskDocs è un subreddit con circa 452.000 membri che postano domande mediche e professionisti sanitari verificati inviano risposte.

Il team ha preso a campione 195 scambi da AskDocs in cui un medico verificato rispondeva a una domanda pubblica. Il team ha fornito la domanda originale a ChatGPT e gli ha chiesto di scrivere una risposta.

Successivamente, alcuni professionisti sanitari hanno valutato ogni domanda e le relative risposte, in cieco rispetto al fatto che la risposta provenisse da un medico o da ChatGPT. Hanno confrontato le risposte in base alla qualità delle informazioni e all'empatia, indicando quale preferivano. Un’azione che ha tutte le carte in regole per essere descritta come Test di Turing.

Il gruppo di valutatori professionali ha preferito le risposte di ChatGPT a quelle del medico nel 79% dei casi.

"I messaggi di ChatGPT rispondevano con informazioni sfumate e accurate che spesso affrontavano più aspetti delle domande dei pazienti rispetto alle risposte dei medici", ha dichiarato Jessica Kelley, M.S.N, infermiera professionista presso l'azienda Human Longevity di San Diego e coautrice dello studio. Inoltre, le risposte della ChatGPT sono state valutate di qualità significativamente superiore rispetto a quelle dei medici.

Chiaramente, ChatGPT resta un mero strumento e non si può pensare (non ancora almeno) di affidarsi esclusivamente ad esso. Ancora una volta, tuttavia, si rivela uno strumento che tutti i medici del mondo potrebbero usare per migliorare il loro lavoro in ogni aspetto. Ciò è particolarmente vero adesso, con le relazioni medico-paziente che sempre più spesso avvengono tramite testo scritto, con un qualche strumento di messaggistica (email, SMS, Whatsapp … ).

Curiosamente, il robot potrebbe aiutare il medico a risultare più umano.

Immagine di copertina: altitudevisual

Fonte: UC San Diego