Il mercato globale dei data center sta vivendo una fase di espansione senza precedenti, spinta dall'ondata di investimenti nell'intelligenza artificiale che sta ridisegnando l'intera infrastruttura tecnologica mondiale. Secondo le ultime rilevazioni di Dell'Oro Group, la spesa in conto capitale per i data center ha registrato un incremento del 59% su base annua, un dato che testimonia come l'AI stia transitando dalla fase sperimentale di addestramento dei modelli a una diffusione capillare nelle applicazioni di inferenza e produzione. Si tratta dell'ottavo trimestre consecutivo con crescita a doppia cifra, un trend che evidenzia la maturazione di un ciclo di investimenti strutturale e non più congiunturale.

L'analisi di Dell'Oro Group sottolinea come questa accelerazione non sia più confinata ai pochi giganti tecnologici che hanno dominato la prima fase di sviluppo dei grandi modelli linguistici. L'espansione si sta infatti propagando verso una platea più ampia di operatori, che stanno investendo massicciamente in infrastrutture per supportare workload di AI distribuita, edge computing e applicazioni enterprise. La domanda di potenza di calcolo per GPU ad alte prestazioni, reti ad alta larghezza di banda e sistemi di raffreddamento avanzati sta ridefinendo i requisiti architetturali dei data center moderni.

Particolarmente significativo è il passaggio dalla fase di training a quella di inference, che richiede configurazioni hardware differenti e spesso più distribuite geograficamente. Mentre l'addestramento dei modelli di machine learning concentrava gli investimenti in pochi mega-impianti dotati di migliaia di acceleratori AI collegati tramite interconnessioni ad altissima velocità, l'inferenza richiede deployment più capillari, con latenze ridotte e maggiore efficienza energetica. Questo sta alimentando una domanda diversificata che coinvolge tanto i processori specializzati quanto architetture ibride CPU-GPU ottimizzate per carichi di lavoro specifici.

Il fenomeno ha ripercussioni dirette anche sul mercato europeo, dove i fornitori di servizi cloud e gli operatori di colocation stanno annunciando espansioni significative per rispondere alla crescente domanda di capacità computazionale. Le normative europee sull'efficienza energetica e sulla sovranità digitale stanno inoltre spingendo verso soluzioni locali, con investimenti mirati in regioni strategiche. La necessità di conformarsi al Digital Markets Act e al GDPR rende essenziale la presenza di infrastrutture sul territorio comunitario, accelerando progetti che solo pochi anni fa erano considerati economicamente marginali rispetto ai grandi hub statunitensi.

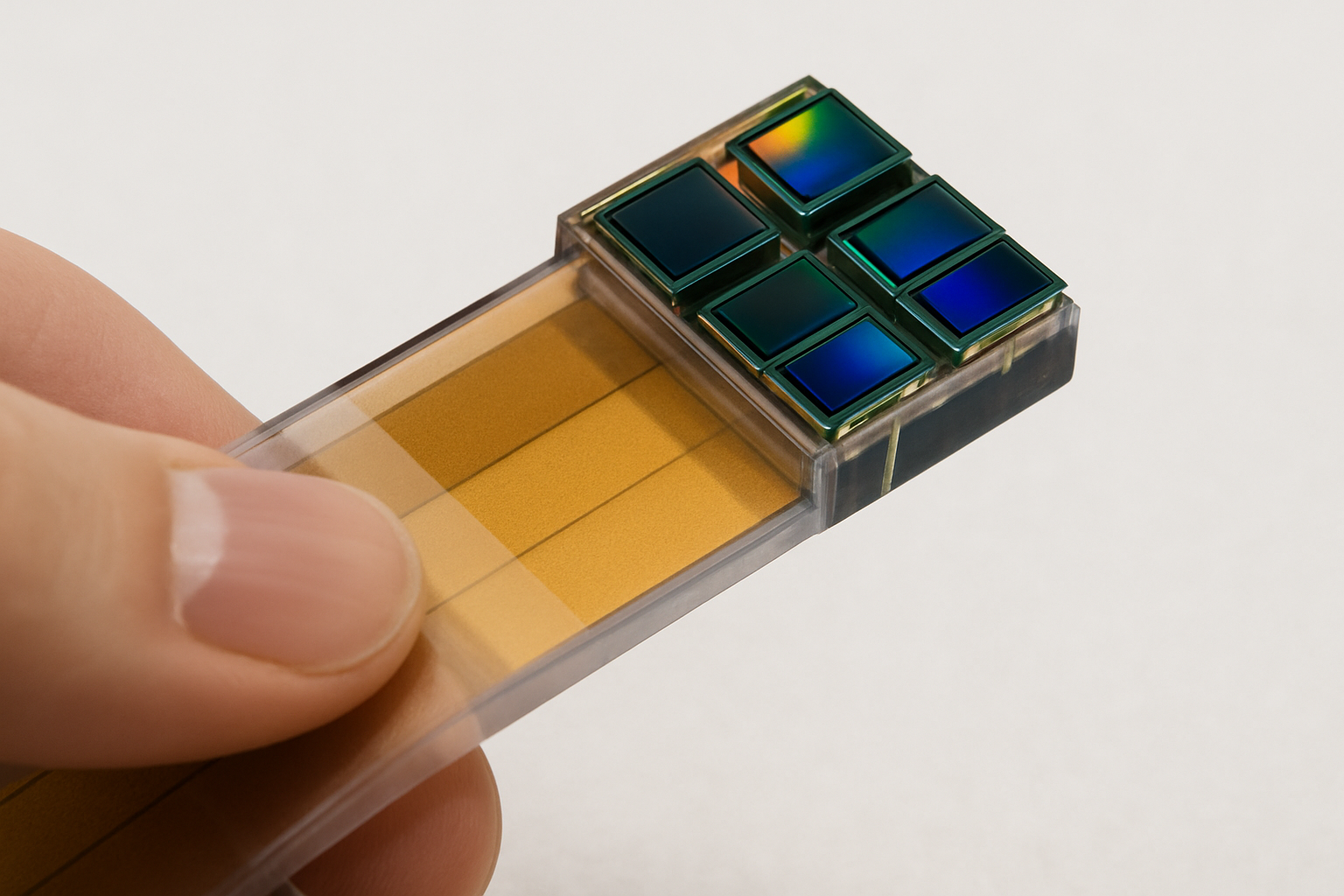

Sul fronte tecnologico, la corsa agli investimenti sta favorendo l'adozione accelerata di innovazioni come il raffreddamento a liquido, essenziale per gestire i TDP sempre più elevati delle GPU di ultima generazione, e le reti ottiche ad alta velocità per interconnettere cluster distribuiti. Anche i sistemi di alimentazione stanno evolvendo, con crescente attenzione verso fonti rinnovabili e soluzioni di backup avanzate per garantire uptime critici. La sfida energetica rappresenta probabilmente il collo di bottiglia più significativo: un singolo rack ad alta densità per AI può consumare quanto decine di rack tradizionali, ponendo problemi infrastrutturali non banali sia in termini di fornitura che di dissipazione termica.

Guardando al futuro prossimo, gli analisti prevedono che questo ciclo di investimenti continuerà almeno per i prossimi trimestri, sostenuto dall'adozione enterprise dell'AI generativa e dall'espansione dei servizi cloud specializzati. La competizione tra i principali fornitori di semiconduttori per data center si intensifica, con NVIDIA, AMD e Intel che stanno tutti annunciando roadmap aggressive di acceleratori e processori ottimizzati per workload AI. La vera incognita rimane la sostenibilità a lungo termine di questi ritmi di crescita, soprattutto considerando i vincoli energetici e ambientali che iniziano a emergere come fattore limitante in diverse giurisdizioni.