Il paradosso dell'intelligenza artificiale moderna si manifesta chiaramente quando confrontiamo due strumenti presenti in ogni smartphone: la calcolatrice, che non commette mai errori nei suoi calcoli ma ha funzionalità limitatissime, e l'assistente vocale, capace di aiutarci con poesie, ricette e mille altri compiti, ma che spesso fraintende le nostre richieste in modo clamoroso. Questa dicotomia non è casuale, ma rappresenta una legge fondamentale dell'intelligenza artificiale che il filosofo Luciano Floridi ha recentemente formalizzato in una congettura matematica rivoluzionaria. La domanda che molti si pongono è legittima: perché non possiamo avere un'IA infallibile come una calcolatrice ma versatile come un assistente avanzato?

La risposta arriva dalla "Conjecture on a Fundamental Trade-off between Certainty and Scope in Symbolic and Generative AI", una ricerca che delinea i confini invalicabili tra due mondi dell'intelligenza artificiale. Da una parte troviamo l'IA simbolica, rappresentata perfettamente dalla calcolatrice digitale: quando questi strumenti furono introdotti, qualcuno li definì "intelligenti" per la loro bravura nei calcoli, ma altri obiettavano giustamente che non potevano interpretare poesie o riconoscere gatti nelle fotografie. Questo tipo di intelligenza artificiale opera in un mondo piccolo, ordinato e prevedibile, dove può raggiungere la perfezione assoluta ma con uno scopo estremamente limitato.

All'opposto si colloca l'intelligenza artificiale generativa, quella che domina l'attualità tecnologica attraverso sistemi come GPT, Gemini e Claude. Questi strumenti possono riconoscere immagini, organizzare viaggi, scrivere articoli e creare piani di marketing, dimostrando una versatilità impressionante. Tuttavia, la loro conoscenza funziona su base probabilistica: non "sanno" realmente che Parigi è la capitale della Francia, ma assemblano le parole secondo schemi statistici per fornire la risposta corretta. Questa ampiezza di scopo, magica in superficie, è precisamente la ragione per cui commettono errori spettacolari.

La matematica dell'impossibile

"La formula elaborata da Floridi, CDM × SDM ≤ K, racchiude in termini matematici questo compromesso inevitabile" spiega l'esperto di IA, Fabrizio Degni. "Il CDM rappresenta la certezza epistemica, un punteggio da 0 a 1 dove 1 indica l'infallibilità assoluta, mentre SDM misura lo scopo, ovvero l'ampiezza del dominio operativo dell'IA. La costante K costituisce un limite invalicabile nell'universo delle intelligenze artificiali, un tetto che nessun sistema può superare".

L'implicazione è brutale ma onesta: il prodotto tra certezza e scopo non può oltrepassare questo limite. Se desideriamo costruire un'IA con certezza assoluta, la matematica ci costringe ad accettare uno scopo ristrettissimo. Viceversa, per ottenere uno scopo immenso, la certezza si riduce drasticamente, rendendo il sistema inevitabilmente fallibile.

Esempi concreti illustrano questa legge agli estremi dello spettro. "Coq, un assistente per prove matematiche formali, raggiunge una certezza assoluta pari a 1, ma il suo scopo è minimo: comprende solo linguaggio logico specifico e non può fare altro" continua Degni. "All'opposto, AlphaCode di DeepMind scrive codice per risolvere problemi di programmazione con uno scopo vastissimo, ma senza alcuna garanzia che il codice prodotto sia sicuro, corretto, funzionante o ottimizzato".

Soluzioni ingegneristiche per il mondo reale

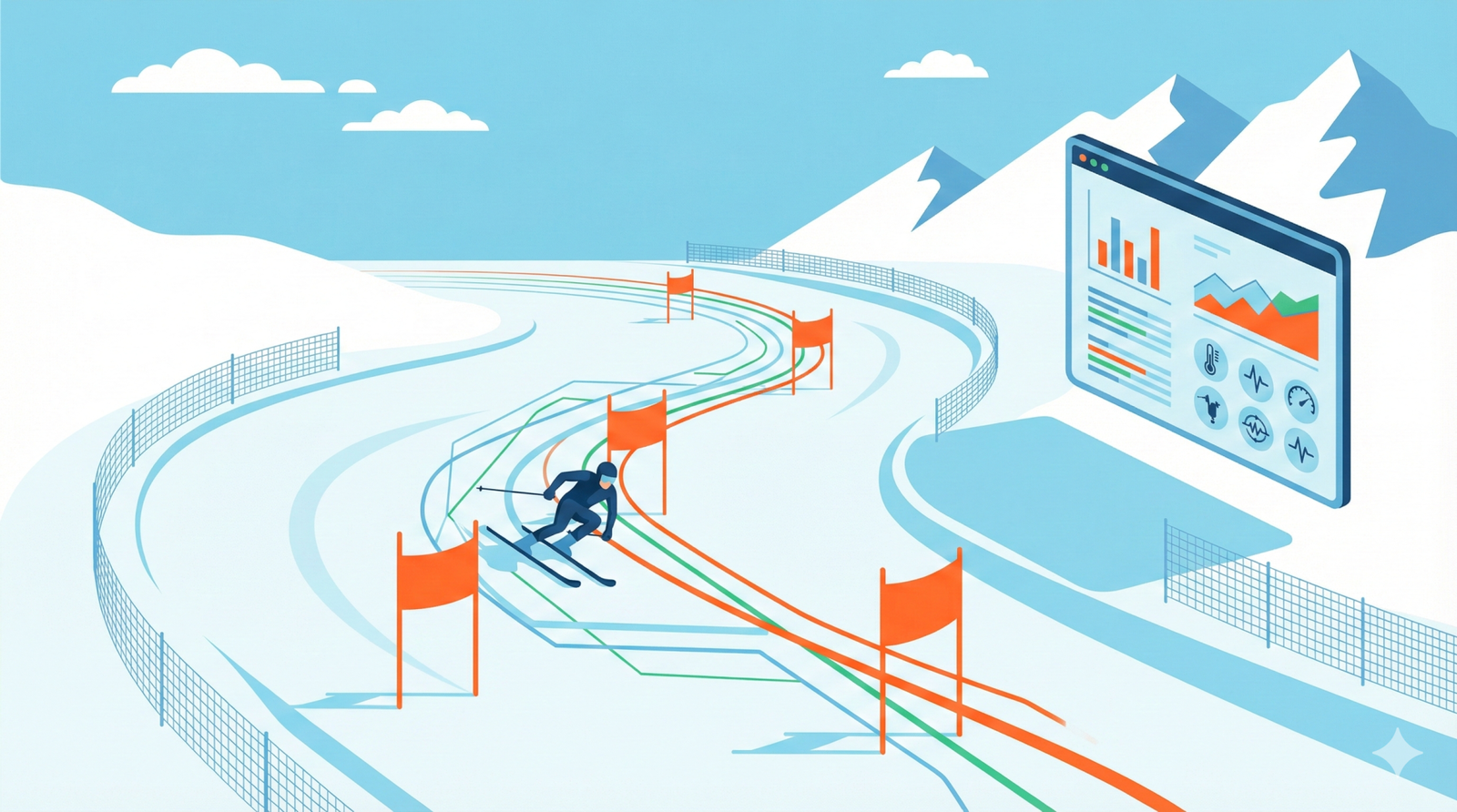

La consapevolezza di questo trade-off fondamentale non paralizza l'innovazione, ma indirizza verso architetture ibride più intelligenti. Nel caso della guida autonoma, per esempio, la soluzione prevede sistemi a due livelli: un modello ad alta certezza e basso scopo gestisce le funzioni critiche come la frenata d'emergenza, seguendo regole ferree e verticali dove il sensore rileva un ostacolo e l'autopilota frena immediatamente. Un'intelligenza artificiale superiore, con conoscenza orizzontale anziché verticale, coordina questi agenti specializzati senza dover essere esperta in ogni singolo dominio.

Questa realtà ha conseguenze profonde anche sulla regolamentazione: leggi come l'AI Act europeo non possono realisticamente richiedere un rischio zero o sicurezza al 100%, poiché equivalrebbe a violare una legge fisica. L'approccio deve spostarsi dall'illusione di infallibilità impossibile verso una gestione intelligente del rischio, con politiche di prevenzione che tengano conto dell'incertezza intrinseca di questi sistemi.

La formazione degli utenti diventa cruciale per navigare questo panorama di imperfezione strutturale. Comprendere che ChatGPT, Gemini, Claude e Perplexity sono bravi in molte cose ma inevitabilmente fallibili proprio per la loro versatilità, ci permette di utilizzarli più efficacemente. Un approccio pratico consiste nel limitare deliberatamente lo scopo attraverso prompt più specifici, sfruttando la matematica di Floridi a nostro vantaggio: restringendo il campo d'azione dell'IA, aumentiamo la sua affidabilità in quel dominio specifico.

La congettura di Floridi non rappresenta una limitazione scoraggiante, ma una mappa per orientarsi nel futuro dell'intelligenza artificiale. Riconoscere che non esiste un genio tuttofare e infallibile ci libera dall'attesa di perfezioni impossibili e ci guida verso un utilizzo più consapevole e produttivo di questi strumenti straordinari, anche se imperfetti per natura.