Intel sta entrando a grandi passi nel mondo dell'Intelligenza Artificiale. La compagnia ha rivelato due CPU incentrate sul computng IA, una bella mossa per dare del filo da torcere a Google e Amazon, nel campo dell'apprendimento automatico.

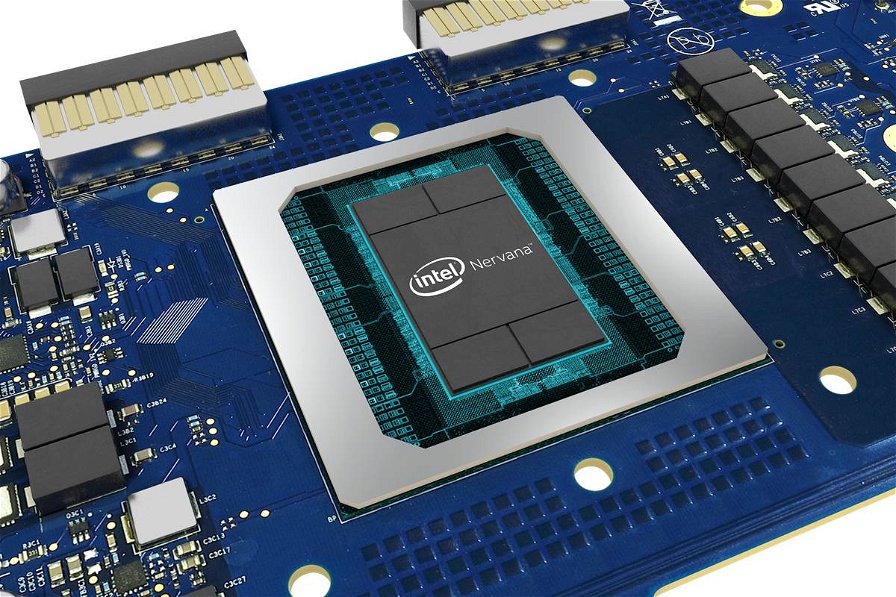

I chip saranno i primi a formare la gamma Nervana Neural Network Processor (NNP) di Intel, uno dei quali si occuperà dell'addestramento di un sistema di intelligenza artificiale mentre l'altro gestirà l'inferenza, ossia il modo in cui gli algoritmi di IA e machine learning vengono effettivamente utilizzati nelle situazioni del mondo reale.

Il Nervana NNP-T, nome in codice Spring Crest, è il chip di training, da cui la T nel suo nome. Il chip è dotato di 24 cluster di elaborazione Tensor progettati appositamente per alimentare reti neurali, quali un'architettura di memoria HBM2 ad alta efficienza, 60 MB di memoria distribuita e fino a 119 TOPS (operazioni teoriche al secondo).

In sostanza, questo è un SoC progettato per fornire tutti i bit per addestrare efficacemente un sistema IA su hardware dedicato, piuttosto che provare a farlo con processori di calcolo generali come le CPU Xeon di Intel.

Il Nervana NNP-I , nome in codice Spring Hill, è il SoC di inferenza. Utilizza la tecnologia di processo a 10 nanometri di Intel e viene fornito con core Ice Lake per mettere in azione sistemi di IA addestrati. Ci sono altre novità come il supporto per quattro moduli LPDDR4x da 64 GB per la larghezza di banda della memoria ad alta velocità e 12 motori di calcolo, per far funzionare i modelli di intelligenza artificiale.

L'idea di entrambi i SoC è che Intel offrirà chip progettati per gestire i carichi di lavoro di intelligenza artificiale negli ambienti dei data center.

Quindi Nervana può essere visto come un rivale di unità di elaborazione tensoriale di Google, basata su hardware Nvidia e chip AWS Inferentia di Amazon.

Ciò che è interessante è che la tecnologia dei SoC potrebbe passare ai futuri processori Core, con CPU al lavoro su aree dedicate per svolgere attività di apprendimento automatico a livello locale, come il riconoscimento vocale e la visione artificiale sui prossimi computer portatili.