Se anche il navigatore sapesse la strada meglio di voi, e vi potesse offrire un percorso alternativo migliore, fareste comunque di testa vostra? E se vi potesse spiegare perché è meglio seguire il suo consiglio, lo ignorereste, tirando dritto per quella che secondo voi è la scelta giusta?

Ad approfondire la questione è stato l'Esercito degli Stati Uniti, le cui alte cariche stanno valutando l'idea di inserire sistemi di Intelligenza Artificiale per aiutare soldati e ufficiali a prendere decisioni sul campo di battaglia. Un'ipotesi che, però, può funzionare solo le persone si fidano della macchina.

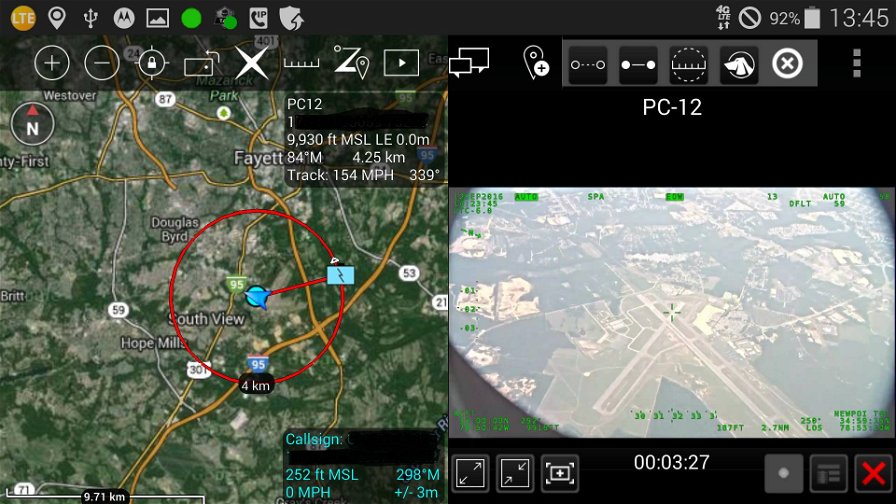

In particolare, si sta lavorando al progetto ATAK (Android Tactical Assault Kit), un sistema per portare agli smartphone dei militari informazioni intelligenti in tempo reale. L'iniziativa sta assorbendo fondi notevoli, ma secondo il ricercatore James Schaffer, è necessario colmare le lacune nelle conoscenze del personale, in particolare per quanto riguarda i sistemi AI. E questo rende difficile prevedere quanto questi sistemi possano risultare utili.

Se si tratta di trovare un ristorante, magari in una città che non conosciamo, possiamo anche fidarci degli algoritmi. Ma Schaffer e i suoi colleghi vorrebbero trovare una "fiducia di livello militare", qualcosa che possa funzionare bene quanto gli algoritmi di Amazon funzionano con i compratori, ma con soldati e ufficiali.

L'ipotesi alla base della ricerca, che l'esercito ha sviluppato in collaborazione con l'Università della California, è che molte persone, probabilmente la maggior parte di noi, si fida più delle proprie abilità e competenze che di un computer - l'esempio del navigatore a riguardo è abbastanza facile da capire.

Secondo Schaffer tale convinzione è così forte e radicata che alcuni non ascolterebbero i consigli degli algoritmi anche se si riuscisse a svilupparne di perfetti - cioè capaci di dare consigli a prova di errore. Il che renderebbe tutto lo sforzo di svilupparli pressoché inutile.

A tale conclusione di è giunti anche tramite una ricerca online: ai partecipanti era proposta una variante del dilemma del prigioniero, una versione ludica nella quale si ottengono punti prendendo decisioni corrette e vantaggiose. Ogni giocatore può contare su un algoritmo che offre consigli, da attivare manualmente. Alcuni di questi assistenti virtuali erano imprecisi, mentre altri erano in grado di spiegare le proprie scelte razionalmente. Questi ultimi sistemi sono quelli più interessanti: davano consigli corretti e li spiegavano - ma con un successo molto scarso. Molte persone, infatti, finivano per prendere decisioni in disaccordo con le AI.

"Due terzi delle decisioni umane erano in disaccordo con l'AI, qualsiasi fosse il numero di errori nei suggerimenti", spiega Schaffer. Più il giocatore si considerava abile ed esperto nelle questioni proposte dal gioco, meno tendeva a usare l'assistente - anche nei casi in cui i suggerimenti automatizzati erano di alta qualità.

"Questo non sarebbe un problema se le persone avessero in effetto ottenuto risultati migliori, ma in verità stavano facendo molto peggio dei loro colleghi più umili, (cioè quelle persone) che hanno ammesso di saperne meno sul gioco prima di cominciare", spiega Schaffer.

Insomma, gli operatori esperti finiscono per essere vittime della propria arroganza. E lo scenario fantascientifico di un soldato assistito da un Intelligenza Artificiale finisce per sembrare un ritratto molto più prosaico, con l'individuo che si sente "più bravo" e che va avanti per la sua strada, a testa bassa, ignorando stimoli potenzialmente positivi. L'eccesso di confidenza, un vecchio problema per il genere umano, si ripresenta nel rapporto con le macchine.

Si tratta in altre parole dell'effetto Dunning-Kruger, che descrive "una distorsione cognitiva a causa della quale individui poco esperti in un campo tendono a sopravvalutare le proprie abilità autovalutandosi, a torto, esperti in quel campo. Come corollario di questa teoria, spesso gli incompetenti si dimostrano estremamente supponenti" (Wikipedia).

Una situazione da comma 22, che i poveri progettisti dovranno in qualche modo affrontare: gli utenti meno competenti, quelli che più di tutti avrebbero bisogno di un assistente AI, sono anche quelli più difficili da convincere con argomentazioni razionali. Intervistati dopo il gioco, questi utenti sono anche quelli che affermano di essersi fidati delle AI, una dichiarazione "in netto contrasto" con quanto osservato durante il test, continua Schaffer. "A dimostrazione che le persone non sono sempre oneste, o non sono sempre consapevoli del proprio comportamento".

La ricerca segna quindi un punto fermo nello sviluppo degli algoritmi. Crearne di più trasparenti, in grado di spiegare le proprie decisioni, potrebbe essere utile a soddisfare normative come il GDPR, ma non è detto che serva ad altro. "Le argomentazioni razionali si sono dimostrate inefficaci con alcune persone", nota Schaffer.

Una dimostrazione di cui bisognerà tenere conto nei progetti futuri - anche se pare che Google, Amazon o Apple abbiano già capito in che direzione muoversi per creare assistenti emotivamente funzionali. Oppure si potrebbero sviluppare sistemi che in qualche modo fingano di non essere degli algoritmi.

"Nonostante queste sfide sul piano dell'interazione uomo-macchina, i sistemi AI saranno parte integrante nella strategia dell'esercito dei prossimi cinque anni", conclude lo scienziato. "Una delle sfide principali nelle operazioni militari odierna è rispondere velocemente alle operazioni dio guerriglia, che spesso hanno una catena di comando più corta e possono agire e reagire più velocemente delle Forze Armate statunitensi. Sistemi complessi che possano reagire velocemente a un ambiente cangiante, e creare un rapido flusso di informazioni, possono migliorare i tempi di risposta e aiutare a mantenere la tempestività delle operazioni, ma solo se gli utenti si fidano abbastanza".