Durante il Computex 2023 tenutosi a Taipei, Jensen Huang, CEO di Nvidia, ha dato l'annuncio che i superchip Grace Hopper sono attualmente in piena fase di produzione. Ha inoltre evidenziato che la piattaforma Grace ha ottenuto sei successi significativi nel campo dei supercomputer. Questi chip sono un componente essenziale di un'altra importante rivelazione di Huang al Computex 2023: la nuova piattaforma di supercomputing DGX GH200 AI di Nvidia, appositamente sviluppata per carichi di lavoro di intelligenza artificiale generativa di grandi dimensioni, è ora disponibile. La piattaforma è dotata di 256 superchip Grace Hopper che lavorano in sinergia, creando una potente centralina di supercomputing con una memoria condivisa di 144 TB, ideale per le attività di addestramento dell'intelligenza artificiale generativa più complesse. Nvidia può già contare su clienti di rilievo come Google, Meta e Microsoft, pronti ad adottare questi sistemi all'avanguardia.

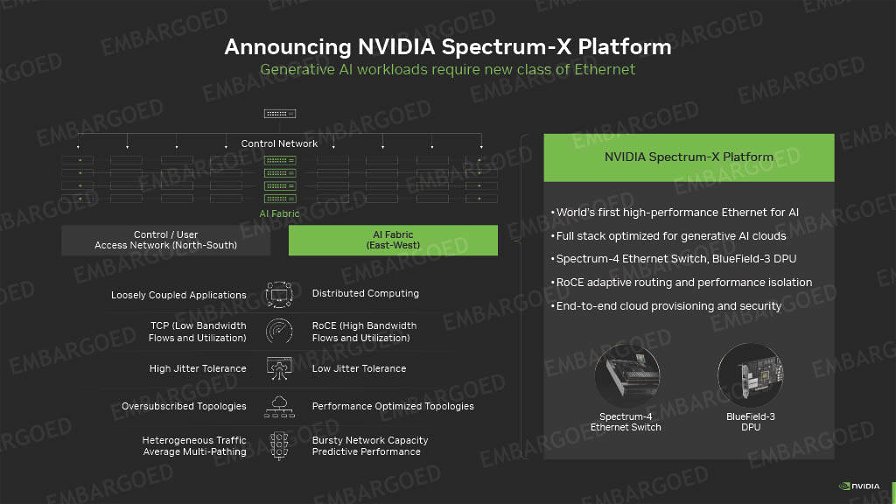

Nvidia ha altresì presentato le sue nuove architetture di riferimento MGX, mirate a velocizzare la creazione di nuovi supercomputer basati sull'intelligenza artificiale, con oltre 100 sistemi disponibili. Infine, l'azienda ha annunciato la sua innovativa piattaforma di rete Ethernet Spectrum-X, progettata e ottimizzata specificamente per i server AI e i cluster di supercomputing.

Superchip Nvidia Grace Hopper ora in produzione

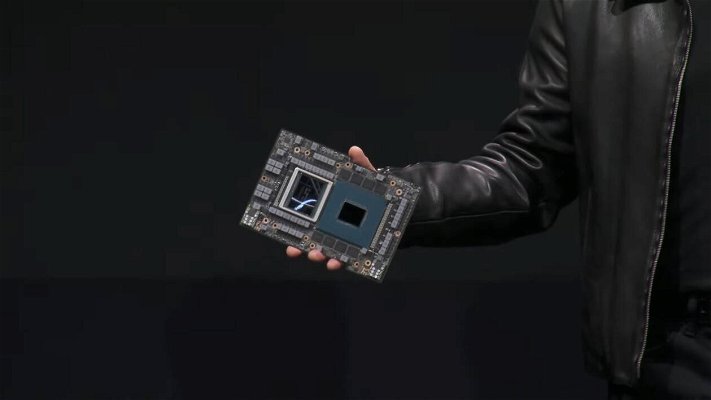

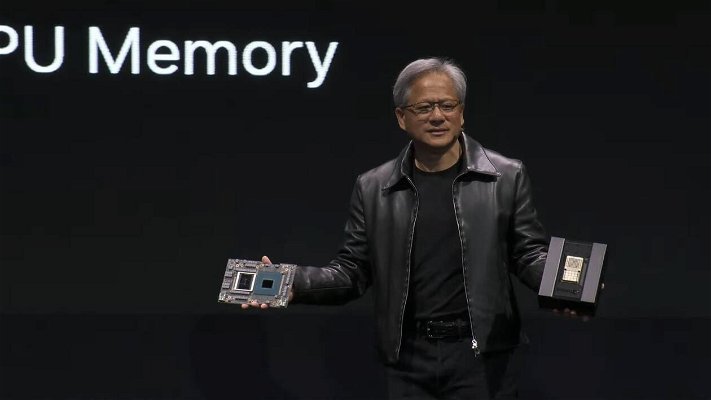

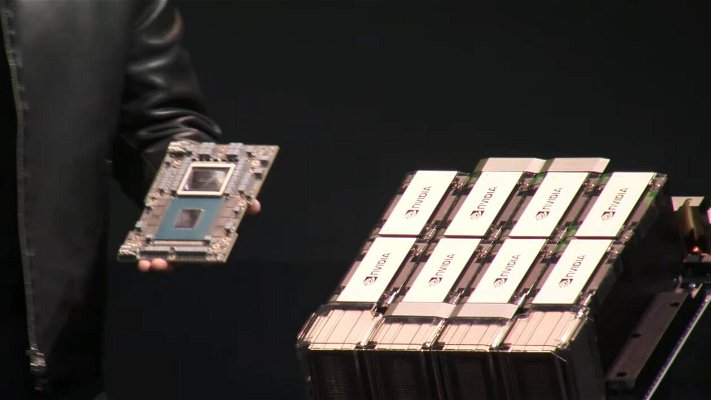

In precedenza abbiamo discusso in dettaglio dei potenti chip Grace e Grace Hopper. Oggi, Nvidia ha annunciato i nuovi sistemi che ruotano attorno a questi chip. Il chip Grace di Nvidia è un processore Arm dedicato alla sola CPU, mentre il superchip Grace Hopper unisce la CPU Grace a 72 core, una GPU Hopper, 96 GB di HBM3 e 512 GB di LPDDR5X, il tutto racchiuso in un unico pacchetto che contiene ben 200 miliardi di transistor. Questa combinazione offre un'incredibile capacità di trasmissione dei dati tra CPU e GPU, con un throughput che può raggiungere fino a 1 TB/s. Ciò conferisce un enorme vantaggio per carichi di lavoro legati alla memoria specifici.

Ora che i potenti superchip Grace Hopper sono entrati in piena produzione, possiamo prevedere che una varietà di partner di Nvidia, tra cui Asus, Gigabyte, ASRock Rack e Pegatron, inizieranno a produrre sistemi basati su questi chip. Tuttavia, ciò che è ancora più significativo è che Nvidia sta anche lanciando i propri sistemi che sfruttano i nuovi chip e sta fornendo architetture di riferimento per OxM (Original Equipment Manufacturer) e hyperscaler, di cui discuteremo dettagliatamente più avanti.

Il Supercomputer Nvidia DGX GH200

I sistemi DGX di Nvidia sono il sistema e l'architettura di riferimento per i carichi di lavoro AI e HPC più impegnativi, ma gli attuali sistemi DGX A100 sono limitati a otto GPU A100 che lavorano in tandem come un'unica unità. Data l'esplosione dell'IA generativa, i clienti di Nvidia sono desiderosi di sistemi molto più grandi e con maggiori prestazioni, e il DGX H200 è progettato per offrire il massimo del throughput per una scalabilità massiccia nei carichi di lavoro più grandi, come l'addestramento dell'IA generativa, i modelli linguistici di grandi dimensioni, i sistemi di raccomandazione e l'analisi dei dati, aggirando le limitazioni delle opzioni di connettività standard dei cluster, come InfiniBand ed Ethernet, con lo switch personalizzato di Nvidia NVLink.

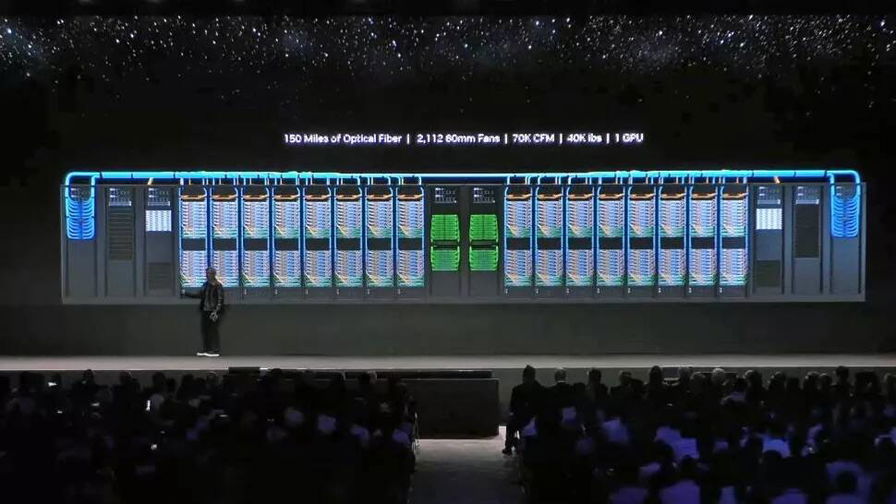

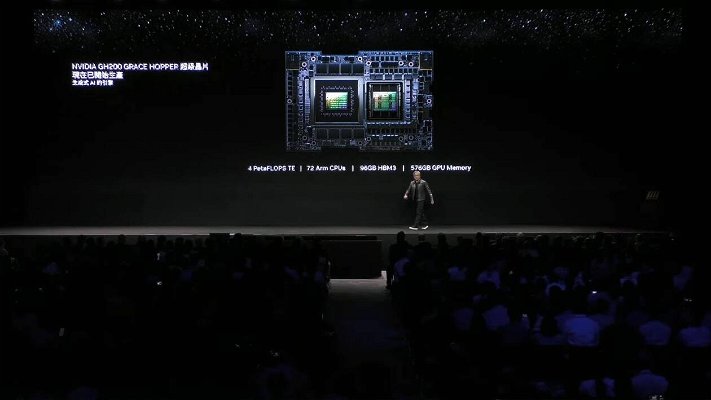

I dettagli precisi del nuovo supercomputer DGX GH200 AI sono ancora pochi, ma sappiamo che Nvidia utilizza un nuovo sistema di switch NVLink con 36 switch NVLink per collegare 256 chip GH200 Grace Hopper e 144 TB di memoria condivisa in un'unità coesa che sembra e agisce come un'unica enorme GPU. Il nuovo sistema di switch NVLink si basa sul silicio NVLink Switch, giunto alla terza generazione.

Il DGX GH200 è dotato di un totale di 256 CPU+GPU Grace Hopper, superando facilmente il più grande sistema DGX di Nvidia collegato a NVLink con otto GPU, e i 144 TB di memoria condivisa sono 500 volte di più rispetto ai sistemi DGX A100 che offrono solo 320 GB di memoria condivisa tra otto GPU A100. Inoltre, l'espansione del sistema DGX A100 a cluster con più di otto GPU richiede l'impiego di InfiniBand come interconnessione tra i sistemi, il che comporta una penalizzazione delle prestazioni. Al contrario, con il DGX GH200 è prima volta che Nvidia ha costruito un intero cluster di supercomputer attorno alla topologia NVLink Switch, che secondo Nvidia fornisce una larghezza di banda da GPU a GPU fino a 10 volte superiore e da CPU a GPU fino a 7 volte rispetto al sistema di generazione precedente. È inoltre progettata per fornire un'efficienza energetica dell'interconnessione 5 volte superiore rispetto alle interconnessioni della concorrenza e fino a 128 TB/s di larghezza di banda bisezionale.

Il sistema ha 150 miglia di fibra ottica e pesa circa 18 tonnellate, ma si presenta come una singola GPU. Nvidia afferma che i 256 Superchip Grace Hopper spingono il DGX GH200 a un exaflop di "prestazioni AI", il che significa che il valore è misurato con tipi di dati più piccoli, più rilevanti per i carichi di lavoro AI rispetto alle misurazioni FP64 utilizzate nell'HPC e nel supercomputing. Queste prestazioni sono garantite da 900 GB/s di larghezza di banda da GPU a GPU, una scalabilità davvero impressionante se si considera che Grace Hopper raggiunge un massimo di 1 TB/s di throughput con la CPU Grace quando sono collegate direttamente sulla stessa scheda con l'interconnessione del chip NVLink-C2C.

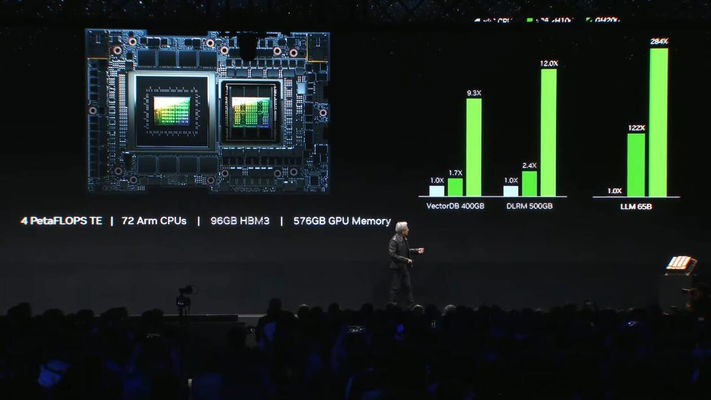

Nvidia ha fornito dei benchmark proiettati del DGX GH200 con il sistema NVLink Switch in un testa a testa con un cluster DGX H100 collegato con InfiniBand. Nvidia ha utilizzato un numero variabile di GPU per i calcoli dei carichi di lavoro, da 32 a 256, ma ogni sistema ha impiegato lo stesso numero di GPU per ogni test. Come si può vedere, l'enorme incremento nelle prestazioni di interconnessione dovrebbe sbloccare valori da 2,2 a 6,3 volte superiori.

Nvidia fornirà i benchmark di riferimento del DGX GH200 ai suoi principali clienti, Google, Meta e Microsoft, entro la fine del 2023, e fornirà inoltre il sistema come architettura di riferimento per i fornitori di servizi cloud e gli hyperscaler.

L'architettura di riferimento dei sistemi Nvidia MGX

Mentre il sistema DGX di Nvidia rappresenta il vertice della gamma, i sistemi HGX sono specificamente progettati per gli hyperscaler. Tuttavia, i nuovi sistemi MGX fungono da punto di mezzo tra DGX e HGX, e coesisteranno insieme a questi due sistemi.

I partner di Nvidia, noti come OxM, si trovano di fronte a nuove sfide nella progettazione e nell'implementazione dei server dedicati all'intelligenza artificiale, il che rallenta il processo. Le nuove architetture di riferimento MGX di Nvidia sono state sviluppate per accelerare questo processo, offrendo oltre 100 progetti di riferimento. I sistemi MGX includono progetti modulari che coprono una vasta gamma di CPU e GPU, DPU e sistemi di rete di Nvidia, ma comprendono anche progetti basati su processori x86 e Arm comuni utilizzati negli attuali server. Inoltre, Nvidia offre opzioni per progetti con sistemi di raffreddamento ad aria o a liquido, consentendo ai partner OxM di avere molteplici possibilità di progettazione per una varietà di applicazioni.

È importante notare che i principali sistemi di QCT e Supermicro di Nvidia continueranno a utilizzare i potenti Superchip Grace e Grace Hopper. Tuttavia, è probabile che i sistemi basati su architettura x86 abbiano una gamma più ampia di opzioni disponibili nel tempo. Aziende come Asus, Gigabyte, ASRock Rack e Pegatron adotteranno le architetture di riferimento MGX per i loro sistemi, che saranno commercializzati entro la fine dell'anno o l'inizio del prossimo.

I progetti di riferimento MGX rappresentano uno degli annunci più significativi della conferenza stampa di Nvidia al Computex. Questi sistemi saranno quelli adottati dai data center e dalle aziende più diffuse per le loro implementazioni basate sull'intelligenza artificiale, e saranno distribuiti in numeri molto più elevati rispetto ai sistemi DGX, che sono più esclusivi e costosi. I sistemi MGX rappresentano l'opzione su larga scala. Nvidia sta ancora finalizzando le specifiche, che saranno rese pubbliche, e presto rilascerà un whitepaper informativo.

Piattaforma di rete Nvidia Spectrum-X

L'acquisizione di Mellanox da parte di Nvidia si è rivelata una mossa strategica per l'azienda, consentendo di ottimizzare e personalizzare i componenti e il software di rete per le proprie esigenze nel campo dell'intelligenza artificiale. Un esempio tangibile di questa capacità è rappresentato dalla nuova piattaforma di rete Spectrum-X, definita da Nvidia come "la prima piattaforma di rete Ethernet ad alte prestazioni per l'IA" al mondo.

Un punto chiave è la scelta di Nvidia di adottare Ethernet come opzione di connessione per le piattaforme ad alte prestazioni nell'ambito dell'intelligenza artificiale, superando l'uso tradizionale di connessioni InfiniBand in tali sistemi. Il progetto Spectrum-X fa uso degli switch Ethernet Spectrum-4 di Nvidia, con una velocità di 400 GbE e una capacità di 51 Tb/s, insieme alle unità di elaborazione dati (DPU) Bluefield-3 di Nvidia. L'intero sistema è supportato da software e SDK che consentono agli sviluppatori di ottimizzare i sistemi per i carichi di lavoro specifici dell'intelligenza artificiale. A differenza di altri sistemi Ethernet, Nvidia afferma che Spectrum-X offre una connessione senza perdite, garantendo una migliore qualità del servizio e una minore latenza. Inoltre, introduce una nuova tecnologia di routing adattivo particolarmente vantaggiosa in ambienti multi-tenancy.

La piattaforma di rete Spectrum-X rappresenta un elemento fondamentale nel portafoglio di Nvidia, poiché consente di portare le capacità di cluster AI ad alte prestazioni alla rete Ethernet, aprendo nuove possibilità per l'adozione diffusa dell'intelligenza artificiale nelle infrastrutture hyperscale. La piattaforma Spectrum-X è completamente interoperabile con gli stack Ethernet esistenti e offre un'elevata scalabilità, con la possibilità di gestire fino a 256 porte da 200 Gb/s su uno switch singolo o 16.000 porte in una topologia leaf-spine a due livelli.

La piattaforma Nvidia Spectrum-X, insieme ai suoi componenti correlati, come gli ottici LinkX 400G, sono disponibili immediatamente per l'acquisto.

I superchip Grace e Grace Hopper di Nvidia vincono nel supercalcolo

Le nuove CPU Arm di Nvidia, chiamate Grace, sono già entrate in fase di produzione e hanno già fatto sentire la loro presenza con l'implementazione in tre recenti supercomputer. Uno di questi supercomputer è il Taiwania 4, annunciato di recente, che sarà costruito da ASUS per conto del Taiwan National Center for High-Performance Computing. Questo potente sistema sarà equipaggiato con 44 nodi di CPU Grace e secondo Nvidia, una volta operativo, sarà uno dei supercomputer più efficienti dal punto di vista energetico in Asia. Il principale scopo di questo supercomputer sarà quello di affrontare i problemi legati al cambiamento climatico attraverso la modellazione e la simulazione.